Les embeddings de texte codent-ils parfaitement le texte ? vec2text révèle une inversion de haute fidélité

Sources: https://thegradient.pub/text-embedding-inversion, thegradient.pub

TL;DR

- Les embeddings de texte peuvent être inversés pour récupérer le texte avec une fidélité substantielle à l’aide d’une méthode nommée vec2text.

- Dans un cadre contrôlé avec 32 tokens encodés en vecteurs de 768 dimensions (~3 kB), une reconstruction précise émerge après une optimisation itérative : environ 92% de correspondance exacte et un score BLEU proche de 97.

- Les résultats soulèvent des questions de confidentialité et de sécurité pour les bases de données vectorielles qui stockent des embeddings plutôt que le texte, car les vecteurs d’embedding peuvent révéler du texte lisible.

- Cela remet en cause l’hypothèse selon laquelle les embeddings seraient des représentations strictement perdues et souligne la nécessité de réévaluer la sécurité des données autour des données incorporées.

Contexte et arrière-plan

Les systèmes de Récupération Améliorée par Génération (RAG) répondent aux questions en récupérant des documents d’une base de textes, puis en générant des réponses éclairées par ces documents. Les embeddings jouent un rôle central, visant à capturer la similarité sémantique afin que les documents pertinents se trouvent près les uns des autres dans l’espace d’embedding. Les bases de données vectorielles stockent des vecteurs d’embedding, pas les textes; le texte sous-jacent reste caché derrière les nombres stockés. Cette configuration soulève des questions sur ce qui peut être récupéré à partir des embeddings si quelqu’un y accède. La question centrale demeure : input text peut‑il être récupéré à partir des embeddings de sortie ? Les travaux EMNLP 2023 discutent exactement ce point dans Text Embeddings Reveal As Much as Text. Dans cet espace, l’inégalité de traitement des données rappelle que les fonctions ne créent pas d’information nouvelle sur l’entrée; elles laissent soit la même, soit la diminuer. Des non linéarités comme ReLU contribuent à compresser l’information. L’idée d’inverser des représentations apprises n’est pas nouvelle en IA. En vision par ordinateur, des études ont montré que des représentations de caractéristiques profondes peuvent être inversées pour reconstruire des images avec une fidélité variable, et des résultats initiaux montrent des reconstructions floues mais reconnaissables à partir des caractéristiques. L’étude actuelle explore si une inversion similaire est possible pour les embeddings de texte et, le cas échéant, avec quelle fidélité. Pour une exploration concrète, les auteurs considèrent une configuration toy : 32 tokens sont encodés en vecteurs de 768 dimensions (32 × 768 = 24 576 bits, environ 3 ko). La question est de savoir s’il est possible de reconstruire parfaitement le texte d’origine à partir de cet embedding fixe. Ils commencent par définir une métrique pratique : une correspondance exacte (le texte récupéré est exactement identique à l’entrée). Dans leur approche initiale, ils entraînent un transformeur pour mapper les embeddings vers le texte, obtenant un BLEU d’environ 30/100 et une correspondance exacte proche de zéro, montrant la difficulté d’une inversion parfaite en une seule passe. L’observation clé est que le texte hypothèse, lorsqu’il est réembeddé, est souvent très proche de l embedding d’origine. Les auteurs rapportent une similarité cosinus d’environ 0,97 entre l embedding de l’hypothèse et l embedding d’origine, indiquant un alignement substantiel dans l’espace d’embedding même lorsque le texte exact n’est pas identique. Les auteurs proposent ensuite de formuler l’inversion comme un problème d’optimisation dans l’espace d’embedding. Étant donné un embedding de référence, un texte hypothèse actuel et la position de l’hypothèse dans l’espace d’embedding, un modèle correcteur apprendu est formé pour générer un texte qui se rapproche davantage du ground truth. Cette approche est décrite comme une forme d’“optimisation apprise” qui avance par des pas discrets dans l’espace d’embedding. C’est l’essence de leur méthode, vec2text.

Ce qui est nouveau

L’approche vec2text produit des améliorations marquantes par rapport à l’inversion initiale. Un seul passage de correction augmente le BLEU de ~30 à ~50, indiquant une correspondance nettement meilleure avec le texte ground truth. De plus, l’approche est naturellement récursive : avec un texte actuel et son embedding, on peut effectuer de nombreuses itérations, réembedding chaque hypothèse et les réintroduire dans le modèle. Avec suffisamment d’iterations (les auteurs citent 50 pas, avec quelques astuces), ils atteignent environ 92% de reconstruction exacte pour des séquences de 32 tokens et un BLEU d’environ 97. Ces résultats suggèrent que, dans ce cadre, les embeddings peuvent être inversés avec une fidélité élevée. L’étude discute aussi d’une implication pratique : la taille fixe d’un vecteur embedding impose une limite fondamentale de capacité d’information. Il y a une frontière où l’information ne peut plus être stockée parfaitement dans un embedding donné, même si de nombreuses mots peuvent être récupérés dans ce cadre toy. Cela souligne le dilemme entre utilité des embeddings et confidentialité des données dans des systèmes réels.

Pourquoi cela compte (impact pour les développeurs/entreprises)

La possibilité d’inverser les embeddings soulève des questions de sécurité et de confidentialité pour les organisations qui stockent des textes sous forme d’embeddings dans des bases de données vectorielles. Si quelqu’un accède aux vecteurs d’embedding, il pourrait exister une voie plausible pour reconstruire des informations lisibles, en particulier pour des textes courts ou modérés. Cela est particulièrement important pour des documents clients sensibles protégés par des politiques de confidentialité, où le texte brut peut être remplacé par des embeddings. Du point de vue d’entreprise, cela invite à réévaluer les modèles de menace, les contrôles d’accès et la gouvernance des données autour des embeddings. Bien que l’étude ne proclame pas une applicabilité universelle à tous les embeddings et toutes les longueurs, elle montre qu’un embedding fixe peut contenir suffisamment d’information pour reconstruire une grande partie du texte original dans certaines conditions, soulevant des préoccupations de confidentialité lorsque les embeddings sont utilisés dans des pipelines de recherche et récupération. Pour les développeurs construisant des systèmes RAG, ces résultats soulignent la nécessité d’examiner ce qui est encodé dans les embeddings et comment l’accès à ces embeddings pourrait être abusé. Ils appellent aussi à poursuivre l’évaluation des propriétés de sécurité des embeddings et à envisager des stratégies de traitement sur l’appareil ou cryptées lorsque cela est possible.

Détails techniques ou Mise en œuvre (comment fonctionne vec2text)

- L’approche de base utilise un transformeur qui accepte un embedding en entrée et est entraîné avec des objectifs de modélisation de texte sur le texte correspondant. La version initiale donne un BLEU d’environ 30/100 et une correspondance exacte quasi nulle, montrant la difficulté de l’inversion en une seule passe.

- Un point diagnostic clé est que le texte hypothèse, réemballé, se retrouve souvent très proche de l’embedding d’origine (similarité cosinus près de 0,97), indiquant un alignement substantiel dans l’espace d’embedding même lorsque le texte exact n’est pas identique.

- Ensuite, les auteurs conçoivent un mécanisme correcteur : donné un embedding de référence, un texte hypothèse et la position de l’hypothèse dans l’espace d’embedding, un modèle correcteur appris est entraîné pour générer un texte qui se rapproche davantage du ground truth.

- En pratique, un seul passage de correction augmente le BLEU de ~30 à ~50, et l’application itérative (50 pas) permet d’atteindre environ 92% de reconstruction exacte pour des séquences de 32 tokens et un BLEU d’environ 97. Cela suggère que, sous des conditions contrôlées, les embeddings peuvent être inversés avec une fidélité élevée.

- L’approche réutilise le cadre d’inversion comme une série de mises à jour dans l’espace d’embedding guidées par des modifications discrètes de texte, permettant un raffinement récursif : générer une hypothèse, réembedder, réintroduire dans le modèle et itérer jusqu’à convergence.

Points clés à retenir

- Les embeddings peuvent être inversés pour récupérer une grande partie du contenu textuel pour des entrées courtes, en utilisant une optimisation apprise dans l’espace d’embedding.

- Un modèle d’appariement embedding‑texte, associé à une boucle de correction, produit des reconstructions de haute fidélité avec une forte similarité d’embedding entre le texte récupéré et l’original.

- Des implications directes de sécurité et de confidentialité pour les bases de données vectorielles stockant des embeddings plutôt que le texte.

- Il semble y avoir un compromis entre la capacité fixe d’un embedding et la capacité de stocker l’information, ce qui renforce la nécessité d’une gouvernance des données attentive autour des embeddings.

FAQ

-

Qu’est-ce que vec2text ?

vec2text est une approche d’optimisation apprise qui reçoit un embedding de référence et un texte hypothèse pour générer un texte qui s’approche du ground truth dans l’espace d’embedding.

-

Est‑ce que les embeddings peuvent être inversés en texte ?

L’étude montre que, dans un cadre contrôlé avec 32 tokens et des embeddings à 768 dimensions, une inversion proche de la parfaite est possible après des itérations, bien que la récupération exacte en une seule passe soit difficile.

-

uelle est la précision de l’inversion ?

BLEU initial autour de 30, correspondance exacte presque zéro; après correction et itérations, BLEU près de 97 et reconstruction exacte d’environ 92% pour 32 tokens.

-

uelles sont les implications de sécurité pour les entreprises ?

Si les embeddings peuvent être inversés en texte lisible, l’accès aux vecteurs peut conduire à des fuites d’informations sensibles, nécessitant une révision de la gouvernance, de la confidentialité et des contrôles d’accès autour des embeddings.

Références

More news

Simplifier l accès aux changements de contenu ISO-rating avec Verisk Rating Insights et Amazon Bedrock

Verisk Rating Insights, propulsé par Amazon Bedrock, LLM et RAG, offre une interface conversationnelle pour accéder aux changements ERC ISO, réduisant les téléchargements manuels et accélérant les informations fiables.

Automatiser des pipelines RAG avancés avec Amazon SageMaker AI

Optimisez l’expérimentation jusqu’à la production pour le RAG (Retrieval Augmented Generation) avec SageMaker AI, MLflow et Pipelines, afin d’obtenir des flux reproductibles, évolutifs et gouvernés.

Déverrouillez les insights du modèle grâce au support des probabilités de log pour l’importation de modèle personnalisé Amazon Bedrock

Explique les probabilités de log au niveau des tokens pour les modèles importés, comment les activer et leurs cas d’usage pratiques.

Déployer une inférence IA scalable avec NVIDIA NIM Operator 3.0.0

NVIDIA NIM Operator 3.0.0 étend l’inférence IA scalable sur Kubernetes, avec déploiements multi-LLM et multi-nœud, intégration KServe et support DRA en version technologique, en collaboration avec Red Hat et NeMo Guardrails.

Déployer les bases de connaissances Amazon Bedrock avec Terraform pour les applications IA génératives basées sur le RAG

Automatisez le déploiement des bases de connaissances Bedrock et des connexions aux sources de données pour les flux RAG avec un modèle Terraform IaC, afin de gagner en rapidité et en reproductibilité en production.

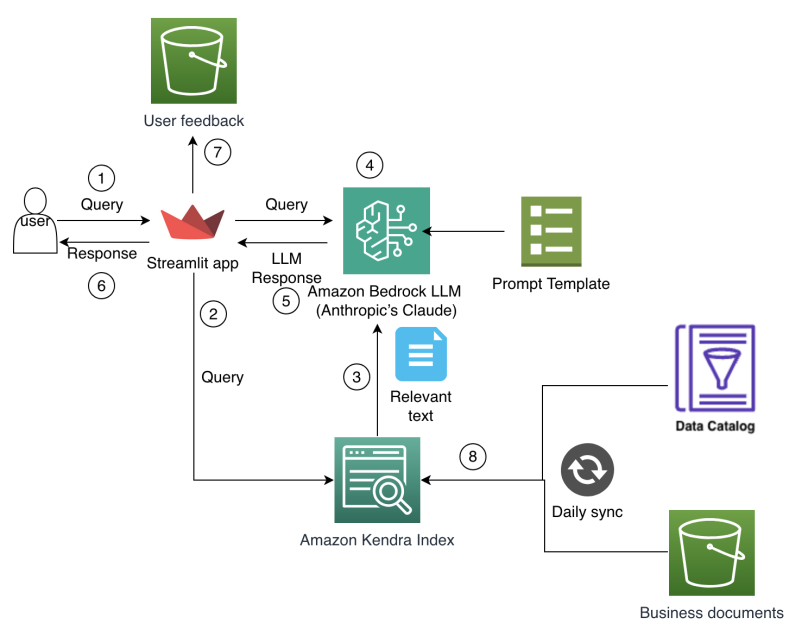

Comment Amazon Finance a construit un assistant IA utilisant Amazon Bedrock et Amazon Kendra pour aider les analystes à la découverte des données et aux insights commerciaux

Amazon Finance détaille un assistant IA qui combine Bedrock et Kendra pour accélérer la découverte des données, préserver le savoir-faire institutionnel et livrer des insights financiers précis à grande échelle.