Pourquoi mon modèle ne fonctionne-t-il pas ? Guide pratique pour éviter les pièges du ML

Sources: https://thegradient.pub/why-doesnt-my-model-work, thegradient.pub

TL;DR

- Les modèles peuvent bien fonctionner sur les données de test et échouer en pratique à cause de problèmes de données et de fuites qui gonflent les métriques.

- Les variables cachées et les motifs fallacieux peuvent amener les algorithmes à apprendre des signaux non pertinents, surtout dans des domaines complexes comme l’imagerie médicale ou la vision par ordinateur.

- Les fuites de données et le biais de regard en avant (look-ahead) sont des sources fréquentes de performances excessivement optimistes, souvent dues à des prétraitements ou à des séparations de séries temporelles inadéquats.

- Des diagnostics simples (par exemple, examiner ce que les modèles utilisent pour décider) et des checklists structurées comme REFORMS aident à prévenir les écueils ML.

- L’article illustre ces pièges avec des exemples concrets tirés de données Covid, de benchmarks d’images et de prévisions de séries chronologiques. Why Doesn’t My Model Work?

Contexte et antécédents

Les processus d’apprentissage automatique sont intrinsèquement complexes, et il est facile d’introduire des erreurs qui conduisent à un surapprentissage ou à des modèles décalés par rapport au monde réel. Au cours des deux dernières décennies, le domaine a connu des échecs répétés lorsque les modèles sont déployés en dehors du régime des données sur lesquelles ils ont été entraînés. L’auteur rappelle que bon nombre de ces échecs font l’objet de rapports dans la presse scientifique et populaire, et que certains chercheurs estiment que ces problèmes alimentent une crise de reproductibilité dans la science. Le texte renvoie également à une discussion plus large sur la prévention des écueils dans la science pilotée par le ML, en mentionnant la checklist REFORMS comme outil pratique pour guider des travaux plus rigoureux. L’importance de données de qualité est soulignée comme base du ML efficace, et les erreurs apparaissent souvent au stade des données, comme dans les jeux de données Covid où des signaux trompeurs ont été identifiés. Les variables cachées et les corrélations fallacieuses sont au cœur des raisons pour lesquelles les modèles peuvent sembler performants sans l’être réellement. Par exemple, dans les ensembles Covid d’imagerie thoracique, l’orientation du corps peut être corrélée au statut maladie parce que les patients malades étaient davantage scannés couchés, ce que le modèle peut exploiter au lieu des marqueurs pathologiques. Si un modèle s’appuie sur ce signal, ses performances réelles seront médiocres. Les corrélations fallacieuses n’ont pas besoin d’être évidentes comme dans des cas caricaturaux; les jeux de données de vision contiennent souvent des motifs de fond qui se lient au label et les modèles profonds peuvent les exploiter, réduisant ainsi la généralisabilité. Ces pièges ne se limitent pas à l’imagerie: ils apparaissent aussi dans les prévisions de séries chronologiques, où le biais de regard en avant peut biaiser l’évaluation si des informations futures sont utilisées pendant l’entraînement. Des revues et études de cas montrent ces pièges dans l’évaluation des modèles de séries temporelles et dans certains prétraitements qui peuvent laisser filtrer des informations du jeu de test dans l’entraînement. Un exemple marquant est celui où des augmentations de données effectuées avant la séparation ont conduit à des jeux de test contenant des échantillons augmentés, gonflant artificiellement les performances et masquant la vraie capacité du modèle. L’article souligne également les répercussions plus larges sur l’intégrité scientifique et la fiabilité des résultats publiés. Lorsque les modèles paraissent exceptionnellement performants à cause de données ou de fuites, la reproductibilité et la confiance dans les résultats scientifiques alimentés par le ML peuvent en pâtir. Face à cela, la checklist REFORMS est présentée comme un outil concret aidant les chercheurs et les développeurs à auditer leurs flux de ML et à réduire les risques d’écueils.

Ce qui est nouveau

Ce n’est pas une nouvelle méthode d’apprentissage, mais un ensemble de rappels pratiques et une checklist structurée visant à améliorer la rigueur scientifique dans les flux ML. L’élément central est la checklist REFORMS destinée à guider la science basée sur le ML en fournissant un cadre pour traiter systématiquement les écueils à chaque étape d’un projet: qualité des données et étiquetage, gestion des features, évaluation du modèle et interprétabilité. Les exemples tirés de Covid, des données d’images et des évaluations de séries temporelles illustrent l’importance de cette checklist. Le message clé est d’être critique à des points critiques, de vérifier les hypothèses et de réaliser des analyses ciblées pour s’assurer que le modèle s’appuie sur des signaux pertinents et non sur des indices non généralisables.

Pourquoi cela compte (impact pour les développeurs/entreprises)

Pour les développeurs, data scientists et organisations qui déploient des systèmes ML, ces écueils signifient un risque réel: des modèles qui semblent excellents en validation mais qui échouent en production, entraînant des gaspillages et une perte de confiance dans les solutions ML. L’article soutient que lorsque les modèles exploitent des signaux cachés ou des fuites de données, les performances rapportées peuvent être élevées sans que cela reflète réellement le pouvoir prédictif utile. Dans des contextes industriels ou réglementaires, cela peut compromettre la qualité des décisions, réduire la reproductibilité entre équipes et affaiblir la crédibilité des résultats pilotés par le ML. En adoptant une gouvernance des données, une évaluation transparente et des pratiques structurées comme la checklist REFORMS, les équipes peuvent réduire le risque de déployer des modèles fragiles et renforcer la robustesse des décisions guidées par ML.

Détails techniques ou Mise en œuvre

Les questions centrales peuvent être regroupées en plusieurs catégories, chacune ayant des implications pratiques pour l’implémentation et l’évaluation:

- Problèmes de qualité des données et signaux trompeurs. Les jeux de données peuvent contenir des enregistrements en double, des étiquettes incorrectes ou des variables cachées qui aident à prédire les étiquettes sans capturer le vrai phénomène. Dans les ensembles Covid, ces problèmes ont conduit à des modèles s’appuyant sur des artefacts plutôt que sur des marqueurs cliniques réels. Pour atténuer, les praticiens doivent examiner la provenance des données, vérifier les étiquettes et vérifier que les caractéristiques ne dépendent pas d’un facteur non pertinent.

- Variables cachées et signaux de frontière. Des signaux intégrés qui distinguent les classes sans relation causale peuvent amener le modèle à s’appuyer sur ces indices, réduisant la généralisation sur de nouvelles données. Des signaux résidant dans des éléments comme des filigranes ou des horodatages peuvent guider la classification sans refléter le vrai phénomène.

- Corrélations fallacieuses. Des motifs qui se corrèlent avec les étiquettes sans lien causal peuvent tromper les modèles, et les modèles profonds ont tendance à capturer une large variété de motifs, ce qui peut nuire à la généralisation lorsque les données changent d’environnement.

- Biais d’étiquetage et subjectivité. Les étiquettes générées par des humains peuvent introduire des biais ou des erreurs qui contaminent l’apprentissage. Les bases de référence connues montrent des taux d’étiquetage incorrects non négligeables, soulevant des questions sur les gains marginaux qui reposent sur des biais de labeling plutôt que sur le signal réel.

- Fuites de données et biais de regard en avant. Le principal problème est l’utilisation d’informations provenant du test ou du futur dans l’entraînement, ce qui gonfle artificiellement les métriques. Des prétraitements utilisant l’ensemble total sans séparation, ou des séries temporelles avec des échantillons futurs dans le training, peuvent introduire ce biais.

- Évaluation et réplication. Comme ces pièges gonflent les métriques, reproduire les résultats peut être difficile sur de nouveaux jeux de données, ce qui met en évidence le besoin d’une évaluation plus rigoureuse et d’une documentation claire.

- Stratégies de mitigation. En plus de l’explicabilité et de l’évaluation rigoureuse, des approches comme l’entraînement adversarial peuvent être considérées lorsque faisable. L’article met l’accent sur l’adoption de la checklist REFORMS comme cadre pratique pour guider les flux de ML, de la collecte des données à l’évaluation.

- Signaux et avertissements. Si le modèle semble particulièrement performant sur des ensembles spécifiques, il convient d’être prudent quant à la généralisabilité et d’enquêter sur les artefacts possibles dans les données et les étiquettes.

Tables: aperçu rapide des pièges courants

| Piège | Signification pour votre projet |

|---|---|

| Variables cachées | Caractéristiques qui prédisent sans refléter le vrai signal causal |

| Corrélations fallacieuses | Motifs qui coïncident avec les étiquettes sans lien causal |

| Fuites de données / biais de regard en avant | Informations du jeu de test ou du futur utilisées pendant l’entraînement |

- Ces problèmes peuvent être atténués par une gouvernance des données soignée, des analyses explicites et l’adoption d’une approche structurée telle que la checklist REFORMS.

Points clés

- L’intégrité des données est primordiale: des données trompeuses, des étiquetages incorrects et des variables cachées peuvent faire croire à une performance réelle plus élevée qu’elle ne l’est.

- Méfiance envers les fuites: les étapes de prétraitement qui utilisent des informations de l’ensemble entier peuvent diffuser des données du test dans l’entraînement et biaiser les résultats.

- Vérifiez si le modèle s’appuie sur des signaux non généralisables: utilisez des outils d’explicabilité pour confirmer que les décisions reposent sur des signaux pertinents.

- Les corrélations fallacieuses sont courantes dans les jeux de référence et peuvent nuire à la généralisation; une évaluation robuste sur des données variées est essentielle.

- Adoptez des processus structurés comme la checklist REFORMS pour guider une science ML plus rigoureuse et reproductible.

FAQ

Références

More news

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Comment msg a renforcé la transformation RH avec Amazon Bedrock et msg.ProfileMap

Cet article explique comment msg a automatisé l'harmonisation des données pour msg.ProfileMap en utilisant Amazon Bedrock pour alimenter des flux d'enrichissement pilotés par LLM, améliorant la précision de l'appariement des concepts RH, réduisant la charge manuelle et assurant la conformité avec l'

Comment la Quantization Aware Training permet de récupérer la précision en inferance à faible précision

Explore QAT et QAD comme méthodes de récupération de précision dans des modèles à faible précision, en s'appuyant sur TensorRT Model Optimizer et les formats FP8/NVFP4/MXFP4.

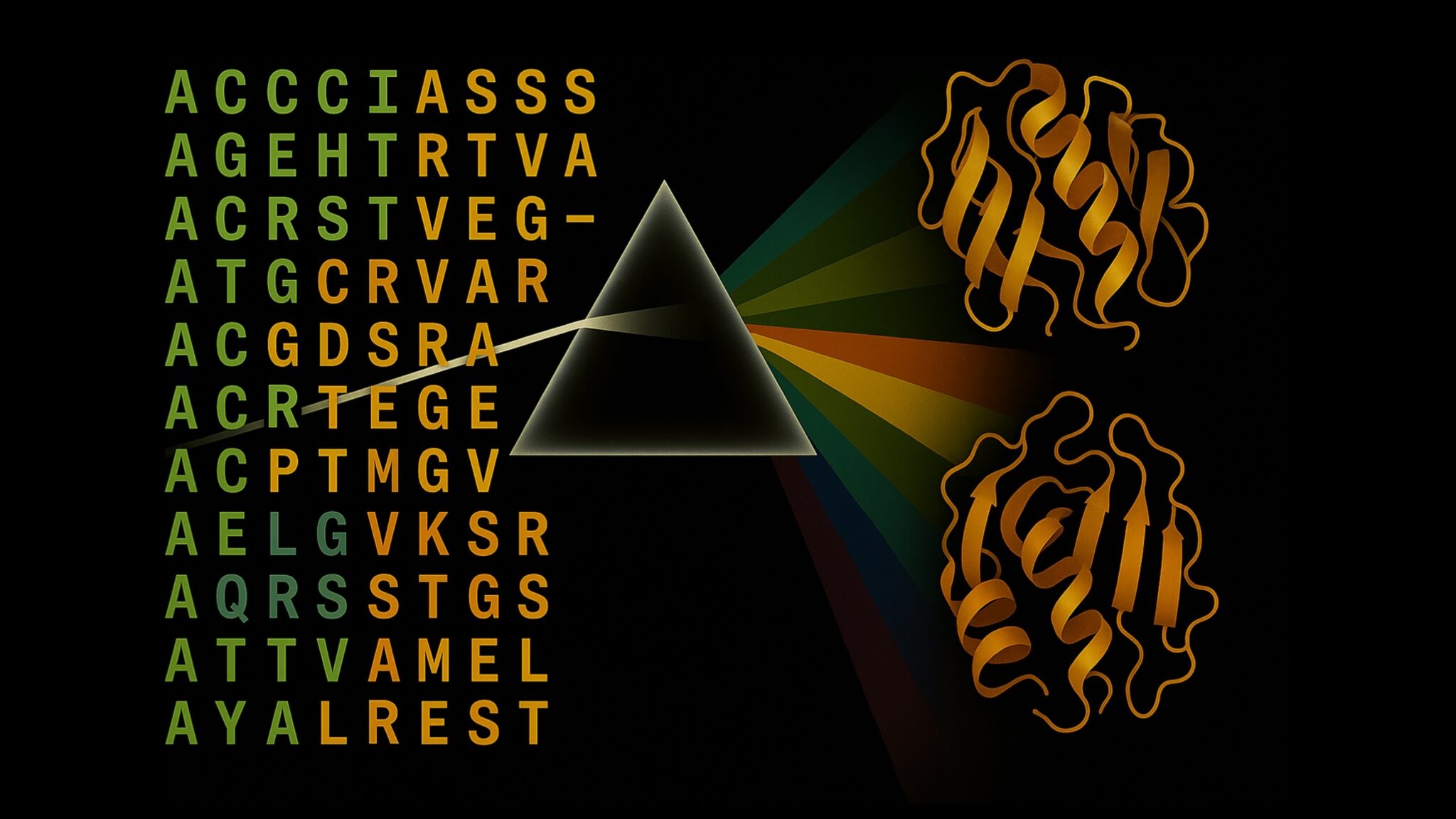

Accélérer l’Inference de la Structure des Protéines de Plus de 100x avec le NVIDIA RTX PRO 6000 Blackwell Server Edition

Le RTX PRO 6000 Blackwell Server Edition de NVIDIA accélère considérablement l’inférence de structure des protéines, permettant des flux de travail GPU complets avec OpenFold et TensorRT, jusqu’à 138x plus rapide que AlphaFold2.

Les checklists surpassent les modèles de récompense pour l’alignement des modèles de langage

Une approche RL utilisant des checklists dérivées des instructions guide l’alignement et surpasse les modèles de récompense fixes sur plusieurs benchmarks du Qwen2.5-7B-Instruct, présentée à l’ICLR 2025.

SlowFast-LLaVA-1.5 : LLMs vidéo économes en jetons pour la compréhension du long terme

La recherche ML d’Apple présente SlowFast-LLaVA-1.5 (SF-LLaVA-1.5), une famille de LLMs vidéo à faible coût en jetons pour la compréhension de vidéos longues, utilisant le mécanisme SlowFast à deux flux et des données publiques pour atteindre des performances de pointe entre 1B et 7B.