Usar AWS Deep Learning Containers con Amazon SageMaker AI MLflow gestionado

Sources: https://aws.amazon.com/blogs/machine-learning/use-aws-deep-learning-containers-with-amazon-sagemaker-ai-managed-mlflow, https://aws.amazon.com/blogs/machine-learning/use-aws-deep-learning-containers-with-amazon-sagemaker-ai-managed-mlflow/, AWS ML Blog

TL;DR

- Integra AWS Deep Learning Containers (DLCs) con SageMaker AI gestionado por MLflow para equilibrar el control de infraestructura y una gobernanza de ML robusta.

- Emplea un flujo TensorFlow para la predicción de la edad de abalones donde el entrenamiento ocurre en DLCs, los artefactos se almacenan en Amazon S3 y los resultados se registran en MLflow para un seguimiento centralizado.

- SageMaker MLflow gestionado ofrece registro automático en una línea, capacidades de comparación mejoradas y trazabilidad completa de linaje para auditoría.

- El enfoque ofrece un equilibrio entre personalización y estandarización, permitiendo a las organizaciones estandarizar flujos de ML manteniendo la flexibilidad de entornos mediante DLCs o DLAMIs.

- Los prerrequisitos incluyen extraer un contenedor de entrenamiento TensorFlow optimizado desde el registro público de AWS ECR y seguir el README del repositorio de GitHub correspondiente para aprovisionar y ejecutar.

Contexto y antecedentes

Las organizaciones que construyen modelos de ML personalizados a menudo tienen requisitos especializados que las plataformas estándar no pueden satisfacer. Por ejemplo, las compañías de salud necesitan entornos específicos para proteger los datos de pacientes y cumplir con HIPAA; las instituciones financieras requieren configuraciones de hardware para optimizar algoritmos de trading propietarios; y los equipos de investigación necesitan flexibilidad para experimentar con técnicas de vanguardia usando frameworks personalizados. Estos requisitos impulsan a los equipos a crear entornos de entrenamiento a medida que les dan control sobre la selección de hardware, las versiones de software y las configuraciones de seguridad. Aunque esa flexibilidad es valiosa, también genera importantes desafíos para la gestión del ciclo de vida del ML, aumentando costos operativos y demandando recursos de ingeniería. Los DLCs de AWS y los MLflow gestionados en SageMaker ofrecen una solución poderosa para abordar tanto el control como la gobernanza. Los DLCs proporcionan contenedores Docker preconfigurados con marcos como TensorFlow y PyTorch, con controladores NVIDIA CUDA para soporte de GPU, optimizados para rendimiento en AWS. Se mantienen actualizados regularmente con las últimas versiones de los marcos y parches, y están diseñados para integrarse con los servicios de AWS para entrenamiento e inferencia. Los DLAMIs son imágenes Amazon Machine Images preconfiguradas para EC2, con marcos populares y disponibles para instancias CPU y GPU, incluyendo CUDA, cuDNN y otras herramientas. Conjuntamente, DLCs y DLAMIs permiten a los practicantes de ML acelerar el entrenamiento a escala en la nube. SageMaker gestionado MLflow ofrece gestión completa del ciclo de vida con registro en una sola línea, trazabilidad de linaje y gobernanza sin la burden operativa de mantener la infraestructura de tracking. La integración aquí presentada demuestra cómo combinar entornos de entrenamiento personalizados con las herramientas de gobernanza de SageMaker para obtener una solución eficiente y gobernada. En el flujo de trabajo descrito, se desarrolla un modelo de red neuronal TensorFlow para la predicción de la edad de abalones con seguimiento integrado de MLflow gestionado por SageMaker. Se extrae un contenedor de entrenamiento TensorFlow optimizado desde el repositorio público de ECR de AWS, se configura una instancia EC2 con acceso al servidor de MLflow y se ejecuta el entrenamiento dentro del DLC. Los artefactos del modelo se almacenan en Amazon S3 y los resultados del experimento se registran en MLflow. Finalmente, se pueden ver y comparar los resultados de los experimentos en la interfaz de MLflow para evaluar el rendimiento del modelo. El diagrama de la solución muestra la interacción entre varios servicios de AWS, DLCs y SageMaker MLflow gestionado para implementar la solución. El flujo describe los pasos desde la provisión de la infraestructura y permisos hasta la ejecución del primer entrenamiento con un seguimiento completo de los experimentos.

Novedades

Este artículo presenta un patrón de integración práctico que equilibra el control de la infraestructura con la gobernanza al combinar DLCs (o DLAMIs) con MLflow gestionado por SageMaker AI. El flujo permite rastrear experimentos de punta a punta, con procedentes de modelos y una trazabilidad directa de entrenamiento a producción, proporcionando un historial auditable de experimentos, métricas, hiperparámetros y artefactos. La solución demuestra cómo:

- Ejecutar entrenamientos en DLCs manteniendo artefactos de modelo de forma segura en S3.

- Registrar métricas de experiments, parámetros y resultados en un servidor MLflow gestionado por SageMaker AI.

- Registrar automáticamente los modelos en SageMaker Model Registry mediante la integración MLflow, creando una trazabilidad directa desde el entrenamiento hasta la producción.

- Usar la interfaz MLflow para comparar ejecuciones, inspeccionar la proveniencia y obtener visibilidad sobre las dinámicas de entrenamiento y la convergencia.

- Establecer un flujo de ML escalable y gobernado que acomode requisitos especializados manteniendo estandarización donde sea posible. El artículo también destaca los prerrequisitos y ofrece referencias a instrucciones detalladas en el README del repositorio de GitHub, garantizando que los equipos puedan aprovisionar la infraestructura y ejecutar su primer entrenamiento con un seguimiento completo de experimentos.

Por qué importa (impacto para desarrolladores/empresas)

Para organizaciones con requisitos de gobernanza estrictos o necesidades de cómputo y seguridad específicas, la capacidad de controlar el entorno de entrenamiento sin sacrificar la gobernanza es crucial. Combinando DLCs (o DLAMIs) con MLflow gestionado por SageMaker AI, los equipos pueden:

- Mantener la flexibilidad necesaria para adaptar entornos a cumplimiento HIPAA, configuraciones de hardware especializadas o experimentación de vanguardia, al tiempo que se benefician de una gobernanza centralizada.

- Lograr un seguimiento completo de las experiencias, trazabilidad de modelos y un historial auditable desde el entrenamiento hasta la producción.

- Acelerar el ciclo de vida de ML reduciendo la carga operativa asociada con el tracking y la gestión de entornos de experimentación.

- Estandarizar flujos de ML entre equipos y proyectos, facilitando la reproducibilidad y la colaboración mientras se mantienen salvaguardas requeridas en industrias reguladas. Este enfoque se alinea con objetivos más amplios de equilibrar personalización y gobernanza en iniciativas empresariales de IA, permitiendo a científicos de datos y equipos de operaciones trabajar con mayor eficiencia sin comprometer la seguridad, la trazabilidad o la conformidad.

Detalles técnicos o Implementación

Elementos clave de la solución descrita incluyen:

- AWS Deep Learning Containers (DLCs): contenedores Docker preconfigurados con frameworks como TensorFlow y PyTorch, incluyendo controladores NVIDIA CUDA para soporte de GPU; DLCs optimizados para AWS y actualizados regularmente. Están diseñados para integrarse con servicios de AWS para entrenamiento e inferencia.

- AWS Deep Learning AMIs (DLAMIs): imágenes AMI preconfiguradas para EC2 con frameworks populares; disponibles para instancias CPU y GPU; incluyen CUDA, cuDNN y otras herramientas necesarias; las actualizaciones son gestionadas por AWS.

- SageMaker MLflow gestionado: ofrece registro automático en una línea, comparaciones mejoradas y trazabilidad de linaje completa en un entorno SageMaker AI gestionado.

- Pasos de implementación (alto nivel):

- Extraer un contenedor TensorFlow optimizado desde el registro público ECR de AWS.

- Configurar una instancia EC2 con acceso al servidor de seguimiento MLflow.

- Ejecutar el entrenamiento dentro del DLC mientras se almacenan artefactos del modelo en Amazon S3 y se registran los resultados en MLflow.

- Ver y comparar resultados de experimentos en la interfaz MLflow para evaluar el rendimiento del modelo.

- Al registrar un modelo con mlflow.tensorflow.log_model() usando el parámetro registered_model_name, el modelo se registra automáticamente en el SageMaker Model Registry, estableciendo una trazabilidad de entrenamiento a producción.

- Los artefactos del modelo se almacenan en S3 siguiendo una estructura estandarizada para asegurar que pesos, configuraciones y metadatos se preserven y sean accesibles.

- Ejemplo práctico: predicción de la edad de abalones con un modelo TensorFlow, mostrando cómo las características de gobernanza y versionado se reflejan en la interfaz y en el registro de modelos.

- Implementación de referencia: todos los ejemplos de código y detalles de implementación se encuentran en el README del repositorio GitHub asociado, que cubre aprovisionamiento, permisos y ejecución del primer entrenamiento con seguimiento completo de experimentos. Como ilustran las imágenes del artículo, SageMaker MLflow gestionado ofrece un centro único para rastrear métricas, parámetros, artefactos y modelos registrados, proporcionando gobernanza completa y una trazabilidad de auditoría para flujos de ML. La integración garantiza que los resultados de entrenamiento puedan vincularse al modelo desplegado en producción, brindando trazabilidad y conformidad a lo largo del ciclo de ML.

conclusiones clave

- DLCs y DLAMIs ofrecen el equilibrio adecuado entre personalización e infraestructura gestionada para flujos de ML en AWS.

- SageMaker AI gestionado MLflow aporta capacidades de gobernanza sólidas, incluyendo registro automático, linaje y registro de modelos.

- El flujo de predicción de edad de abalones con TensorFlow demuestra gobernanza de punta a punta: entrenamiento, almacenamiento de artefactos, comparación de experimentos y despliegue en producción.

- El seguimiento centralizado de MLflow en SageMaker AI simplifica la auditoría, la trazabilidad y la colaboración entre equipos de ciencia de datos y operaciones.

- Este enfoque reduce la carga operativa manteniendo la flexibilidad para requisitos especializados.

Preguntas Frecuentes (FAQ)

- Q: ¿Qué son DLCs y DLAMIs de AWS? A: DLCs son contenedores Docker preconfigurados con frameworks como TensorFlow y PyTorch, que incluyen controladores CUDA de NVIDIA; DLAMIs son imágenes AMI preconfiguradas para EC2. Incluyen CUDA, cuDNN y otras herramientas necesarias, con actualizaciones gestionadas por AWS.

- Q: ¿Cómo ayuda MLflow gestionado por SageMaker a la gobernanza? A: Proporciona gestión completa del ciclo de vida con registro automático en una línea, comparaciones mejoradas y trazabilidad de linaje, dentro de un entorno SageMaker AI totalmente gestionado.

- Q: ¿Qué es el ejemplo de abalones utilizado? A: Es un modelo TensorFlow para la predicción de la edad de abalones, utilizado para demostrar el flujo de entrenamiento, registro y gobernanza con MLflow y SageMaker.

- Q: ¿Dónde se almacenan los artefactos y resultados? A: Los artefactos y datos del modelo se almacenan en Amazon S3, mientras que las métricas y parámetros de los experimentos se registran en MLflow para seguimiento centralizado y gobernanza.

- Q: ¿Cómo empezar a implementar este patrón? A: Consulte el README del repositorio GitHub correspondiente para instrucciones detalladas, paso a paso, sobre aprovisionamiento de infraestructura, configuración de permisos y ejecución del primer entrenamiento con gobernanza de experimentos.

Referencias

More news

Llevar agentes de IA de concepto a producción con Amazon Bedrock AgentCore

Análisis detallado de cómo Amazon Bedrock AgentCore facilita la transición de aplicaciones de IA basadas en agentes desde un concepto de prueba hasta sistemas de producción empresariales, conservando memoria, seguridad, observabilidad y gestión escalable de herramientas.

Monitorear la inferencia por lotes de Bedrock de AWS con métricas de CloudWatch

Descubra cómo monitorear y optimizar trabajos de inferencia por lotes de Bedrock con métricas, alarmas y paneles de CloudWatch para mejorar rendimiento, costos y operación.

Solicitando precisión con Stability AI Image Services en Amazon Bedrock

Bedrock incorpora Stability AI Image Services con nueve herramientas para crear y editar imágenes con mayor precisión. Descubre técnicas de prompting para uso empresarial.

Escala la producción visual con Stability AI Image Services en Amazon Bedrock

Stability AI Image Services ya está disponible en Amazon Bedrock, ofreciendo capacidades de edición de imágenes listas para usar a través de la API de Bedrock y ampliando los modelos Stable Diffusion 3.5 y Stable Image Core/Ultra ya presentes.

Construir Flujos de Trabajo Agenticos con GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore

Visión general de extremo a extremo para implementar modelos GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore, impulsando un analizador de acciones multiagente con LangGraph, con cuantización MXFP4 de 4 bits y orquestación serverless.

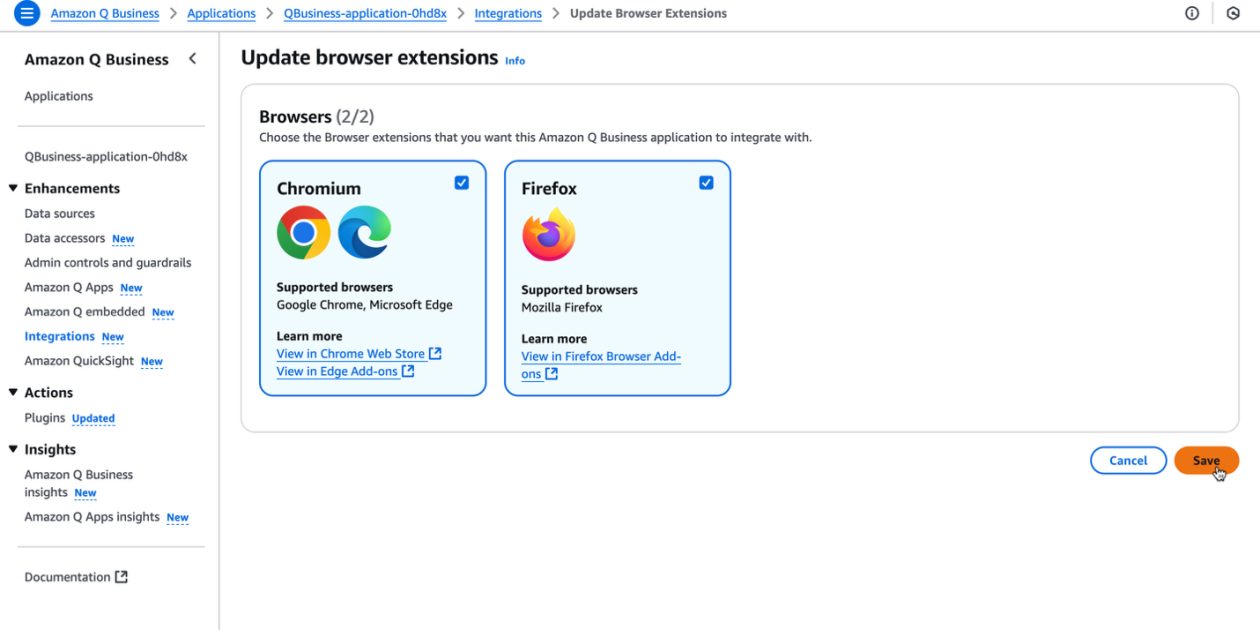

Impulsa la productividad de tu organización con la extensión de navegador Amazon Q Business

La extensión de navegador de Amazon Q Business ofrece asistencia IA contextual y generativa directamente en el navegador para suscriptores Lite y Pro, con insights basados en fuentes confiables y flujos de trabajo sin fricción.