Monitorear la inferencia por lotes de Bedrock de AWS con métricas de CloudWatch

Sources: https://aws.amazon.com/blogs/machine-learning/monitor-amazon-bedrock-batch-inference-using-amazon-cloudwatch-metrics, https://aws.amazon.com/blogs/machine-learning/monitor-amazon-bedrock-batch-inference-using-amazon-cloudwatch-metrics/, AWS ML Blog

TL;DR

- Bedrock batch inference permite procesamiento a granel de grandes conjuntos de datos con un costo aproximadamente 50% menor que la inferencia bajo demanda, ideal para análisis históricos, resúmenes a gran escala y procesamiento en segundo plano.

- Bedrock ahora publica automáticamente métricas de batch inference en CloudWatch, bajo el namespace AWS/Bedrock/Batch.

- Las métricas pueden verse por modelId e incluyen registros pendientes de procesamiento, tokens de entrada procesados por minuto y tokens de salida procesados por minuto; para modelos Anthropic Claude, también hay tokens pendientes.

- Puedes iniciar un job de batch inference desde la Consola, los SDK de AWS o la AWS CLI, y luego monitorizar la carga de trabajo con CloudWatch Metrics Insights, alarmas y paneles.

- La monitorización proactiva y la automatización—por ejemplo alarmas que disparan notificaciones SNS—pueden ayudar a optimizar el rendimiento y el costo de las cargas Bedrock batch. Para más detalles, consulta el post original de AWS sobre supervisar Bedrock batch inference con métricas de CloudWatch AWS Blog.

Contexto y antecedentes

A medida que las organizaciones amplían sus iniciativas de IA generativa, muchos flujos de trabajo exigen procesamiento en lote a bajo costo en lugar de respuestas en tiempo real. Bedrock batch inference atiende esta necesidad al permitir procesar grandes conjuntos de datos en lote con rendimiento predecible y a un costo menor que la inferencia bajo demanda. El blog de AWS resalta que Bedrock batch inference ahora publica métricas en CloudWatch bajo el namespace AWS/Bedrock/Batch, brindando visibilidad del progreso de los trabajos y del uso de recursos. Puede iniciar un job de batch inference mediante la Consola, los SDKs o la CLI de AWS, y monitorizar el progreso y el rendimiento a través de métricas de CloudWatch. Las métricas disponibles incluyen: registros pendientes, tokens de entrada procesados por minuto y tokens de salida procesados por minuto; para modelos Anthropic Claude, también se reportan tokens pendientes. Las métricas pueden verse por modelId, lo que permite hacer seguimiento del rendimiento y costos a nivel de modelo. Esta nueva visibilidad facilita el diagnóstico de cargas batch y la gobernanza del Bedrock batch inference a escala. Si desea explorar cómo ver y analizar estas métricas, CloudWatch ofrece Metrics Insights para consultar y visualizar datos del namespace AWS/Bedrock/Batch. El post también discute buenas prácticas de monitorización, incluyendo alertas proactivas y automatización para responder a cambios de carga y consideraciones de costos. El objetivo es maximizar la eficiencia y el valor de Bedrock batch inference combinando métricas, alarmas y paneles.

Novedades

- Publicación automática de métricas de batch inference en CloudWatch bajo el namespace AWS/Bedrock/Batch.

- Métricas con alcance por modelo (modelId): registros pendientes de procesamiento, tokens de entrada procesados por minuto y tokens de salida procesados por minuto; tokens pendientes para modelos Anthropic Claude.

- Soporte ampliado de modelos y mayor visibilidad del progreso de lotes, permitiendo una monitorización y resolución de problemas más granular.

- Mejora de la monitorización de costos para rastrear y optimizar cargas por lote.

- Flujo de trabajo simplificado para iniciar un batch inference mediante Consola, SDKs o CLI y configurar alarmas y paneles para operaciones. Estas mejoras facilitan una mayor transparencia y usabilidad a gran escala. Puede empezar iniciando un batch inference, configurando alarmas de CloudWatch y construyendo un panel para observar progresos y tendencias de costos.

Por qué es importante (impacto para desarrolladores/empresas)

Para desarrolladores y empresas, este flujo de monitorización actualizado de Bedrock batch inference ofrece varios beneficios prácticos:

- Visibilidad proactiva: métricas de CloudWatch ofrecen visibilidad en tiempo real e histórica sobre cargas por lotes, facilitando la detección de ralentizaciones, cuellos de botella o picos de costos antes de que afecten a los interesados.

- Respuestas automatizadas: alarmas y notificaciones SNS permiten respuestas automatizadas o semiautomáticas, como alertar al equipo de operaciones o activar pipelines descendentes.

- Transparencia de costos: métricas que reflejan tokens procesados y pendientes ayudan a comprender mejor los impulsores de costos y a optimizar el procesamiento por lotes para cumplir con presupuestos.

- Monitorización centralizada: paneles centralizados consolidan las métricas relevantes para diagnosticar problemas y planificar capacidad con rapidez.

- Gobernanza escalable: las métricas por modelo ayudan a aislar señales de rendimiento y costo cuando se gestionan varios modelos Bedrock en producción. Estas capacidades se alinean con objetivos empresariales comunes: garantizar rendimiento predecible para tareas de IA en lote, controlar el gasto y mantener la preparación operativa para cargas de trabajo generativas a gran escala. Todo ello proviene de la combinación de métricas de CloudWatch, alarmas y paneles, ahora enriquecidas por la telemetría de Bedrock batch inference.

Detalles técnicos o Implementación

Iniciar y configurar batch inference

- Puedes iniciar un job de batch inference en Bedrock usando la Consola de AWS, los SDKs o la AWS CLI. El artículo señala que el proceso es compatible con estas interfaces y que la guía de Bedrock proporciona los detalles de implementación.

- Una vez que el job esté en ejecución, Bedrock publicará métricas para ese job en CloudWatch, bajo el namespace AWS/Bedrock/Batch, ofreciendo visibilidad sobre el progreso y el uso de recursos.

Métricas de CloudWatch y dónde verlas

- Las métricas clave a seguir incluyen:

- Records pending processing

- Input tokens processed per minute

- Output tokens processed per minute

- Para los modelos Anthropic Claude, también hay la métrica tokens pending processing. Estas métricas pueden verse por modelId, permitiendo monitorizar rendimiento y costo por modelo.

- Para ver y analizar estas métricas, puede usar la consola de CloudWatch y herramientas como Metrics Insights para consultar y visualizar datos del namespace AWS/Bedrock/Batch.

Ejemplos prácticos: alertas y automatización

- Un ejemplo del blog describe crear una alarma de CloudWatch que se active cuando el promedio de NumberOfInputTokensProcessedPerMinute supere 1,000,000 en un periodo de 6 horas. Esta alarma puede disparar una notificación SNS para avisar al equipo de operaciones o iniciar pipelines descendentes.

- También puede construir un panel de CloudWatch para centralizar las métricas relevantes, facilitando la monitorización y resolución de problemas.

Recomendaciones y mejores prácticas

- Use métricas scopeadas por modelId para diagnosticar problemas de rendimiento o costo a nivel de modelo, especialmente al gestionar múltiples modelos Bedrock en producción.

- Aproveche Metrics Insights para análisis ad hoc y para crear dashboards y consultas más focalizados.

- Combine métricas, alarmas y paneles como parte de una estrategia de monitorización proactiva y automatización para maximizar la eficiencia y el valor de las cargas Bedrock batch.

Conclusiones

- Bedrock batch inference facilita el procesamiento en lote con rendimiento predecible y menor costo frente a la inferencia bajo demanda.

- Las métricas en CloudWatch con AWS/Bedrock/Batch y granularidad por modelId permiten seguimiento detallado por modelo.

- Alarmas y paneles apoyan la gestión proactiva y el control de costos para cargas por lote.

- Flujo completo: lanzar batch inference, configurar alarmas de CloudWatch, construir paneles y monitorizar de forma continua.

FAQ

Referencias

- AWS Blog: Monitorizar Bedrock batch inference usando métricas de CloudWatch. https://aws.amazon.com/blogs/machine-learning/monitor-amazon-bedrock-batch-inference-using-amazon-cloudwatch-metrics/

More news

Llevar agentes de IA de concepto a producción con Amazon Bedrock AgentCore

Análisis detallado de cómo Amazon Bedrock AgentCore facilita la transición de aplicaciones de IA basadas en agentes desde un concepto de prueba hasta sistemas de producción empresariales, conservando memoria, seguridad, observabilidad y gestión escalable de herramientas.

Solicitando precisión con Stability AI Image Services en Amazon Bedrock

Bedrock incorpora Stability AI Image Services con nueve herramientas para crear y editar imágenes con mayor precisión. Descubre técnicas de prompting para uso empresarial.

Escala la producción visual con Stability AI Image Services en Amazon Bedrock

Stability AI Image Services ya está disponible en Amazon Bedrock, ofreciendo capacidades de edición de imágenes listas para usar a través de la API de Bedrock y ampliando los modelos Stable Diffusion 3.5 y Stable Image Core/Ultra ya presentes.

Usar AWS Deep Learning Containers con Amazon SageMaker AI MLflow gestionado

Vea cómo los AWS Deep Learning Containers (DLCs) se integran con SageMaker AI gestionado por MLflow para equilibrar el control de la infraestructura y una gobernanza de ML sólida. Un flujo de TensorFlow para predicción de edad de abalones ilustra el seguimiento de extremo a extremo y la trazabilidad

Construir Flujos de Trabajo Agenticos con GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore

Visión general de extremo a extremo para implementar modelos GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore, impulsando un analizador de acciones multiagente con LangGraph, con cuantización MXFP4 de 4 bits y orquestación serverless.

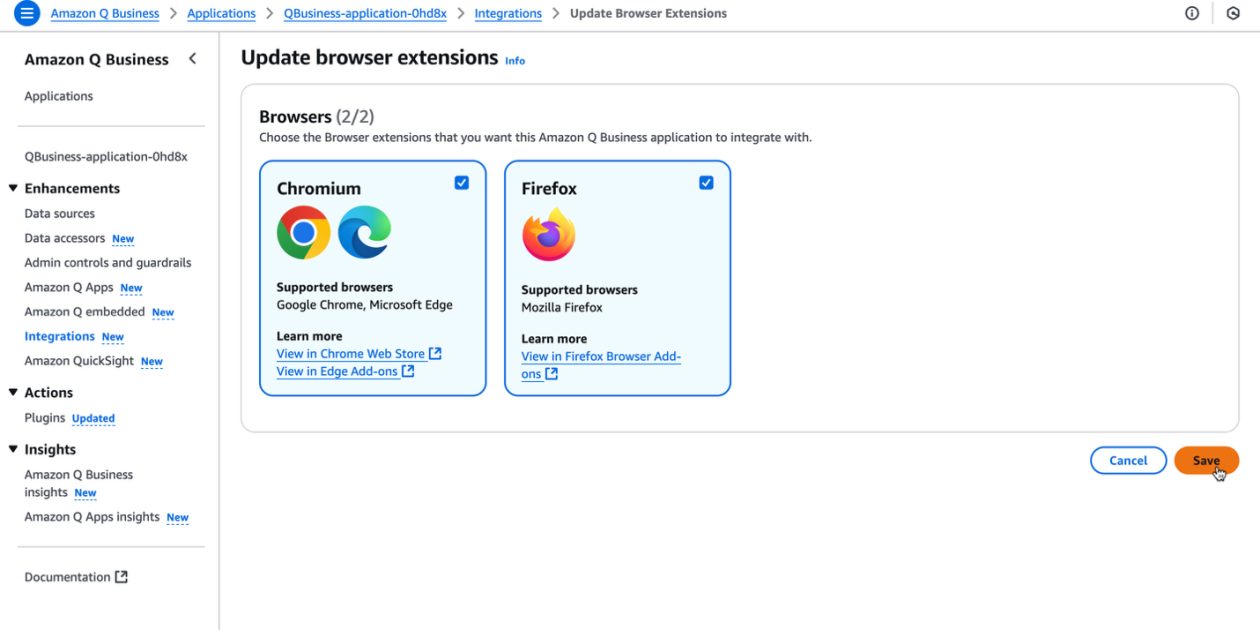

Impulsa la productividad de tu organización con la extensión de navegador Amazon Q Business

La extensión de navegador de Amazon Q Business ofrece asistencia IA contextual y generativa directamente en el navegador para suscriptores Lite y Pro, con insights basados en fuentes confiables y flujos de trabajo sin fricción.