Modelos Qwen3-Next MoE Híbridos de Código Abierto: Mayor Precisión y Inferencia Más Rápida en la Plataforma NVIDIA

Sources: https://developer.nvidia.com/blog/new-open-source-qwen3-next-models-preview-hybrid-moe-architecture-delivering-improved-accuracy-and-accelerated-parallel-processing-across-nvidia-platform, https://developer.nvidia.com/blog/new-open-source-qwen3-next-models-preview-hybrid-moe-architecture-delivering-improved-accuracy-and-accelerated-parallel-processing-across-nvidia-platform/, NVIDIA Dev Blog

TL;DR

- Alibaba lanzó dos modelos Qwen3-Next de código abierto, 80B-A3B-Thinking y 80B-A3B-Instruct, mostrando una arquitectura híbrida de Mixture of Experts (MoE) que busca mejorar la precisión y acelerar el procesamiento paralelo en plataformas NVIDIA.

- Cada modelo tiene 80 mil millones de parámetros, pero solo alrededor de 3 mil millones se activan por token debido al diseño esparso de MoE, entregando la potencia de un modelo masivo con la eficiencia de uno más pequeño.

- El módulo MoE enruta entre 512 expertos más 1 experto compartido, con 10 expertos activados por token, habilitando inferencia escalable y enrutamiento flexible.

- La arquitectura admite longitudes de contexto superiores a 260 mil tokens y utiliza Redes Delta Gateadas para procesar textos extremadamente largos de forma eficiente, con memoria y cálculo que crecen casi linealmente con la longitud de la secuencia.

- Al ejecutarse en hardware NVIDIA Hopper y Blackwell, la configuración se beneficia de NVLink de 5ta generación con 1,8 TB/s de ancho de banda directo GPU-a-GPU, reduciendo la latencia en el enrutamiento de expertos y aumentando el throughput de tokens.

- NVIDIA colabora con SGLang y vLLM para habilitar el despliegue como microservicios NIM; los desarrolladores pueden probar en build.nvidia.com, acceder a servicios NIM preempaquetados y explorar una guía de Jupyter para crear agentes de IA usando endpoints NIM de Qwen3-Next.

Contexto y antecedentes

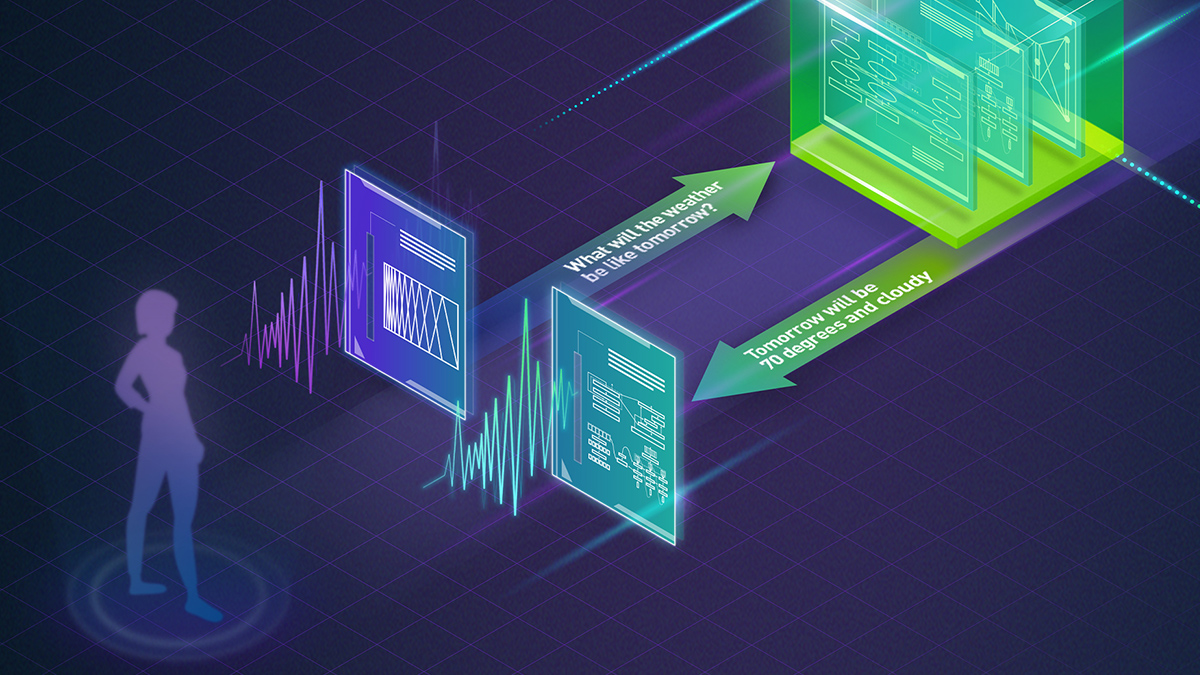

A medida que los modelos de IA escalan, la eficiencia adquiere la misma relevancia que la capacidad. Las secuencias de entrada largas son cada vez más comunes, y existe la necesidad de arquitecturas que ofrezcan alta precisión sin costos computacionales prohibitivos. En este marco, Alibaba publicó dos modelos Qwen3-Next de código abierto—80B-A3B-Thinking y 80B-A3B-Instruct—para mostrar una nueva aproximación híbrida MoE para investigación y desarrollo. La familia Qwen3-Next está diseñada para ofrecer las capacidades de modelos sumamente grandes manteniendo un uso práctico de recursos gracias a la sparsidad y a una comunicación entre GPUs optimizada. Esta iniciativa se alinea con el ecosistema open source de NVIDIA, que incluye proyectos como NeMo para la gestión del ciclo de vida de IA, Nemotron LLMs y Cosmos world foundation models (WFMs). El objetivo es ampliar la innovación haciendo que los modelos de punta sean más accesibles, transparentes y colaborativos para investigadores y desarrolladores. NVIDIA enfatiza rutas de despliegue abiertas al asociarse con marcos de código abierto como SGLang y vLLM, y al empaquetar los modelos como NVIDIA NIM (NVIDIA Inference Modules). Este enfoque permite a investigadores y empresas probar y desplegar los Qwen3-Next a través de endpoints alojados o contenedores en sus entornos, y experimentar con flujos prácticos para construir agentes mediante notebooks. El objetivo central del diseño híbrido MoE es ampliar la eficiencia y el razonamiento. La combinación de un enrutamiento MoE disperso con variantes de atención optimizadas y nuevos primitivos de memoria eficiente demuestra cómo los modelos a gran escala pueden ser accedidos y evaluados por la comunidad sin sacrificar rendimiento.

Qué hay de nuevo

Las previews de Qwen3-Next 80B-A3B-Thinking y 80B-A3B-Instruct introducen varias innovaciones arquitectónicas y de despliegue:

- Escala y sparsidad del modelo: cada modelo tiene 80 mil millones de parámetros, pero solo 3 mil millones se activan por token gracias a la estructura MoE dispersa. Esto permite capacidad masiva con costos computacionales manejables.

- Enrutamiento y capacidad MoE: el módulo MoE consta de 512 expertos enrutados más 1 experto compartido, con 10 expertos activados por token. Este enrutamiento permite una utilización dinámica de submódulos según la entrada, mejorando la eficiencia para tareas diversas.

- Contexto largo: la arquitectura está optimizada para longitudes de contexto superiores a 260 mil tokens, respaldada por primitivas de memoria y cálculo eficientes.

- Diseño de atención: el modelo tiene 48 capas, con cada 4ª capa aplicando atención GQA mientras las demás usan una variante de atención lineal. Este enfoque híbrido equilibra la expresividad y la eficiencia para secuencias largas.

- Redes Delta Gateadas: las contribuciones de Delta Networks ayudan a mantener el enfoque durante el procesamiento de contextos largos, reduciendo el desvío y conservando información relevante a lo largo de pasajes extensos.

- Hardware e interconexiones: los modelos están pensados para ejecutarse en GPUs NVIDIA Hopper y Blackwell, aprovechando NVLink de 5ª generación con 1,8 TB/s de ancho de banda para reducir la latencia de enrutamiento entre expertos y sostener un mayor throughput.

- Software y despliegue: la estrategia híbrida MoE es compatible con CUDA y con herramientas de plataforma de NVIDIA, permitiendo coexistir tanto capas de atención completas como lineales en la pila Qwen3-Next. NVIDIA también ha colaborado con SGLang y vLLM para facilitar el despliegue y empaquetamiento como microservicios NIM, con endpoints alojados y opciones de despliegue seguro en entornos corporativos.

- Acceso abierto y tooling: los desarrolladores pueden probar los modelos en build.nvidia.com, usar endpoints NIM para deployment práctico y explorar guías de notebooks para construir agentes con endpoints NIM del Qwen3-Next.

Por qué importa (impacto para desarrolladores/empresas)

El diseño híbrido MoE de Qwen3-Next busca ofrecer ganancias prácticas en razonamiento y throughput. Al activar solo una fracción del modelo por token, estas arquitecturas buscan combinar la potencia de modelos muy grandes con la eficiencia típica de modelos más pequeños. Para desarrolladores y empresas, el carácter de código abierto de Qwen3-Next, junto con las herramientas de deployment de NVIDIA, reduce las barreras para la experimentación y la integración en producción. Los microservicios NIM proporcionan endpoints listos para usar, mientras que las opciones de deployment en sitio ofrecen entornos seguros para flujos de IA en la empresa. La colaboración con SGLang y vLLM reduce aún más las fricciones de integración para serving y experimentación. Desde la perspectiva de hardware, el uso de GPUs Hopper y Blackwell con NVLink de alta velocidad reduce la latencia de enrutamiento entre cientos de expertos y soporta mayor throughput para cargas de trabajo de inferencia de IA. En la práctica, esto puede traducirse en respuestas más rápidas para tareas de razonamiento con contexto largo, mayor throughput de tokens y agentes de IA más escalables en producción. El ecosistema abierto de NVIDIA subraya su compromiso con la apertura, promoviendo la colaboración entre investigadores, desarrolladores y empresas para ampliar el acceso a arquitecturas de punta y fomentar la transparencia y la co-creación. Al proporcionar deployment de referencia, notebooks y containers, NVIDIA busca acelerar la innovación y ampliar el acceso a modelos de arquitectura avanzada.

Detalles técnicos o Implementación

Especificaciones clave de un vistazo

| Atributo | Valor

| --- |

|---|

| Tamaño del modelo |

| Parámetros activos por token |

| Enrutamiento MoE |

| Expertos activados por token |

| Número de capas |

| Esquema de atención |

| Longitud de contexto |

| Ancho de banda inter-GPU |

| Plataformas objetivo |

| Opciones de despliegue |

| Disponibilidad |

Notas técnicas

El enfoque híbrido MoE de Qwen3-Next distribuye dinámicamente la computación entre cientos de expertos. Con 10 expertos activos por token, el enrutamiento permite distribuir el procesamiento para lograr escalabilidad de throughput y mejoras en el razonamiento para entradas diversas. La combinación de atención GQA y atención lineal en 48 capas busca equilibrar la capacidad de modelar dependencias de largo alcance con restricciones computacionales prácticas. Las Delta Networks gateadas se citan como facilitadoras para mantener el foco durante el procesamiento de contextos muy largos, reduciendo drift y preservando la información relevante en pasajes extensos. Esto ayuda a que la memoria y el cálculo crezcan casi de forma lineal con el tamaño de la secuencia. Desde la perspectiva de deployment, la integración con CUDA y herramientas de plataforma de NVIDIA, junto con la colaboración con SGLang y vLLM, crea caminos prácticos para investigación y producción. Las empresas pueden explorar Qwen3-Next mediante endpoints hospedados o microservicios en sitio seguros, con soporte para flujos de agentes IA en escenarios reales.

Puntos clave

- Qwen3-Next presenta una aproximación MoE dispersa con 80B parámetros, pero solo 3B activos por token, brindando gran capacidad y eficiencia.

- Contexto largo (>260K tokens) combinado con memoria y cálculo escalables gracias a Delta Networks gateadas y una mezcla de atenciones GQA y lineales.

- Conexiones rápidas (NVLink 1,8 TB/s) y plataformas GPU (Hopper/Blackwell) para reducir la latencia de enrutamiento y aumentar el throughput.

- Acceso abierto vía NIM de NVIDIA, SGLang y vLLM para desarrollo y despliegue; guías, containers y endpoints disponibles.

- Este trabajo ilustra el compromiso de NVIDIA con código abierto, buscando ampliar el acceso, la transparencia y la colaboración en IA.

FAQ

-

¿Qué es el modelo 80B-A3B-Thinking de Qwen3-Next?

Es un modelo open source de 80 mil millones de parámetros diseñado para funcionar con una arquitectura híbrida MoE dispersa, permitiendo activar aproximadamente 3B por token y procesar contextos largos.

-

¿Cómo funciona la arquitectura MoE en estos modelos?

El módulo MoE tiene 512 expertos enrutados más 1 experto compartido, con 10 expertos activados por token. Este enrutamiento distribuye la computación entre submódulos para equilibrar capacidad y eficiencia.

-

¿Qué habilita el procesamiento de contexto largo y la eficiencia?

Contexto superior a 260K tokens, Delta Networks gateadas para mantener el foco en secuencias largas y una combinación de atención GQA y lineal en 48 capas.

-

¿Cómo pueden los desarrolladores acceder y desplegar estos modelos?

través de build.nvidia.com para pruebas, despliegue con microservicios NIM y opciones on-site seguras con soporte de SGLang y vLLM.

-

¿Cuál es el significado más amplio de este trabajo?

Demuestra un camino para combinar capacidad de gran escala con eficiencia práctica, fomenta el código abierto y ofrece rutas concretas de despliegue en plataformas NVIDIA. ---

Referencias

More news

NVIDIA HGX B200 reduce la intensidad de las emisiones de carbono incorporado

El HGX B200 de NVIDIA reduce la intensidad de carbono incorporado en un 24% frente al HGX H100, al tiempo que ofrece mayor rendimiento de IA y eficiencia energética. Este artículo resume los datos PCF y las novedades de hardware.

Predecir Eventos Climáticos Extremos en Minutos sin Supercomputadora: Huge Ensembles (HENS)

NVIDIA y Berkeley Lab presentan Huge Ensembles (HENS), una herramienta de IA de código abierto que pronostica eventos climáticos raros y de alto impacto usando 27,000 años de datos, con opciones de código abierto o listas para usar.

Scaleway se une a los Proveedores de Inferencia de Hugging Face para Inferencia Serverless y de Baja Latencia

Scaleway es ahora un Proveedor de Inferencia soportado en Hugging Face Hub, lo que permite inferencia serverless directamente en las páginas de modelos con los SDK de JS y Python. Accede a modelos open-weight populares y disfruta de flujos de IA escalables y de baja latencia.

Cómo reducir cuellos de botella KV Cache con NVIDIA Dynamo

NVIDIA Dynamo offloads KV Cache desde la memoria de la GPU hacia almacenamiento económico, habilitando contextos más largos, mayor concurrencia y costos de inferencia más bajos para grandes modelos y cargas de IA generativa.

Manual de los Grandmasters de Kaggle: 7 Técnicas de Modelado para Datos Tabulares

Un análisis detallado de siete técnicas probadas por los Grandmasters de Kaggle para resolver rápidamente conjuntos de datos tabulares mediante aceleración por GPU, desde baselines variados hasta ensamblaje y pseudo-etiquetado.

NVIDIA RAPIDS 25.08 Agrega Nuevo profiler para cuML, Mejoras en el motor GPU de Polars y Soporte Ampliado de Algoritmos

RAPIDS 25.08 introduce perfiles de nivel de función y de línea para cuml.accel, el ejecutor de streaming por defecto del motor Polars GPU, soporte ampliado de tipos y cadenas, Spectral Embedding en cuML y aceleraciones de cero código para varios estimadores.