Acelerar la Inferencia de Estructura de Proteínas en Más de 100x con NVIDIA RTX PRO 6000 Blackwell Server Edition

Sources: https://developer.nvidia.com/blog/accelerate-protein-structure-inference-over-100x-with-nvidia-rtx-pro-6000-blackwell-server-edition, https://developer.nvidia.com/blog/accelerate-protein-structure-inference-over-100x-with-nvidia-rtx-pro-6000-blackwell-server-edition/, NVIDIA Dev Blog

TL;DR

- El NVIDIA RTX PRO 6000 Blackwell Server Edition acelera la inferencia end-to-end de la estructura de proteínas en un solo servidor usando OpenFold, con precisión equivalente a AlphaFold2.

- En benchmarks, se observa hasta 138x más rápido que AlphaFold2 y alrededor de 2,8x más rápido que ColabFold; las velocidades de alineamiento e inferencia superan cientos de veces a las baselines de CPU.

- La plataforma ofrece 96 GB de memoria de alta ancho de banda (1,6 TB/s), capacidad MIG que convierte una tarjeta en cuatro GPUs y flujos de trabajo íntegramente residenciados en la GPU para MSAs grandes y conjuntos de proteínas.

Contexto y antecedentes

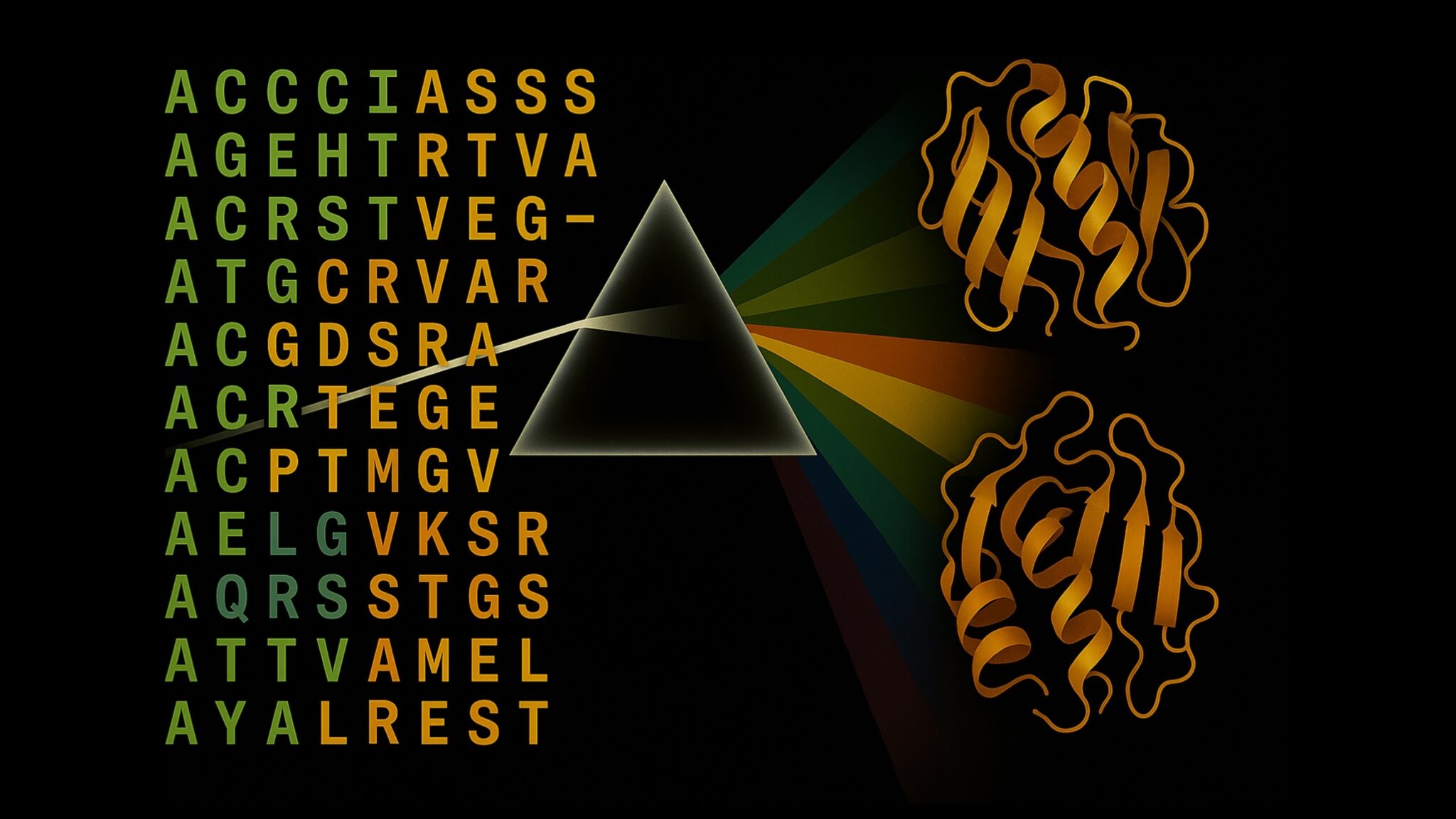

Comprender la estructura de las proteínas es crucial para acelerar el descubrimiento de fármacos, la ingeniería enzimática y las biotecnologías agrícolas. Desde AlphaFold2, la inferencia de estructuras de proteínas ha visto un avance enorme, pero siguen existiendo cuellos de botella que aumentan costos y tiempos de cómputo. La generación de MSAs basada en CPU y la inferencia GPU ineficiente siguen ralentizando los flujos de trabajo. En este marco, NVIDIA y sus laboratorios de biología digital han desarrollado aceleraciones para un flujo completo que permite el análisis a gran escala con OpenFold en GPUs RTX PRO y TensorRT, manteniendo la precisión frente a AlphaFold2. Post del blog de NVIDIA. Las cargas de trabajo modernas requieren MSAs a escala metagenómica, refinamiento iterativo y cálculos de ensembles que pueden llevar horas por objetivo. Escalar estas cargas de trabajo a lo largo de proteomas o bibliotecas de blancos farmacéuticos en infraestructuras CPU suele ser inviable. Las aceleraciones basadas en GPU con RTX PRO 6000 Blackwell permiten ejecutar el pipeline completo en un único servidor, haciendo factible el folding de proteínas a gran escala para laboratorios, plataformas de software y proveedores de nube. En comparativas, MMseqs2-GPU demuestra ganancias sustanciales frente a JackHMMER y otros métodos basados en CPU, destacando el potencial de la informática GPU para biología computacional.

Novedades

El RTX PRO 6000 Blackwell Server Edition combina hardware y software para acelerar la inferencia de proteínas:

- Plataforma GPU de alto rendimiento para inference end-to-end con OpenFold, con nuevas instrucciones y optimizaciones de TensorRT.

- Integración eficiente de MMseqs2-GPU para generación de MSAs y preprocesamiento rápido.

- Optimizaciones específicas de TensorRT para OpenFold, con mejoras significativas frente a la inferencia base.

- Validación en benchmarks estándar, incluyendo 20 objetivos CASP14, con predicciones que conservan TM-scores idénticos a AlphaFold2 pero con tiempos de ejecución mucho menores.

- Memoria de 96 GB y MIG para permitir ensembles grandes y MSAs íntegramente en GPU; MIG permite que una sola RTX PRO 6000 funcione como cuatro GPUs virtuales, facilitando el uso compartido entre usuarios.

- Disponibilidad ya: el RTX PRO 6000 Blackwell Server Edition está disponible hoy a través de NVIDIA RTX PRO Servers y de instancias en la nube de proveedores líderes.

Por qué es importante (impacto para desarrolladores/empresas)

Para desarrolladores de plataformas de descubrimiento de fármacos, proteómica o preparación ante pandemias, este avance implica beneficios tangibles:

- Mayor velocidad en las primeras predicciones, permitiendo pruebas de hipótesis y decisiones más rápidas.

- El folding a escala de proteoma pasa a ser viable en un solo servidor, reduciendo la necesidad de clusters CPU grandes y permitiendo análisis a gran escala.

- Ejecutar el flujo de trabajo completo en la GPU reduce la transferencia de datos y acelera los ciclos de I+D.

- MIG facilita la colaboración entre usuarios en un servidor compartido sin sacrificar rendimiento, mejorando la utilización de recursos en laboratorios y entornos cloud.

- La combinación de OpenFold, cuEquivariance, TensorRT y MMseqs2-GPU sobre un único dispositivo establece un nuevo punto de referencia en la velocidad de inferencia de estructuras de proteínas e impacta directamente en la investigación y las aplicaciones industriales. NVIDIA señala que estas aceleraciones mantienen la exactitud respecto a AlphaFold2. Post del blog de NVIDIA.

Detalles técnicos o Implementación

El rendimiento se apoya en una combinación de capacidades de hardware y optimización de software:

- Base de hardware: 96 GB de memoria de alta ancho de banda (1,6 TB/s) con MIG, lo que permite que todo el flujo de trabajo permanezca en la GPU, incluidas MSAs grandes y ensembles. MIG posibilita que una RTX PRO 6000 funcione como cuatro GPUs virtuales.

- Stack de software y optimizaciones: nuevas instrucciones y optimizaciones de TensorRT para OpenFold, junto con MMseqs2-GPU, producen mejoras sustanciales. OpenFold se beneficia de ajuste específico de TensorRT, resultando en mejoras de aproximadamente 2,3x frente a una configuración base.

- Rendimiento en benchmarks: en CASP14, la inferencia en RTX PRO 6000 Blackwell alcanza 138x frente a AlphaFold2 y ~2,8x frente a ColabFold, manteniendo TM-scores idénticos. En un benchmark de alineamiento, MMseqs2-GPU en un solo L40S es ~177x más rápido que JackHMMER en CPU de 128 núcleos, y hasta 720x más rápido al escalar a ocho GPUs L40S.

- Integración del flujo de trabajo: un ejemplo completo muestra desplegar OpenFold2 NIM en una máquina local, generar solicitudes de inferencia y usar un endpoint local para producir predicciones. Esto facilita el folding en un solo servidor con velocidad de clase mundial.

- Disponibilidad y despliegue: el RTX PRO 6000 Blackwell Server Edition está disponible hoy a través de NVIDIA RTX PRO Servers con fabricantes globales y en instancias de nube de proveedores líderes. NVIDIA invita a socios a colaborar para desplegar folding de proteínas a velocidad y escala sin precedentes. Agradecimientos a investigadores de NVIDIA, University of Oxford y Seoul National University.

Conclusiones clave

- La inferencia end-to-end de estructuras proteicas puede ejecutarse en un único servidor con el RTX PRO 6000 Blackwell, con velocidad de clase mundial sin pérdida de exactitud frente a AlphaFold2.

- Los beneficios cubren todo el pipeline: MMseqs2-GPU acelera la generación de MSAs, TensorRT optimiza OpenFold y el conjunto total supera a flujos basados en CPU.

- Los benchmarks muestran hasta 138x más rápido que AlphaFold2 y ~2,8x más rápido que ColabFold, con alineamientos 177x más rápidos en un solo L40S y hasta 720x al escalar a múltiples GPUs.

- Funciones como 96 GB de memoria y MIG facilitan flujos de trabajo grandes y residenciados en la GPU, con uso compartido entre usuarios sin pérdida de rendimiento.

- Disponibilidad inmediata hoy a través de NVIDIA RTX PRO Servers y proveedores cloud, habilitando adopciones en laboratorios e entornos empresariales.

FAQ

-

¿Qué puede hacer el RTX PRO 6000 Blackwell Server Edition?

Permite la inferencia end-to-end de estructuras de proteínas con OpenFold en un solo servidor, aprovechando MMseqs2-GPU, TensorRT y otras aceleraciones para obtener grandes mejoras frente a AlphaFold2 y ColabFold, manteniendo la exactitud.

-

¿Qué tan rápido es respecto a los baselines?

Hasta 138x más rápido que AlphaFold2 y alrededor de 2,8x más rápido que ColabFold para el flujo OpenFold; MMseqs2-GPU en un solo L40S es ~177x más rápido que JackHMMER en CPU de 128 núcleos, y hasta 720x al escalar a ocho GPUs.

-

¿Qué hardware soporta estos avances?

96 GB de memoria de alta bandwidth (1,6 TB/s), MIG para particionar un GPU en cuatro virtuales, y un stack de software con cuEquivariance, TensorRT y MMseqs2-GPU.

-

¿Está disponible ya?

Sí. El RTX PRO 6000 Blackwell Server Edition está disponible hoy mediante NVIDIA RTX PRO Servers y instancias en la nube de proveedores líderes.

-

Dónde obtener más información o iniciar una implementación?

Consulte el post del blog de NVIDIA para benchmarks y pautas de implementación, y contacte a socios de NVIDIA para planificar una implementación adaptada a su laboratorio o negocio. [Post del blog de NVIDIA](https://developer.nvidia.com/blog/accelerate-protein-structure-inference-over-100x-with-nvidia-rtx-pro-6000-blackwell-server-edition).

Referencias

More news

NVIDIA HGX B200 reduce la intensidad de las emisiones de carbono incorporado

El HGX B200 de NVIDIA reduce la intensidad de carbono incorporado en un 24% frente al HGX H100, al tiempo que ofrece mayor rendimiento de IA y eficiencia energética. Este artículo resume los datos PCF y las novedades de hardware.

Predecir Eventos Climáticos Extremos en Minutos sin Supercomputadora: Huge Ensembles (HENS)

NVIDIA y Berkeley Lab presentan Huge Ensembles (HENS), una herramienta de IA de código abierto que pronostica eventos climáticos raros y de alto impacto usando 27,000 años de datos, con opciones de código abierto o listas para usar.

Cómo reducir cuellos de botella KV Cache con NVIDIA Dynamo

NVIDIA Dynamo offloads KV Cache desde la memoria de la GPU hacia almacenamiento económico, habilitando contextos más largos, mayor concurrencia y costos de inferencia más bajos para grandes modelos y cargas de IA generativa.

Microsoft transforma el sitio de Foxconn en el data center Fairwater AI, descrito como el más poderoso del mundo

Microsoft anuncia planes para un data center Fairwater AI de 1,2 millones de pies cuadrados en Wisconsin, con cientos de miles de GPU Nvidia GB200. El proyecto de 3.3 mil millones de dólares promete un entrenamiento de IA sin precedentes.

Manual de los Grandmasters de Kaggle: 7 Técnicas de Modelado para Datos Tabulares

Un análisis detallado de siete técnicas probadas por los Grandmasters de Kaggle para resolver rápidamente conjuntos de datos tabulares mediante aceleración por GPU, desde baselines variados hasta ensamblaje y pseudo-etiquetado.

NVIDIA RAPIDS 25.08 Agrega Nuevo profiler para cuML, Mejoras en el motor GPU de Polars y Soporte Ampliado de Algoritmos

RAPIDS 25.08 introduce perfiles de nivel de función y de línea para cuml.accel, el ejecutor de streaming por defecto del motor Polars GPU, soporte ampliado de tipos y cadenas, Spectral Embedding en cuML y aceleraciones de cero código para varios estimadores.