Conoce a Boti: el asistente de IA que transforma el acceso de los ciudadanos de Buenos Aires a la información gubernamental con Amazon Bedrock

Sources: https://aws.amazon.com/blogs/machine-learning/meet-boti-the-ai-assistant-transforming-how-the-citizens-of-buenos-aires-access-government-information-with-amazon-bedrock, https://aws.amazon.com/blogs/machine-learning/meet-boti-the-ai-assistant-transforming-how-the-citizens-of-buenos-aires-access-government-information-with-amazon-bedrock/, AWS ML Blog

TL;DR

- La Ciudad de Buenos Aires, en colaboración con AWS GenAIIC, desarrolló un asistente de IA agentico usando LangGraph y Amazon Bedrock que responde preguntas sobre procedimientos gubernamentales.

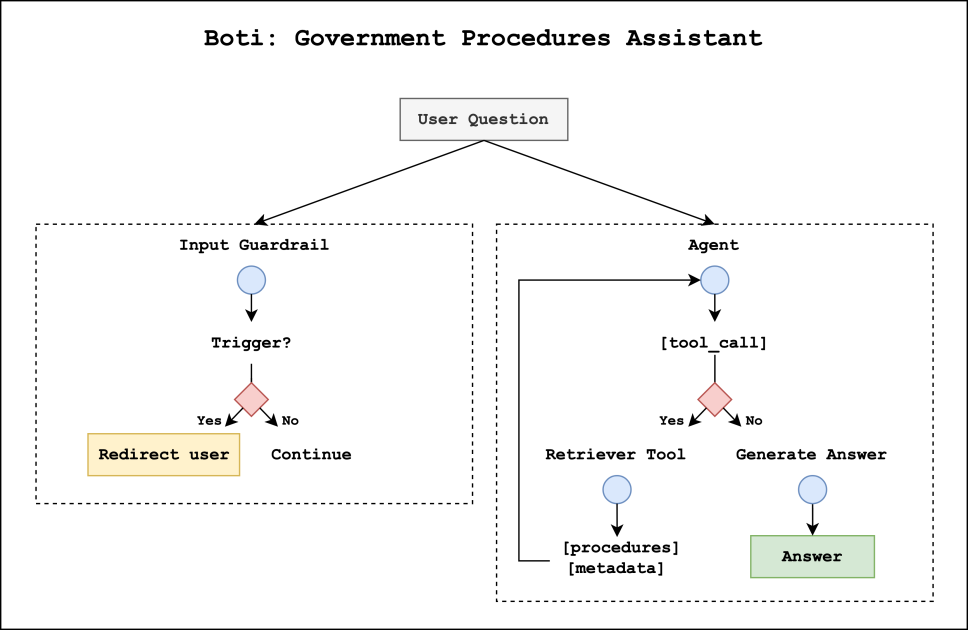

- El diseño tiene dos componentes: un sistema de guardrail que clasifica las consultas y un agente de procedimientos que recupera y compone respuestas.

- Un flujo de recuperación con razonamiento utiliza resúmenes comparativos para desambiguar procedimientos similares, logrando hasta 98,9% de precisión top-1 y una ganancia de 12,5 a 17,5% frente a métodos estándar de RAG.

- Los guardrail bloquearon el 100% de consultas dañinas en la evaluación; los expertos señalan 98% de precisión en voseo y 92% en futuro perífrastico.

- El proyecto amplía el alcance de Boti más allá de las más de 3 millones de conversaciones mensuales que ya maneja por WhatsApp, conectando a los ciudadanos con más de 1.300 procedimientos gubernamentales.

Contexto e historia

Desde 2019, Boti ha funcionado a través de WhatsApp, el canal más utilizado para información municipal en Argentina. Con Boti, los ciudadanos pueden acceder a información sobre renovación de licencias de conducir, servicios de salud, eventos culturales y más. Este canal se ha convertido en un canal de comunicación preferente y gestiona más de 3 millones de conversaciones cada mes. A medida que Boti gana popularidad, la ciudad buscó mejorar las experiencias conversacionales aprovechando los últimos avances en IA generativa para responder preguntas sobre procedimientos y guiar a los usuarios hacia el procedimiento correcto. Para evaluar una solución más avanzada, la ciudad se asoció con el AWS GenAIIC, que colaboró para construir un sistema de IA agentico que combina LangGraph y Amazon Bedrock. La implementación se centra en dos componentes: un sistema de guardrail de entrada y un agente de procedimientos gubernamentales. El guardrail utiliza un clasificador de LLM personalizado para evaluar las consultas e decidir si deben procesarse. Si está aprobado, el agente de procedimientos genera la respuesta; si no, se continúa con la ruta segura. La Ciudad de Buenos Aires mantiene más de 1.300 procedimientos, cada uno con su propia lógica, matices y excepciones, lo que llevó a enfatizar la necesidad de desambiguación precisa y recuperación de contexto para evitar respuestas incorrectas. Para la construcción del knowledge base y la inferencia, los equipos emplean Amazon Bedrock Knowledge Bases y la Bedrock Converse API para ejecutar LLMs, con un énfasis en adaptar las respuestas al español rioplatense, destacando el voseo y el uso del futuro perífrástico.

Novedades

El nuevo sistema de IA agentico consta de dos componentes que trabajan en paralelo al recibir una consulta. Primero, el guardrail analiza la consulta para decidir si puede procesarse on-topic. Si la consulta es nociva, la ejecución se detiene y el usuario es redirigido a preguntas sobre procedimientos gobernamentales de forma segura. Si se aprueba, el agente de procedimientos toma el control para generar la respuesta. En segundo lugar, el agente puede llamar a una herramienta de recuperación para obtener contexto y metadatos relevantes de procedimientos almacenados en Bedrock Knowledge Bases, permitiendo respuestas precisas y actualizadas. La inferencia se realiza mediante la Bedrock Converse API, aprovechando una diversa selección de LLMs para optimizar rendimiento y latencia. Una innovación clave es el flujo de recuperación por razonamiento diseñado para desambiguar procedimientos cercanos entre sí. El proceso comienza con la creación de una base de conocimiento de los procedimientos gubernamentales, que incluye información básica (propósito, audiencia, costos, pasos, requisitos) y resúmenes comparativos que describen qué distingue a cada procedimiento de sus vecinos. Estos resúmenes se agrupan en clusters pequeños (tamaño medio ≈ 5) y se enriquecen con descripciones de diferencias generadas por un LLM. Esta aproximación es similar a Contextual Retrieval de Anthropic, que antepone contexto explicativo a los fragmentos de documentos. Con la base de conocimiento preparada, el Reasoning Retriever opera en tres pasos: recibe los textos completos recuperados, sigue su propio razonamiento para identificar el contenido relevante y las atribuciones de URL al generar la respuesta, y utiliza esa información para componer la respuesta final. En evaluaciones con un conjunto sintético de 1.908 preguntas derivadas de procedimientos conocidos, el Reasoning Retriever superó significativamente a las técnicas RAG estándar en precisión de recuperación top-k. Los resultados mostraron que los embeddings multilingües de Cohere, combinados con un paso de razonamiento que usa Claude/Haiku en Bedrock, ofrecen rendimientos especialmente fuertes. Además, las configuraciones de recuperación fueron validadas con un gran benchmark. Los tres primeros enfoques representan métodos estándar de recuperación basados en vectores. Section Titan segmenta procedimientos por secciones del documento (~250 palabras por fragmento) y embebe los fragmentos con Titan Text Embeddings v2. Summaries Titan embebe los resúmenes de los procedimientos. Summaries Cohere utiliza Cohere Multilingual v3 para embeddings. El modelo Cohere Multilingual mostró mejoras notables con todos los valores top-k por encima de 90%. A continuación, las configuraciones con Reasoning Retriever usaron embeddings Cohere y LLMs de Anthropic Claude/Haiku o Claude 3 Sonnet en Bedrock. Todas las configuraciones de razonamiento obtuvieron altas puntuaciones en top-k, destacando la solución. Desde la perspectiva lingüística, los expertos observaron que las respuestas de Boti son correctas en voseo en el 98% de los casos y en el uso del futuro perífrastico en el 92% de los casos, lo que confirma la calidad de la adaptación lingüística al español Rioplatense.

Por qué es importante (impacto para desarrolladores/empresas)

La implementación demuestra cómo una administración puede escalar un asistente de IA para gestionar un vasto catálogo de procedimientos respetando la seguridad y la precisión. El diseño de guardrails personalizado demuestra cómo las organizaciones pueden adaptar sistemas de IA generativa a normas locales y lenguas sin sacrificar seguridad. Al integrar LangGraph con Bedrock, los desarrolladores pueden crear asistentes agentivos que combinan recuperación robusta, desambiguación precisa y generación contextual. Para las empresas, el proyecto ofrece un modelo de arquitectura práctico: un sistema de dos capas que protege a los usuarios al tiempo que permite una recuperación compleja sobre una base de conocimiento bien estructurada. La integración con Bedrock Knowledge Bases y Bedrock Converse API demuestra cómo lograr inferencia LLM escalable para tareas de información gubernamental. El proyecto también subraya la importancia de la escalabilidad y la precisión en dominios donde las leyes y los procedimientos cambian con frecuencia, al tiempo que ofrece una experiencia de usuario fluida y natural en español Rioplatense.

Detalles técnicos o Implementación

- Arquitectura: dos flujos paralelos al recibir una consulta — guardrail de entrada y agente de procedimientos. El guardrail asigna una categoría primaria (aprobado o bloqueado) y una subcategoría; las consultas aprobadas pasan al agente; las bloqueadas se redirigen a contenido seguro.

- Guardrail: clasificador LLM personalizado para detectar contenido nocivo (lenguaje ofensivo, opiniones peligrosas, ataques de inyección de prompt y conductas antiéticas). En la evaluación, el guardrail bloqueó el 100% de consultas dañinas, con algunas consultas normales señaladas como nocivas de forma conservadora.

- Agente de procedimientos: recupera contexto desde Bedrock Knowledge Bases y genera respuestas en español Rioplatense.

- Construcción de la base de conocimiento: metadatos de procedimientos (propósito, público, costos, pasos, requisitos) más resúmenes comparativos que describen diferencias entre procedimientos; los resúmenes se agrupan y se enriquecen con descripciones generadas por un LLM.

- Reasoning Retriever: tras la recuperación inicial, aplica un razonamiento para identificar procedimientos relevantes y citar URLs con trazabilidad.

- Modelos y evaluación: enfoques estándar (Titan, Summaries Titan, Summaries Cohere) y configuraciones con Reasoning Retriever que emplean Cohere y Claude/Haiku en Bedrock han mostrado resultados superiores; embeddings multilingües Cohere y razonamiento con LLM pueden lograr hasta 98,9% de precisión top-1 y mejoras de 12,5–17,5% frente al RAG.

- Inferencia y latencia: tanto el guardrail como el agente usan la Bedrock Converse API para inferencia de LLM, lo que facilita el control de rendimiento.

- Calidad lingüística: expertos reportaron 98% de precisión en voseo y 92% en futuro perífrastico.

Conclusiones clave

- Un sistema IA en dos capas (guardrails + agente) es viable para gestionar grandes catálogos de procedimientos con seguridad y precisión.

- Guardrails adaptados al idioma y al contexto local permiten seguridad sin sacrificar utilidad.

- Un flujo de recuperación por razonamiento con resúmenes comparativos mejora la desambiguación y la recuperación en dominios regulados.

- Bedrock Knowledge Bases + Bedrock Converse API permiten una inferencia LLM integrada y escalable para información gubernamental.

- El Boti demuestra que es posible entregar respuestas rápidas y contextualizadas con un tono local, manteniendo la trazabilidad y conformidad.

FAQ

-

¿Qué problema aborda Boti?

yuda a los ciudadanos a acceder a información sobre procedimientos gubernamentales, respondiendo preguntas y guiando hacia el procedimiento correcto.

-

¿Cómo funciona el guardrail de entrada?

Emplea un clasificador LLM personalizado que decide entre aprobado o bloqueado; las consultas aprobadas avanzan al agente de procedimientos; las bloqueadas se redirigen a contenidos seguros.

-

¿Qué es el Reasoning Retriever y por qué se usa?

Usa resúmenes comparativos y selección basada en LLM para desambiguar procedimientos y extraer los resultados más relevantes.

-

¿Qué rendimiento se observó?

El guardrail bloqueó el 100% de las consultas nocivas en la evaluación y el Reasoning Retriever alcanzó hasta 98,9% de exactitud top-1, con mejoras de 12,5–17,5% frente al RAG estándar. Los especialistas reportaron 98% de precisión en voseo y 92% en futuro perífrastico.

-

¿Qué tecnologías respaldan la solución?

LangGraph, Amazon Bedrock, Bedrock Knowledge Bases y Bedrock Converse API.

Referencias

- AWS ML Blog: Meet Boti: The AI assistant transforming how the citizens of Buenos Aires access government information with Amazon Bedrock. https://aws.amazon.com/blogs/machine-learning/meet-boti-the-ai-assistant-transforming-how-the-citizens-of-buenos-aires-access-government-information-with-amazon-bedrock/

More news

Llevar agentes de IA de concepto a producción con Amazon Bedrock AgentCore

Análisis detallado de cómo Amazon Bedrock AgentCore facilita la transición de aplicaciones de IA basadas en agentes desde un concepto de prueba hasta sistemas de producción empresariales, conservando memoria, seguridad, observabilidad y gestión escalable de herramientas.

Monitorear la inferencia por lotes de Bedrock de AWS con métricas de CloudWatch

Descubra cómo monitorear y optimizar trabajos de inferencia por lotes de Bedrock con métricas, alarmas y paneles de CloudWatch para mejorar rendimiento, costos y operación.

Solicitando precisión con Stability AI Image Services en Amazon Bedrock

Bedrock incorpora Stability AI Image Services con nueve herramientas para crear y editar imágenes con mayor precisión. Descubre técnicas de prompting para uso empresarial.

Escala la producción visual con Stability AI Image Services en Amazon Bedrock

Stability AI Image Services ya está disponible en Amazon Bedrock, ofreciendo capacidades de edición de imágenes listas para usar a través de la API de Bedrock y ampliando los modelos Stable Diffusion 3.5 y Stable Image Core/Ultra ya presentes.

Usar AWS Deep Learning Containers con Amazon SageMaker AI MLflow gestionado

Vea cómo los AWS Deep Learning Containers (DLCs) se integran con SageMaker AI gestionado por MLflow para equilibrar el control de la infraestructura y una gobernanza de ML sólida. Un flujo de TensorFlow para predicción de edad de abalones ilustra el seguimiento de extremo a extremo y la trazabilidad

Construir Flujos de Trabajo Agenticos con GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore

Visión general de extremo a extremo para implementar modelos GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore, impulsando un analizador de acciones multiagente con LangGraph, con cuantización MXFP4 de 4 bits y orquestación serverless.