Potenciar la investigación sobre la calidad del aire con análisis predictivos seguros impulsados por ML

Sources: https://aws.amazon.com/blogs/machine-learning/empowering-air-quality-research-with-secure-ml-driven-predictive-analytics, https://aws.amazon.com/blogs/machine-learning/empowering-air-quality-research-with-secure-ml-driven-predictive-analytics/, AWS ML Blog

TL;DR

- Un flujo de imputación de datos llena huecos de PM2.5 con ML entrenado en SageMaker Canvas, orquestado por AWS Lambda y AWS Step Functions.

- El conjunto de datos de ejemplo contiene más de 15 millones de registros entre marzo de 2022 y octubre de 2022, en Kenia y Nigeria, de 23 sensores en 15 ubicaciones.

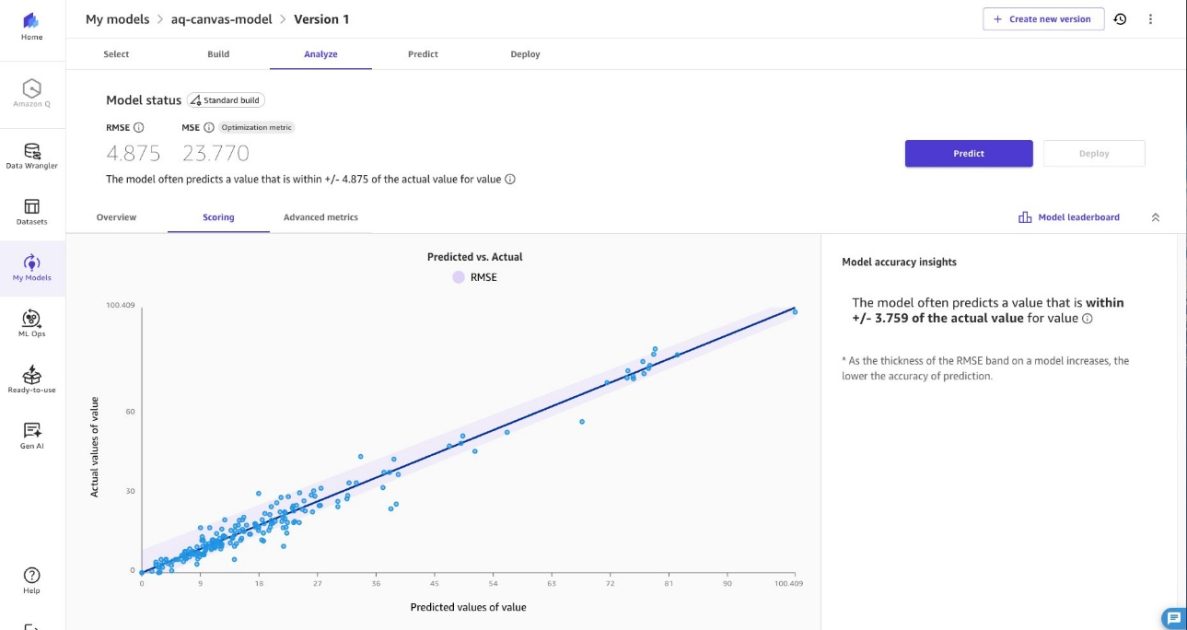

- Las predicciones para valores PM2.5 ausentes se generan dentro de un rango de +/- 4,875 µg/m³ para conservar la precisión de las tendencias.

- La solución prioriza la seguridad, el cifrado y la implementación en red privada, con un marco de responsabilidad compartida para la protección de datos.

Contexto y antecedentes

La contaminación del aire sigue siendo un desafío crítico para la salud ambiental en África. Organizaciones como sensors.AFRICA han desplegado sensores para monitorizar la calidad del aire, pero persisten lagunas de datos debido a inestabilidad eléctrica y conectividad en regiones de alto riesgo donde la mantenimiento es limitado. Los datos faltantes de PM2.5 reducen el poder estadístico y introducen sesgos en las estimaciones, dificultando la detección fiable de tendencias y conclusiones sobre patrones de calidad del aire. Estas lagunas comprometen decisiones basadas en evidencia para el control de la contaminación, evaluaciones de impacto en la salud y cumplimiento regulatorio. La exposición al PM2.5 se asocia con millones de muertes prematuras a nivel mundial, lo que subraya la importancia de pronósticos precisos para la salud pública. El artículo muestra la capacidad de pronóstico de series temporales de Amazon SageMaker Canvas, una plataforma de ML de bajo código, para predecir valores de PM2.5 a partir de conjuntos de datos incompletos. Canvas ofrece resistencia frente a datos faltantes, permitiendo operación continua de redes de monitoreo durante interrupciones o mantenimiento de sensores. Este enfoque ayuda a agencias ambientales y autoridades de salud pública a mantener acceso ininterrumpido a información crítica para alertas y análisis a largo plazo. El enfoque combina pronósticos con imputación de datos mediante Amazon SageMaker AI, AWS Lambda y AWS Step Functions. El conjunto de datos de ejemplo proviene de openAFRICA y contiene más de 15 millones de registros (marzo 2022–octubre 2022) de 23 sensores en 15 ubicaciones, en Kenia y Nigeria, mostrando cómo adaptar la solución a datos del mundo real. La arquitectura se centra en dos componentes de ML: un flujo de entrenamiento y un flujo de inferencia. Estos flujos se construyen con SageMaker Canvas para desarrollo y exportación del modelo para inferencia por lotes. El proceso de entrenamiento comienza con la extracción de datos de sensores desde una base de datos, su importación a Canvas para análisis predictivo y preparación de datos, y el entrenamiento del modelo para una predicción de un único objetivo. Una vez entrenado, Canvas exporta el modelo para su uso en batch processing. El enfoque admite reentrenamiento con nuevos datos de PM2.5 para adaptar el modelo a patrones cambiantes de sensores.

Qué hay de nuevo

Este artículo presenta un flujo completo y seguro de imputación de datos para lagunas de PM2.5 mediante una combinación de servicios de AWS. Características clave:

- Pronóstico de series temporales con SageMaker Canvas para estimar valores ausentes de PM2.5 en conjuntos de datos con lagunas.

- Flujo de trabajo sólido de extremo a extremo: extracción de datos, entrenamiento en Canvas, exportación del modelo y pipeline de inferencia por lotes.

- Orquestación diaria: una función Lambda lanza un trabajo de Transformación por Lotes de SageMaker cada 24 horas para datos nuevos con lagunas y actualiza el conjunto de datos con las predicciones.

- Datos de ejemplo realistas: más de 15 millones de registros entre marzo de 2022 y octubre de 2022, en Kenia y Nigeria, de 23 sensores en 15 ubicaciones.

- Seguridad por diseño: cifrado en reposo en S3, Aurora PostgreSQL-compatible y SageMaker Canvas; cifrado en tránsito mediante TLS; credenciales IAM temporales para acceso a RDS; roles de Lambda con privilegios mínimos; implementación en subredes privadas con endpoints VPC para S3 y SageMaker AI.

- Despliegue mediante IaC: el artículo describe un enfoque basado en CDK para entrenamiento, registro de modelos y despliegue, facilitando actualizaciones repetibles y trazables. Para implementar, el proyecto proporciona un repositorio con código de ejemplo y un README detallando los pasos.

Por qué importa (impacto para desarrolladores/empresas)

Para equipos y empresas que trabajan en monitoreo ambiental, este enfoque ofrece:

- Pipelines de datos resilientes que mantienen la operación a pesar de caídas de sensores, reduciendo lagunas y costos de inactividad.

- Perspectivas accionables de PM2.5 obtenidas a partir de datos incompletos sin requerir flujos perfectos, ayudando a investigadores y responsables de políticas a detectar tendencias a tiempo.

- Una solución escalable, segura y basada en la nube que se integra con sistemas de datos existentes (Aurora) y almacenamiento de objetos (S3), con controles de seguridad estrictos.

- Un patrón de implementación auditable gracias a la Infraestructura como Código (IaC) con CDK, facilitando actualizaciones repetibles.

- Prácticas de protección de datos en tránsito y en reposo, con permisos IAM granulares y red privada para minimizar la exposición. Este trabajo apoya objetivos de salud pública al permitir monitoreo continuo y análisis PM2.5 más confiables, facilitando acciones de control de contaminación y cumplimiento regulatorio.

Detalles técnicos o Implementación

La solución se compone de dos componentes ML principales: un flujo de entrenamiento y un flujo de inferencia, integrados en un pipeline seguro.

- Datos y entrenamiento

- Los conjuntos históricos de PM2.5 se extraen de una base de datos relacional y se preparan en SageMaker Canvas para el análisis predictivo.

- Canvas admite entrenar un modelo con un único objetivo usando transformaciones y características adecuadas para series temporales.

- Tras el entrenamiento, Canvas exporta el modelo para la inferencia por lotes.

- El conjunto de datos de entrenamiento de ejemplo contiene más de 15 millones de registros entre marzo 2022 y octubre 2022, provenientes de 23 sensores en 15 ubicaciones.

- Inferencia e imputación

- El Step Functions coordina el flujo; una función Lambda se invoca cada 24 horas.

- Lambda inicia un trabajo Transform Batch de SageMaker para predecir valores ausentes en los nuevos datos.

- La transformación por lotes procesa todo el conjunto de datos en una pasada y actualiza el conjunto con las predicciones.

- Ciclo de vida y despliegue del modelo

- Tras entrenar y evaluar (RMSE y otras métricas), el modelo se registra en SageMaker Model Registry y se despliega para la inferencia por lotes.

- El despliegue basado en CDK crea un dominio de SageMaker AI y un perfil de usuario, con los recursos para entrenamiento e inferencia.

- Un flujo incluye crear el modelo SageMaker en una VPC, desplegar el trabajo por lotes y actualizar la infraestructura con el nuevo ID del modelo mediante cdk deploy.

- La solución admite reentrenamiento con datos PM2.5 actualizados para adaptarse a patrones de sensores en evolución.

- Seguridad y cumplimiento

- Cifrado en reposo para S3, Aurora y SageMaker Canvas.

- Cifrado en tránsito mediante TLS para todas las comunicaciones desde Lambda.

- Credenciales IAM temporales para RDS, eliminando contraseñas estáticas.

- Funciones Lambda operando con privilegios mínimos y permisos granulares.

- Despliegue en subredes privadas sin acceso directo a Internet público, con endpoints VPC para S3 y SageMaker AI.

- Configuración y extensibilidad

- La arquitectura permite ajustes futuros mediante CDK, con un archivo de configuración que describe parámetros por defecto.

- Enfoque orientado a la seguridad y al modelo de Responsabilidad Compartida de AWS, animando a los clientes a revisar sus responsabilidades de implementación segura.

- Tabla: componentes clave y roles

| Componente | Rol |

|---|---|

| SageMaker Canvas | Entrenamiento y exportación del modelo para inferencia por lotes |

| AWS Lambda | Orquesta actualizaciones y arranque de transformaciones por lotes |

| AWS Step Functions | Coordina el flujo de trabajo de extremo a extremo |

| Amazon Aurora PostgreSQL-Compatible | Almacena datos de sensores con acceso IAM autenticado |

| Amazon S3 | Almacenamiento de datos en un data lake con cifrado en reposo |

- Referencias y notas de implementación

- El enfoque se documenta con código de ejemplo y guías de instalación en el repositorio: [email protected]:aws-samples/sample-empowering-air-quality-research-secure-machine-learning-predictive-analytics.git

- El artículo está disponible en https://aws.amazon.com/blogs/machine-learning/empowering-air-quality-research-secure-ml-driven-predictive-analytics/.

Puntos clave

- La imputación de lagunas PM2.5 es viable mediante un modelo SageMaker Canvas y un pipeline de inferencia por lotes.

- Lambda inicia transformaciones por lotes diariamente, manteniendo los datos actualizados con interrupciones mínimas en la supervisión.

- Las medidas de seguridad (cifrado, IAM de privilegios mínimos y red privada) protegen datos ambientales sensibles.

- El enfoque basado en IaC facilita implementaciones reproducibles y escalables.

Preguntas frecuentes (FAQ)

- P: ¿Cómo se realiza la imputación PM2.5? R: El flujo entrena un modelo SageMaker Canvas con datos PM2.5 históricos y utiliza un trabajo Transform Batch de SageMaker para predecir valores ausentes dentro de un rango de ±4,875 µg/m³.

- P: ¿Qué datos se utilizaron en el ejemplo? R: Un conjunto de datos de entrenamiento de openAFRICA con más de 15 millones de registros entre marzo 2022 y octubre 2022, de 23 sensores en 15 ubicaciones.

- P: ¿Qué servicios AWS componen este pipeline? R: SageMaker Canvas para entrenamiento e exportación, AWS Lambda para orquestación, AWS Step Functions para coordinación, SageMaker Transform para inferencia, Amazon Aurora PostgreSQL-compatible para almacenamiento y Amazon S3 para data lake, todo en red privada.

- P: ¿Cómo se maneja la seguridad? R: Cifrado en reposo (S3, Aurora, SageMaker Canvas), cifrado en tránsito (TLS), credenciales IAM temporales para RDS, roles Lambda de privilegios mínimos y subredes privadas con endpoints VPC, conforme al AWS Shared Responsibility Model.

- P: ¿Cómo puedo desplegarlo en mi entorno? R: El repositorio ofrece un enfoque CDK y un README con instrucciones para reproducir el flujo y adaptarlo a sus conjuntos PM2.5.

Referencias

- https://aws.amazon.com/blogs/machine-learning/empowering-air-quality-research-secure-ml-driven-predictive-analytics/

- [email protected]:aws-samples/sample-empowering-air-quality-research-secure-machine-learning-predictive-analytics.git

More news

Llevar agentes de IA de concepto a producción con Amazon Bedrock AgentCore

Análisis detallado de cómo Amazon Bedrock AgentCore facilita la transición de aplicaciones de IA basadas en agentes desde un concepto de prueba hasta sistemas de producción empresariales, conservando memoria, seguridad, observabilidad y gestión escalable de herramientas.

Monitorear la inferencia por lotes de Bedrock de AWS con métricas de CloudWatch

Descubra cómo monitorear y optimizar trabajos de inferencia por lotes de Bedrock con métricas, alarmas y paneles de CloudWatch para mejorar rendimiento, costos y operación.

Solicitando precisión con Stability AI Image Services en Amazon Bedrock

Bedrock incorpora Stability AI Image Services con nueve herramientas para crear y editar imágenes con mayor precisión. Descubre técnicas de prompting para uso empresarial.

Escala la producción visual con Stability AI Image Services en Amazon Bedrock

Stability AI Image Services ya está disponible en Amazon Bedrock, ofreciendo capacidades de edición de imágenes listas para usar a través de la API de Bedrock y ampliando los modelos Stable Diffusion 3.5 y Stable Image Core/Ultra ya presentes.

Usar AWS Deep Learning Containers con Amazon SageMaker AI MLflow gestionado

Vea cómo los AWS Deep Learning Containers (DLCs) se integran con SageMaker AI gestionado por MLflow para equilibrar el control de la infraestructura y una gobernanza de ML sólida. Un flujo de TensorFlow para predicción de edad de abalones ilustra el seguimiento de extremo a extremo y la trazabilidad

Construir Flujos de Trabajo Agenticos con GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore

Visión general de extremo a extremo para implementar modelos GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore, impulsando un analizador de acciones multiagente con LangGraph, con cuantización MXFP4 de 4 bits y orquestación serverless.