Mejore el análisis geoespacial con Amazon Bedrock: LLM, RAG y flujos GIS

TL;DR

- Amazon Bedrock ofrece una plataforma segura y flexible para alojar e invocar modelos de IA e integrarlos con sistemas de información geográfica (SIG) y flujos asociados.

- RAG (Recuperación Basada en Contexto) y flujos impulsados por agentes permiten casos de uso geoespaciales al combinar bases de conocimiento con datos en vivo y acciones contra proveedores externos.

- Las bases de conocimiento alojadas en fuentes como S3 y SharePoint proporcionan documentos no estructurados; las herramientas pueden recuperar información en tiempo real o controlar procesos externos a través de AWS Lambda, todo orquestado por Bedrock Agents.

- El artículo demuestra un agente de análisis de terremotos que vincula datos de Amazon Redshift con consultas geoespaciales para ilustrar un flujo de extremo a extremo.

- Se describe un pipeline práctico, con permisos IAM, configuración de AWS CLI, preparación de datos, configuración de Redshift, una base de conocimiento y un agente, para demostrar cómo operacionalizar Bedrock en contextos GIS.

Contexto y antecedentes

Los datos geoespaciales se asocian a una posición en la Tierra (latitud, longitud, altitud) y los SIG proporcionan una forma de almacenar, analizar y visualizar esta información. En las aplicaciones SIG, la información se suele presentar en mapas que muestran calles, edificios y vegetación. A medida que los datos crecen y los sistemas de información se vuelven más complejos, las partes interesadas necesitan soluciones que revelen insights de calidad y flujos de trabajo intuitivos. Los LLM son una subcategoría de modelos de base que pueden transformar entradas de texto (u otras modalidades) en salidas útiles para diversas tareas de procesamiento del lenguaje natural. Amazon Bedrock es un servicio completo, seguro y flexible para construir aplicaciones y agentes de IA generativa. Proporciona hosting e invocación de modelos y permite la integración con la infraestructura circundante. Los LLMs respaldan muchas tareas generales de procesamiento del lenguaje natural y, en contextos geoespaciales, pueden enriquecer flujos GIS, apoyar la exploración de datos y ayudar en la toma de decisiones. Para adaptar el rendimiento de los LLM a casos de uso específicos, se han desarrollado enfoques como RAG y flujos basados en agentes. El RAG recupera información contextual de una base de conocimiento durante la invocación del modelo, mientras que los flujos basados en agentes manejan análisis de datos más complejos y la orquestación. Con RAG, la información contextual de una base de conocimiento se inyecta en el prompt del modelo durante la invocación. Bedrock ofrece bases de conocimiento gestionadas conectadas a fuentes de datos como Amazon S3 y SharePoint, permitiendo información suplementaria como planes de desarrollo urbano, informes de inteligencia o políticas y regulaciones para acompañar las respuestas generadas por IA. Cuando el modelo IA responde basándose en material de RAG, puede proporcionar referencias y citas a las fuentes. En contextos geoespaciales, muchos conjuntos de datos son estructurados y residen en GIS, por lo que las herramientas y los agentes pueden conectar el GIS directamente al LLM en lugar de depender exclusivamente de bases de conocimiento. Muchos LLMs (por ejemplo, Claude en Amazon Bedrock) permiten describir herramientas disponibles para que el modelo genere texto que invoque procesos externos, como obtener el clima actual de un lugar, consultar un almacén de datos estructurado, iniciar un flujo de trabajo o añadir capas a un mapa. Las funcionalidades geoespaciales comunes que puede integrar con su LLM mediante herramientas incluyen: consultar datos en una base de datos espacial, iniciar flujos de trabajo, dibujar en el mapa o consultar información en tiempo real. Las herramientas suelen implementarse en AWS Lambda, que ejecuta código sin la complejidad de gestionar servidores. Bedrock también ofrece Bedrock Agents para simplificar la orquestación e integración con sus herramientas geoespaciales. Los Agents siguen instrucciones de razonamiento del LLM para descomponer una solicitud de usuario en tareas más pequeñas y realizar acciones contra proveedores de tareas identificados. Los diagramas en el artículo ilustran cómo Bedrock Agents pueden mejorar soluciones GIS. El ejemplo de demostración utiliza un agente de análisis de terremotos con una base de conocimiento basada en Amazon Redshift. La instancia de Redshift tiene dos tablas: earthquakes (fecha, magnitud, latitud, longitud) y counties en California (polígonos). Las capacidades geoespaciales de Redshift relacionan estos conjuntos de datos para responder preguntas como cuál condado tuvo el terremoto más reciente o cuál condado tuvo más terremotos en los últimos 20 años. El agente Bedrock puede generar estas consultas geoespaciales en lenguaje natural. Este flujo de trabajo describe un pipeline de extremo a extremo que realiza las siguientes acciones: preparar datos y almacenamiento en S3, transformar formatos geoespaciales, configurar Redshift y crear el esquema, crear una base de conocimiento y configurar un agente. El objetivo es mostrar una implementación práctica y end-to-end. Para implementar este enfoque, se requiere una cuenta AWS con permisos IAM adecuados para Amazon Bedrock, Amazon Redshift y Amazon S3. El artículo detalla pasos para configurar AWS CLI, validar el entorno, crear variables de Redshift y Bedrock, establecer roles IAM para S3 y Redshift, preparar datos y almacenamiento en S3, transformar datos geoespaciales, configurar el clúster Redshift, crear el esquema de base de datos, crear una base de conocimiento y crear y configurar un agente. Aunque se ofrecen fragmentos de código para ilustrar estas etapas, el objetivo principal es el flujo de extremo a extremo: conectar razonamiento IA con datos geoespaciales y con bases de conocimiento organizacionales para flujos GIS dinámicos y con contexto. La integración de IA con GIS crea sistemas intuitivos que permiten a usuarios de distintos niveles técnicos realizar análisis espaciales complejos mediante interacciones en lenguaje natural. Al usar RAG y flujos basados en agentes, las organizaciones pueden mantener la precisión de los datos mientras conectan modelos de IA con bases de conocimiento y sistemas de datos estructurados. Amazon Bedrock facilita esta convergencia entre IA y tecnologías GIS al proporcionar una plataforma robusta para la invocación de modelos, recuperación de conocimiento y orquestación de sistemas en un contexto geoespacial. Para más detalles y diagramas, consulte el artículo original en el blog de AWS.

Novedades

| Aspecto | Descripción |

|---|---|

| RAG | Inyección contextual dinámica desde una base de conocimiento durante la invocación del modelo para consultas geoespaciales. |

| Flujos basados en agentes | Descomposición de una solicitud en tareas y ejecución de acciones contra proveedores de tareas identificados para completar análisis geoespaciales. |

| Bases de conocimiento | Conexiones gestionadas a fuentes como S3 y SharePoint para enriquecer salidas con documentos y referencias de políticas. |

| Herramientas y orquestación | Herramientas (a menudo Lambda) permiten recuperación de datos en vivo, interacción con mapas o control de flujos, coordinados por Bedrock Agents. |

| Ejemplo end-to-end | Un agente de análisis de terremotos demuestra consultar datos de Redshift para producir insights y mapas geoespaciales. |

Por qué importa (impacto para desarrolladores/empresas)

- Análisis simplificado: la IA asistida para GIS reduce pasos manuales y acelera la exploración de datos espaciales.

- Toma de decisiones mejorada: respuestas contextualizadas apoyan la planificación y la interpretación de políticas con referencias trazables.

- Integración flexible: Bedrock ofrece una vía unificada para alojar modelos, gestionar bases de conocimiento y conectar con fuentes de datos existentes y flujos de trabajo.

- Valor para roles variados: usuarios técnicos, de negocio y liderazgo se benefician de resultados accesibles y basados en datos.

- Salidas auditable: con RAG, es posible citar fuentes; los agentes realizan tareas conectadas a datos en vivo y herramientas, reduciendo el riesgo de resultados obsoletos.

Detalles técnicos o Implementación (alto nivel)

Este apartado resume el enfoque de implementación descrito en el artículo. El patrón general combina modelos alojados en Bedrock, recuperación de conocimiento con RAG y Bedrock Agents que orquestan tareas contra fuentes de datos y herramientas externas.

Vista general de la arquitectura

- Fuentes de datos: datos GIS almacenados en una base de datos GIS estructurada (p. ej., Redshift con polígonos de condados) y conjuntos de datos geoespaciales en tiempo real.

- Modelos de IA: LLMs alojados en Bedrock actúan como motor de razonamiento e interfaz de lenguaje natural.

- Capa de conocimiento: bases de conocimiento gestionadas en S3 o SharePoint proporcionan documentos no estructurados y referencias de políticas.

- Orquestación: Bedrock Agents traducen las intenciones del usuario en tareas y llaman procesos externos o stores de datos (normalmente funciones Lambda).

- Herramientas: procesos externos recuperan datos en vivo, consultan stores de datos espaciales o modifican capas GIS; estas herramientas se invocan por el LLM a través de descripciones de herramientas.

Fuentes de datos y almacenamiento (ejemplo)

- El ejemplo de terremotos utiliza una instancia Redshift con dos tablas: earthquakes (fecha, magnitud, latitud, longitud) y counties (polígonos). Las capacidades geoespaciales de Redshift conectan estos conjuntos para responder preguntas como cuál condado tuvo el terremoto más reciente o cuál condado ha registrado más terremotos en los últimos 20 años. El agente Bedrock puede generar consultas geoespaciales en lenguaje natural basadas en los datos de Redshift y el flujo del agente para realizar el análisis.

- Las bases de conocimiento en Bedrock pueden conectarse a fuentes como S3 y SharePoint para proporcionar documentos adicionales y referencias de políticas.

Pipeline end-to-end (alto nivel)

- Preparar permisos IAM para Bedrock, Redshift y S3.

- Configurar el entorno AWS CLI y validar la configuración.

- Crear e inicializar variables de Bedrock y Redshift, incluyendo roles que permitan el acceso a datos.

- Preparar los datos geoespaciales y almacenarlos en S3 para su uso en el flujo.

- Transformar formatos de datos geoespaciales según sea necesario para alinearse con las capacidades de Redshift.

- Configurar el clúster Redshift y crear el esquema de la base de datos relevante.

- Crear y cargar la base de conocimiento con los documentos necesarios para las respuestas basadas en RAG.

- Crear y configurar un Bedrock Agent para interpretar intenciones, recuperar información de apoyo, consultar stores y modificar capas GIS cuando corresponda.

Ejemplos de prompts y capacidades

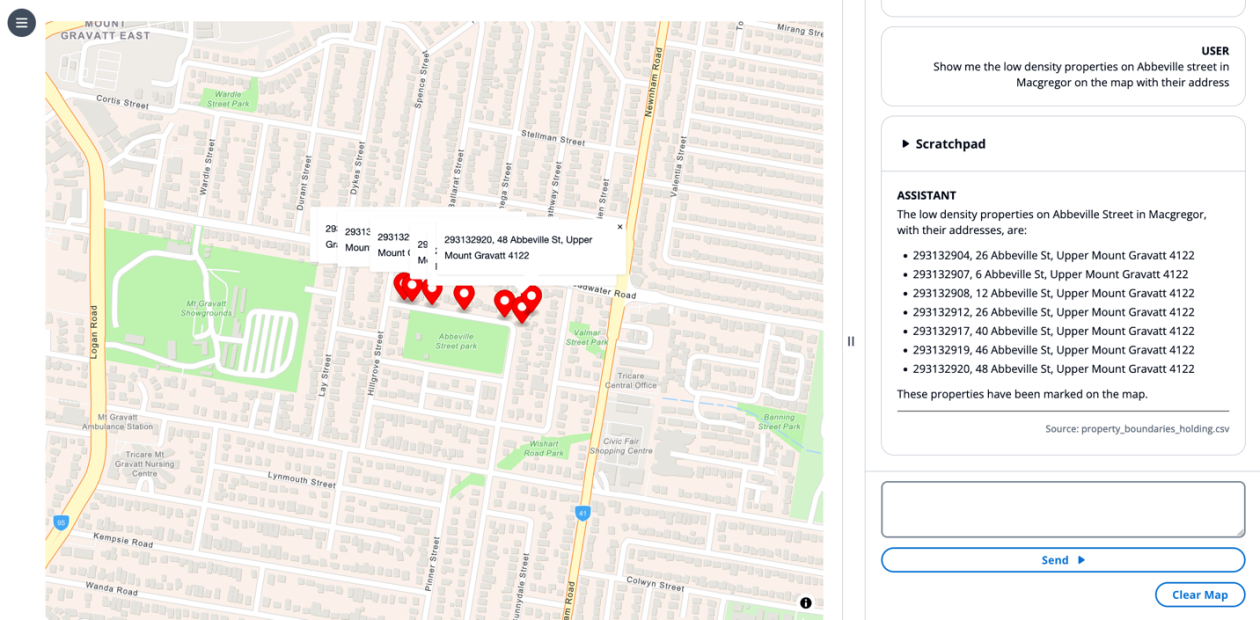

- El artículo muestra prompts como: Resuma qué zonas permiten construir un apartamento. Aquí, el LLM realiza la recuperación con RAG utilizando documentos de zonificación como contexto y responde en lenguaje natural. Otro ejemplo solicita un informe sobre cómo los datos de desarrollo urbano pueden utilizarse para planificar un nuevo desarrollo para satisfacer una alta demanda, donde el LLM recupera documentos del código de urbanismo y genera un informe estándar. Un tercer ejemplo pide mostrar las propiedades de baja densidad en una calle específica en un mapa; el LLM crea marcadores en el mapa invocando una herramienta de dibujo. Por último, un prompt pregunta si se puede construir un apartamento en un lugar determinado; el estado del mapa y los datos de políticas informan la respuesta con motivos.

- Los ejemplos ilustran plantillas de prompts, RAG, resúmenes, razonamiento en cadena, uso de herramientas y control de UI. También muestran cómo un motor de estado puede trasladar el contexto de la interfaz al input del LLM, permitiendo respuestas más precisas y contextualizadas.

Implementación y pruebas (alto nivel)

- Después de crear el agente, se puede probar con entradas en lenguaje natural y observar cómo el LLM utiliza RAG para recuperar fuentes y cómo el agente dispara herramientas para generar mapas, consultas o informes.

- El artículo enfatiza la importancia de las pruebas de extremo a extremo y la limpieza de recursos para evitar cargos no deseados.

Consideraciones para practicantes

- IAM, gobernanza de datos y gestión de costos son cruciales al implementar flujos GIS con Bedrock.

- RAG mejora la precisión contextual al referenciar bases de conocimiento, mientras que los flujos basados en agentes gestionan tareas de múltiples etapas y la orquestación entre datos y herramientas.

- La combinación Bedrock-Redshift-S3-Lambda permite pipelines de IA geoespacial de extremo a extremo que se integran con sistemas GIS existentes y políticas organizacionales.

Conclusiones clave

- Bedrock ofrece una plataforma integral para alojar modelos, gestionar bases de conocimiento y orquestar flujos GIS impulsados por IA.

- RAG y flujos basados en agentes permiten análisis geoespaciales con contexto y automatización de múltiples etapas sobre datos y herramientas.

- Bases de conocimiento conectadas a S3 y SharePoint enriquecen las respuestas de IA con documentos y políticas relevantes, mientras que los datos GIS en Redshift sustentan un razonamiento espacial preciso.

- Bedrock Agents facilitan la orquestación del razonamiento de LLM y la invocación de herramientas en tiempo real, brindando experiencias GIS interactivas mediante lenguaje natural.

- El ejemplo de Análisis de Terremotos demuestra un pipeline de extremo a extremo que conecta razonamiento de IA con datos geoespaciales y stores de datos en vivo, manteniendo precisión y trazabilidad.

Preguntas Frecuentes

-

- **Q : ¿Qué es un Bedrock Agent en este contexto GIS?**

Los Bedrock Agents están diseñados para simplificar la orquestación e integración, descomponiendo una petición del usuario en tareas más pequeñas y ejecutando acciones contra proveedores de tareas identificados. - **Q : ¿Cómo ayuda el RAG a los casos geoespaciales?** **A :** El RAG inyecta contexto desde una base de conocimiento durante la invocación del modelo, permitiendo que la IA haga referencia a fuentes y cite referencias en sus respuestas. - **Q : ¿Qué datos se utilizan en el ejemplo de terremotos?** **A :** Se utiliza un conjunto Redshift con earthquakes (fecha, magnitud, latitud, longitud) y counties (polígonos). Las capacidades geoespaciales de Redshift conectan estos datos para responder preguntas espaciales. - **Q : ¿Qué configuración se necesita para implementar este enfoque?** **A :** Una cuenta AWS con permisos IAM para Bedrock, Redshift y S3; configuración de AWS CLI; creación de variables Bedrock y Redshift; preparación de datos; creación de una base de conocimiento; creación y configuración de un agente.

Referencias

More news

Llevar agentes de IA de concepto a producción con Amazon Bedrock AgentCore

Análisis detallado de cómo Amazon Bedrock AgentCore facilita la transición de aplicaciones de IA basadas en agentes desde un concepto de prueba hasta sistemas de producción empresariales, conservando memoria, seguridad, observabilidad y gestión escalable de herramientas.

Cómo reducir cuellos de botella KV Cache con NVIDIA Dynamo

NVIDIA Dynamo offloads KV Cache desde la memoria de la GPU hacia almacenamiento económico, habilitando contextos más largos, mayor concurrencia y costos de inferencia más bajos para grandes modelos y cargas de IA generativa.

Monitorear la inferencia por lotes de Bedrock de AWS con métricas de CloudWatch

Descubra cómo monitorear y optimizar trabajos de inferencia por lotes de Bedrock con métricas, alarmas y paneles de CloudWatch para mejorar rendimiento, costos y operación.

Solicitando precisión con Stability AI Image Services en Amazon Bedrock

Bedrock incorpora Stability AI Image Services con nueve herramientas para crear y editar imágenes con mayor precisión. Descubre técnicas de prompting para uso empresarial.

Escala la producción visual con Stability AI Image Services en Amazon Bedrock

Stability AI Image Services ya está disponible en Amazon Bedrock, ofreciendo capacidades de edición de imágenes listas para usar a través de la API de Bedrock y ampliando los modelos Stable Diffusion 3.5 y Stable Image Core/Ultra ya presentes.

Usar AWS Deep Learning Containers con Amazon SageMaker AI MLflow gestionado

Vea cómo los AWS Deep Learning Containers (DLCs) se integran con SageMaker AI gestionado por MLflow para equilibrar el control de la infraestructura y una gobernanza de ML sólida. Un flujo de TensorFlow para predicción de edad de abalones ilustra el seguimiento de extremo a extremo y la trazabilidad