Menos código, más ciencia: simplificar la modelización oceánica en GPUs con OpenACC y memoria unificada

TL;DR

- NVIDIA HPC SDK v25.7 avanza la programación con memoria unificada para HPC con GPU, automatizando la transferencia de datos entre CPU y GPU.

- La release reduce la gestión manual de datos, acorta ciclos de porting a GPU y reduce errores al explotar un espacio de direcciones único.

- Plataformas cohesivas de NVIDIA con interconexión de alta velocidad (Grace Hopper, GB200 NVL72) permiten migración automática de datos y memoria compartida entre CPU y GPU.

- El port real de NEMO (modelo oceánico) a GPUs muestra ganancias cercanas a 2x–5x; OpenACC 3.4 introduce el modificador de captura para evitar condiciones de carrera.

- La actualización respalda la estrategia de NVIDIA de simplificar el desarrollo en GPU y acelerar cargas científicas en oceanografía y climatología.

Contexto y antecedentes

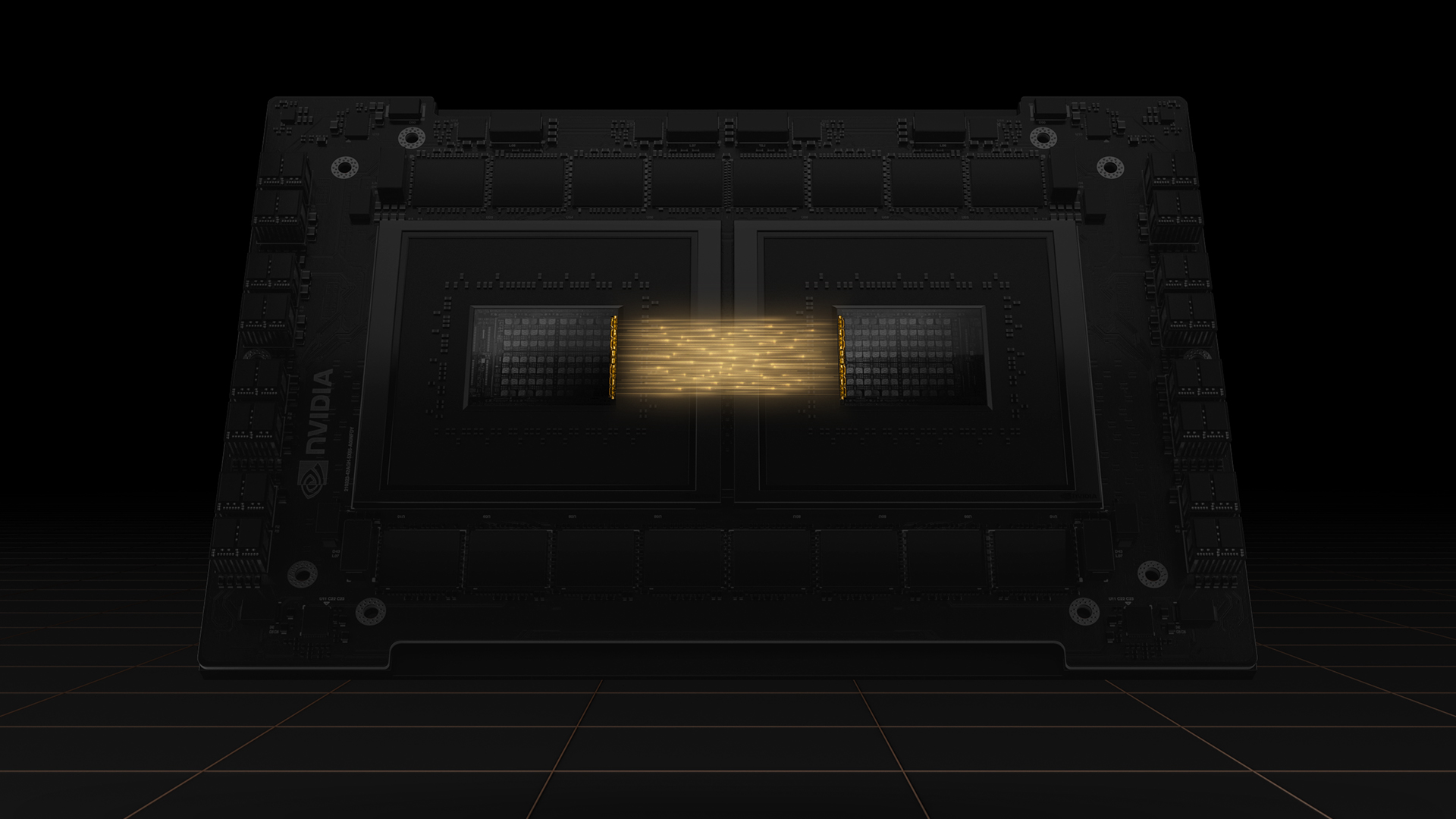

La programación con memoria unificada se presenta como una función clave para el HPC en sistemas acelerados por GPU. Plataformas coherentes como Grace Hopper y GB200 NVL72 ofrecen un espacio de direcciones compartido entre CPU y GPU, permitiendo que el driver CUDA gestione automáticamente la transferencia de datos. Estas capacidades dependen de interconexiones de alta velocidad (NVLink-C2C) y de un modelo de memoria unificada que reduce la necesidad de transferencias explícitas. Desde finales de 2023, NVIDIA ha ido integrando la memoria unificada en el ecosistema HPC, con sistemas basados en Grace Hopper ya desplegados en centros de investigación destacados como CSCS (Suiza) y JSC (Alemania). El objetivo es aumentar la productividad del desarrollador al liberar de la logística de movimiento de datos. NVIDIA HPC SDK v25.7 release. En este contexto, el port real de NEMO (marco de modelado oceánico) sirve como un estudio de caso concreto. El código NEMO incluye estructuras de datos complejas, como tipos derivados y arreglos alocados, que históricamente requerían una gestión manual de datos al portar a GPUs. El blog explica cómo la memoria unificada puede reducir o eliminar este boilerplate, permitiendo a los desarrolladores centrarse más en el paralelismo. El texto también destaca cómo las arquitecturas Grace Hopper ofrecen coherencia de memoria entre CPU y GPU gracias a interconexiones de alta velocidad, mejorando la localidad durante offloads a GPU. NVIDIA HPC SDK v25.7 release.

Qué hay de nuevo

- Conjunto completo de herramientas para la programación con memoria unificada: el HPC SDK 25.7 ofrece un kit completo que automatiza la transferencia de datos entre CPU y GPU, reduciendo la gestión manual y facilitando la paralelización.

- Menos gestión de datos y porteo más rápido: con un espacio de direcciones compartido, las transferencias de datos son gestionadas por el driver CUDA, reduciendo el boilerplate y los errores.

- Mejoras con OpenACC y manejo de condiciones de carrera: el blog detalla que la ejecución asíncrona en OpenACC puede introducir condiciones de carrera cuando la GPU accede a datos compartidos mientras la CPU sale de funciones. OpenACC 3.4 introduce el modificador de captura en cláusulas de datos para resolver estas condiciones, permitiendo uso asíncrono más seguro sin refactorización pesada. NVIDIA HPC SDK v25.7 release.

- Ejecución asíncrona y mejor concurrencia: los desarrolladores pueden usar directivas asíncronas y sincronización (p. ej., !$acc wait) para superponer cómputo y comunicación, garantizando la visibilidad de datos para MPI u otras rutinas de CPU.

- Migración automática de memoria y beneficios de localidad: CUDA 12.4 introduce heurísticas de acceso que migran páginas de memoria de la CPU a la GPU según el uso, mejorando la localidad en Grace Hopper. Funcionalidad similar existe en sistemas compatibles con Linux y núcleos recientes.

- Port de NEMO (benchmark GYRE_PISCES): el port de NEMO a GPUs demuestra un flujo de trabajo práctico y ganancias de productividad, iniciando en CPU y avanzando hacia difusión horizontal de traçadores, advección y, finalmente, difusión vertical y filtrado temporal. Las ganancias de rendimiento se observan a lo largo de las etapas, con mejoras de ~2x a ~5x al mover más código a la GPU Hopper. Este caso subraya el equilibrio entre productividad y rendimiento al adoptar memoria unificada.

Por qué importa para desarrolladores y empresas

La memoria unificada resuelve uno de los mayores retos del desarrollo de GPU en HPC: la gestión de datos. Al proporcionar un espacio de direcciones compartido, los equipos pueden reducir el código boilerplate, acortar ciclos de porteo y probar más configuraciones de GPU con menos retrabajo. La capacidad de capturar condiciones de carrera con el modificador de captura de OpenACC 3.4 aumenta la fiabilidad en ejecuciones asíncronas, lo que es crucial para simulaciones a gran escala. La migración automática de memoria y la coherencia CPU-GPU facilitan una mejor locality y rendimiento, sin necesidad de reescribir grandes bloques de código. Estos elementos favorecen una adopción más amplia de GPU para modelos oceánicos y ciencias climáticas, con beneficios tangibles en productividad y resultados científicos.

Detalles técnicos o Implementación

El blog describe una ruta práctica de porteo, mostrando cómo un código NEMO puede pasar de ejecución CPU a kernels OpenACC en GPU, apoyándose en la memoria unificada y en el driver CUDA para la gestión de datos. Se destacan posibles carreras de datos en ejecución asíncrona y cómo el modificador de captura de OpenACC 3.4 ayuda a resolverlas sin reestructuraciones grandes. La arquitectura Grace Hopper aporta coherencia entre CPU y GPU mediante NVLink-C2C, lo que fortalece la eficiencia de porteo. CUDA 12.4 complementa este marco con migración de páginas de memoria basada en el uso para mantener la locality. El port de NEMO se presenta como un proceso gradual: empezar por diffusión horizontal de traçadores, avanzar a advección de traçadores y, finalmente, diffusión vertical y filtrado temporal. En cada etapa se observan ganancias al mover más cálculos a la GPU Hopper. Este caso demuestra no solo rendimiento, sino también la rapidez con la que los equipos pueden iterar configuraciones con poco código adicional. NVIDIA HPC SDK v25.7 release.

Conclusiones clave

- Memoria unificada reduce la necesidad de gestión de datos en códigos HPC para GPUs.

- OpenACC se beneficia del soporte 3.4, mitigando condiciones de carrera en ejecuciones asíncronas.

- La migración automática de memoria y la coherencia Grace Hopper mejoran la locality y el rendimiento sin reescrituras extensivas.

- Portaciones reales, como NEMO, muestran ganancias de productividad y rendimiento.

- El HPC SDK 25.7 fortalece la transición hacia plataformas CPU-GPU coherentes para las ciencias computacionales.

Preguntas frecuentes

-

¿Qué es la memoria unificada en esta versión?

Esta versión ofrece un conjunto completo de herramientas que automatizan los transferencias de datos y crean un espacio de direcciones único entre CPU y GPU, reduciendo la gestión manual.

-

¿Cómo afecta esto a OpenACC en Grace Hopper?

Permite un porteo más seguro y productivo, reduce el boilerplate de gestión de datos y soporta el modificador de captura de OpenACC 3.4 para evitar condiciones de carrera.

-

¿Qué rendimiento esperar con cargas como NEMO?

En el port de NEMO, los ganhos observados variaron entre ~2x y ~5x a medida que más código se movía a Hopper.

-

¿Qué hay acerca de las condiciones de carrera y la sincronización?

El modificador de captura de OpenACC 3.4 aborda estas condiciones en escenarios asíncronos, aumentando la fiabilidad sin reestructuraciones grandes.

-

¿Qué deben hacer los desarrolladores al portar a memoria unificada?

Comenzar por paralelizar bucles críticos con OpenACC, depender del driver CUDA para la gestión de datos, considerar ejecuciones asíncronas con sincronización cuidadosa y usar el modificador de captura cuando sea necesario.

Referencias

- NVIDIA Dev Blog: Less Coding, More Science: Simplify Ocean Modeling on GPUs With OpenACC and Unified Memory — https://developer.nvidia.com/blog/less-coding-more-science-simplify-ocean-modeling-on-gpus-with-openacc-and-unified-memory/

More news

NVIDIA HGX B200 reduce la intensidad de las emisiones de carbono incorporado

El HGX B200 de NVIDIA reduce la intensidad de carbono incorporado en un 24% frente al HGX H100, al tiempo que ofrece mayor rendimiento de IA y eficiencia energética. Este artículo resume los datos PCF y las novedades de hardware.

Predecir Eventos Climáticos Extremos en Minutos sin Supercomputadora: Huge Ensembles (HENS)

NVIDIA y Berkeley Lab presentan Huge Ensembles (HENS), una herramienta de IA de código abierto que pronostica eventos climáticos raros y de alto impacto usando 27,000 años de datos, con opciones de código abierto o listas para usar.

Cómo reducir cuellos de botella KV Cache con NVIDIA Dynamo

NVIDIA Dynamo offloads KV Cache desde la memoria de la GPU hacia almacenamiento económico, habilitando contextos más largos, mayor concurrencia y costos de inferencia más bajos para grandes modelos y cargas de IA generativa.

Microsoft transforma el sitio de Foxconn en el data center Fairwater AI, descrito como el más poderoso del mundo

Microsoft anuncia planes para un data center Fairwater AI de 1,2 millones de pies cuadrados en Wisconsin, con cientos de miles de GPU Nvidia GB200. El proyecto de 3.3 mil millones de dólares promete un entrenamiento de IA sin precedentes.

Manual de los Grandmasters de Kaggle: 7 Técnicas de Modelado para Datos Tabulares

Un análisis detallado de siete técnicas probadas por los Grandmasters de Kaggle para resolver rápidamente conjuntos de datos tabulares mediante aceleración por GPU, desde baselines variados hasta ensamblaje y pseudo-etiquetado.

Reddit busca un acuerdo de IA más grande con Google: usuarios y contenido a cambio

Reddit busca términos de licencia de IA más amplios con Google, apuntando a más usuarios y acceso a datos de Reddit para entrenamiento de IA, posiblemente mediante precios dinámicos e incentivos de tráfico.