Mejorar agentes de IA con modelos ML predictivos mediante SageMaker AI y MCP

TL;DR

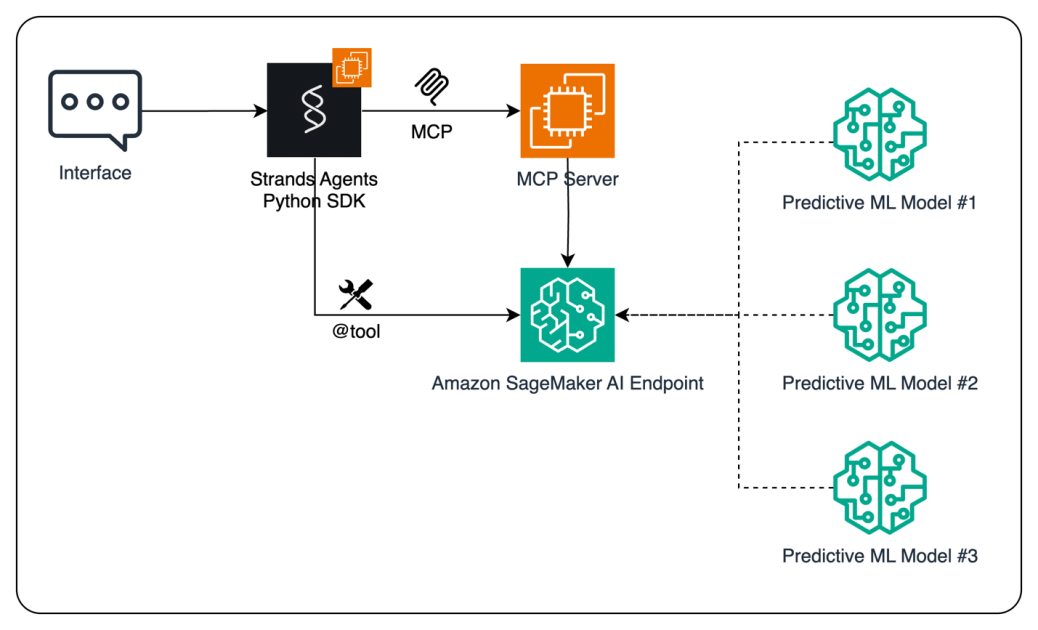

- Los agentes de IA pueden aprovechar modelos ML predictivos alojados en Amazon SageMaker AI como herramientas para informar decisiones basadas en datos.

- MCP (Model Context Protocol) permite descubrimiento dinámico de herramientas y desacopla la ejecución del agente de la ejecución de herramientas, favoreciendo escalabilidad y seguridad.

- Strands Agents SDK ofrece un enfoque guiado por modelo para construir rápidamente agentes de IA, con dos vías de acceso a endpoints de SageMaker: llamadas directas al endpoint o invocación mediante MCP.

- Para despliegues de producción, se recomienda MCP por su arquitectura desacoplada y gestión centralizada de permisos; el acceso directo al endpoint sigue siendo una opción válida para escenarios simples.

- El flujo mostrado entrena un modelo de series temporales, lo despliega en SageMaker AI y lo pone a disposición de un agente de IA, mostrando un flujo de datos a decisión en tiempo real desde los datos hasta la acción.

Contexto y antecedentes

El ML ha evolucionado de fases experimentales a una parte integral de las operaciones empresariales. Las organizaciones utilizan modelos ML para pronósticos de ventas, segmentación de clientes y predicción de churn. Aunque la IA generativa ha transformado la interacción con el cliente, el ML tradicional sigue siendo esencial para tareas predictivas específicas. En pronósticos, por ejemplo, los algoritmos establecidos como bosques aleatorios, boosting (como XGBoost), ARIMA, LSTM y regresión lineal suelen ofrecer rendimiento sólido. La IA generativa es poderosa para tareas creativas, pero las predicciones basadas en datos se benefician de ML tradicional. Para permitir que los agentes IA tomen decisiones basadas en datos, este enfoque combina modelos ML predictivos con MCP, un protocolo abierto que estandariza cómo las aplicaciones proporcionan contexto a los LLMs, en SageMaker AI. El objetivo es permitir que los agentes IA accedan a modelos alojados como herramientas, impulsando decisiones más informadas manteniendo costos razonables y rendimiento. Strands Agents es un SDK de código abierto que soporta un diseño guiado por modelos, facilitando el desarrollo de asistentes simples a flujos de trabajo autónomos complejos. Existen dos rutas para conectar agentes con endpoints de SageMaker: invocar endpoints directamente desde el código del agente o enrutar mediante MCP, permitiendo descubrimiento dinámico de herramientas y ejecución desacoplada. Para implementaciones escalables y seguras, se recomienda MCP, aunque se discute la ruta directa para dar opciones al lector. SageMaker AI ofrece dos maneras de alojar múltiples modelos detrás de un único endpoint: componentes de inferencia y endpoints multi-model. Esto permite optimizar recursos y reducir la latencia cuando hay varios modelos en juego. En la demostración se utiliza un solo modelo para claridad, pero se alienta a considerar estas alternativas para escenarios con varios modelos. La demostración describe un flujo en el que un usuario interactúa a través de una interfaz de chat o una app, el agente alimentado por LLM observa el entorno, planifica acciones y realiza predicción con el modelo alojado, y la predicción se devuelve al usuario o a sistemas empresariales. El código completo está disponible en GitHub, y se alienta a los lectores a explorar implementaciones reales y la documentación para profundizar.

Qué hay de nuevo

Este enfoque demuestra cómo potenciar agentes IA con modelos ML predictivos exponiéndolos como herramientas que los agentes pueden invocar en tiempo real. Las ideas clave incluyen:

- Integración de modelos ML predictivos alojados en SageMaker AI con agentes IA mediante Strands Agents SDK.

- Dos modos de invocación: acceso directo al endpoint de SageMaker y invocación mediante MCP para descubrir dinámicamente herramientas y gestionarlas a través del servidor MCP.

- Recomendación de MCP para despliegues escalables y seguros, manteniendo además un camino directo para escenarios simples.

- Demostración de alojar varios modelos detrás de un único endpoint SageMaker AI mediante componentes de inferencia o endpoints multi-model, optimizando recursos y reduciendo la latencia.

- Un flujo práctico: entrenar un modelo de series temporales (XGBoost), desplegarlo en SageMaker AI y exponerlo a un agente IA para toma de decisiones en tiempo real.

- Indicaciones sobre exponer el endpoint como herramienta Strands (mediante @tool) y cómo invocarlo desde un agente, con docstring para facilitar el uso guiado por modelo.

- El potencial de integrar predicciones en herramientas BI (p. ej., Amazon QuickSight) o sistemas empresariales (ERP/CRM) para operacionalizar insights.

Por qué importa (impacto para desarrolladores/empresas)

Al combinar ML predictivo con IA conversacional, las organizaciones pueden habilitar a sus agentes IA para tomar decisiones basadas en datos en tiempo real. Este enfoque reduce la barrera de adopción de ML y permite que equipos aprovechen las predicciones sin necesidad de una amplia experiencia en ML. MCP ofrece descubrimiento dinámico de herramientas y gobernanza centralizada, crucial para operaciones en producción y para mantener controles de seguridad. Para desarrolladores, este enfoque proporciona una plantilla para construir agentes que entiendan los datos, prevén resultados y se integren con sistemas de negocio. Para las empresas, acelera los ciclos de analytics a acción, facilita la integración de predicciones con sistemas operativos y fortalece la gobernanza mediante un servidor MCP centralizado.

Detalles técnicos o Implementación

El flujo sigue estas etapas:

- Datos y preparación del modelo: crear datos sintéticos de series temporales con tendencia, estacionalidad y ruido; realizar ingeniería de features para capturar efectos estacionales relevantes.

- Entrenamiento y despliegue: entrenar un modelo de regresión XGBoost usando el contenedor 1P de SageMaker AI, empaquetar y desplegar el modelo en un endpoint para inferencia en tiempo real.

- Invocación del endpoint: implementar una función como invoke_endpoint() con una docstring descriptiva para que pueda ser utilizada como herramienta por LLMs. Esta función puede convertirse en una herramienta Strands Agents mediante el decorador @tool y llamarse desde un agente Strands.

- Dos rutas de integración:

- Acceso directo al endpoint: el agente llama directamente al endpoint de SageMaker desde su código.

- Acceso mediante MCP: el cliente descubre herramientas expuestas por el servidor MCP, formatea la solicitud y llama al endpoint de inferencia a través de MCP.

- Servidor MCP y esquemas de herramientas: para uso a gran escala, implementar un servidor MCP (p. ej., con el marco FastMCP) que envuelva el endpoint de SageMaker y lo exponga como una herramienta con una interfaz definida. Un esquema de herramienta especifica claramente los parámetros de entrada y los valores de retorno para facilitar su uso por agentes IA.

- Consideraciones de recursos: SageMaker AI ofrece dos métodos para alojar múltiples modelos detrás de un único endpoint: componentes de inferencia y endpoints multi-model. Aunque el ejemplo utiliza un modelo único para claridad, las pautas señalan prácticas eficientes para manejar varios modelos.

- Flujo de extremo a extremo: un usuario interactúa mediante chat o app, el Strands Agent procesa la solicitud, decide invocar el modelo ML y la predicción se devuelve al usuario. El sistema puede generar gráficos, enviar valores a herramientas de BI o actualizar sistemas ERP/CRM.

- Notas prácticas: este patrón permite que los agentes accedan a capacidades ML sin experiencia profunda en ML y ofrece una vía pragmática para añadir inteligencia predictiva a los agentes IA.

Visión general de las opciones de invocación de herramientas

| Aspecto | Acceso directo al endpoint | Invocación MCP |---|---|---| | Mecanismo de descubrimiento | Llamadas de herramientas incrustadas en el código del agente | Descubrimiento dinámico a través del servidor MCP |Componente arquitectónico | No se requiere servidor MCP | Introduce un servidor MCP para mediar las llamadas |Patrón de seguridad | Permisos y llamadas gestionados a nivel de herramienta | Gobernanza centralizada y permisos a través del servidor MCP |Consideraciones de despliegue | Más simple para pruebas rápidas | Escalable y seguro para producción; admite múltiples herramientas |Recomendación | Útil para experimentos rápidos | Recomendado para despliegues escalables y seguros |

- Cómo elegir: para prototipos rápidos, las llamadas directas funcionan; para producción con descubrimiento dinámico y seguridad, MCP es preferible.

- Código y referencias: el código completo está disponible en GitHub; consulte la documentación de SageMaker AI para detalles sobre componentes de inferencia y endpoints multi-model.

Conclusiones clave

- Los modelos ML predictivos alojados en SageMaker AI pueden funcionar como herramientas dentro de agentes IA para mejorar las decisiones.

- MCP ofrece descubrimiento dinámico de herramientas y una arquitectura desacoplada entre agentes y herramientas, con un servidor MCP que gestiona ejecución y permisos.

- Strands Agents SDK facilita el desarrollo de agentes guiados por modelos, definiendo agentes con prompts y herramientas en lugar de integraciones a medida.

- SageMaker AI admite alojar múltiples modelos detrás de un único endpoint mediante componentes de inferencia o endpoints multi-model, optimizando recursos y latencia.

- El flujo mostrado abarca datos sintéticos, ingeniería de features, modelado con XGBoost, despliegue de endpoint e invocación por el agente para demostrar toma de decisiones predictivas en tiempo real.

FAQ

-

¿Qué problema resuelve MCP para los agentes IA?

MCP habilita descubrimiento dinámico de herramientas y desacopla la ejecución del agente de la ejecución de herramientas mediante un servidor MCP, mejorando gobernanza y seguridad.

-

¿Cómo puede un agente IA acceder a modelos de SageMaker AI?

El agente puede invocar endpoints directamente o usar MCP para descubrir y llamar a herramientas expuestas por el servidor MCP.

-

¿Qué opciones existen para alojar varios modelos detrás de un único endpoint?

SageMaker AI ofrece componentes de inferencia y endpoints multi-model para consolidar modelos bajo un endpoint único, optimizando recursos y latencia.

-

¿Cuál es el flujo completo del ejemplo?

Entrenar un modelo de series temporales, desplegarlo en SageMaker AI, exponerlo como una herramienta Strands, invocar desde el agente y presentar las predicciones al usuario o a sistemas downstream.

Referencias

More news

Llevar agentes de IA de concepto a producción con Amazon Bedrock AgentCore

Análisis detallado de cómo Amazon Bedrock AgentCore facilita la transición de aplicaciones de IA basadas en agentes desde un concepto de prueba hasta sistemas de producción empresariales, conservando memoria, seguridad, observabilidad y gestión escalable de herramientas.

Monitorear la inferencia por lotes de Bedrock de AWS con métricas de CloudWatch

Descubra cómo monitorear y optimizar trabajos de inferencia por lotes de Bedrock con métricas, alarmas y paneles de CloudWatch para mejorar rendimiento, costos y operación.

Solicitando precisión con Stability AI Image Services en Amazon Bedrock

Bedrock incorpora Stability AI Image Services con nueve herramientas para crear y editar imágenes con mayor precisión. Descubre técnicas de prompting para uso empresarial.

Escala la producción visual con Stability AI Image Services en Amazon Bedrock

Stability AI Image Services ya está disponible en Amazon Bedrock, ofreciendo capacidades de edición de imágenes listas para usar a través de la API de Bedrock y ampliando los modelos Stable Diffusion 3.5 y Stable Image Core/Ultra ya presentes.

Usar AWS Deep Learning Containers con Amazon SageMaker AI MLflow gestionado

Vea cómo los AWS Deep Learning Containers (DLCs) se integran con SageMaker AI gestionado por MLflow para equilibrar el control de la infraestructura y una gobernanza de ML sólida. Un flujo de TensorFlow para predicción de edad de abalones ilustra el seguimiento de extremo a extremo y la trazabilidad

Construir Flujos de Trabajo Agenticos con GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore

Visión general de extremo a extremo para implementar modelos GPT OSS de OpenAI en SageMaker AI y Bedrock AgentCore, impulsando un analizador de acciones multiagente con LangGraph, con cuantización MXFP4 de 4 bits y orquestación serverless.