Sam Altman sobre el fiasco del lanzamiento de GPT‑5, centros de datos, Chrome e interfaces cerebrales

TL;DR

- Sam Altman admitió que OpenAI “la cagó” en algunos aspectos del lanzamiento de GPT‑5 y devolvió la “calidez” del modelo 4o tras la reacción de usuarios.

- El tráfico de la API se duplicó en 48 horas; OpenAI está sin GPUs y Altman espera gastar billones en centros de datos.

- Altman confirmó que OpenAI planea financiar una startup de interfaz cerebro‑computadora y expresó ambiciones para apps independientes, experiencias sociales y evaluar Chrome si se vendiera.

Contexto y antecedentes

En San Francisco, Sam Altman y varios ejecutivos de OpenAI cenaron con un pequeño grupo de periodistas y respondieron preguntas durante horas; todo fue on the record salvo lo dicho en el postre. Los temas incluyeron el reciente lanzamiento de GPT‑5, las reacciones de usuarios, postura de producto, restricciones de infraestructura y movimientos estratégicos potenciales como considerar comprar Google Chrome si el gobierno de EE. UU. obligara a venderlo. Altman explicó que ChatGPT ha crecido rápidamente: se “cuadruplicó” su base de usuarios en un año y ahora llega a “más de 700 millones de personas cada semana”, situando ChatGPT entre los sitios más grandes del mundo. Ese alcance es clave para entender los retos técnicos y de producto que motivaron la conversación.

Qué hay de nuevo

- Respuesta al despliegue: Aproximadamente una hora antes de la cena, OpenAI lanzó una actualización para recuperar la “calidez” del modelo 4o, su anterior modelo predeterminado, como opción para suscriptores de pago. Altman dijo que él tomó la decisión de devolver 4o después de protestas en Reddit y X.

- Uso y capacidad: Altman informó que el tráfico de la API se duplicó en 48 horas tras el despliegue y que la compañía está “sin GPUs” mientras ChatGPT marca nuevos picos de usuarios diarios.

- Inversión e infraestructura: Altman declaró: “Ustedes deberían esperar que OpenAI gaste billones de dólares en la construcción de centros de datos en un futuro no muy lejano.” Las limitaciones de capacidad obligan a compromisos que impiden ofrecer modelos mejores o nuevos productos.

- Apuestas técnicas nuevas: Confirmó que OpenAI planea financiar una startup de interfaz neuronal para explorar que una persona piense algo y ChatGPT responda.

- Alcance del producto: La incorporación de Fidji Simo para dirigir “aplicaciones” implica aplicaciones independientes además de ChatGPT. Altman también insinuó ambiciones sociales con IA y dijo: “Si Chrome realmente va a venderse, deberíamos echarle un vistazo.”

- Postura pública: Altman dijo que estima el porcentaje de usuarios con relaciones insanas con ChatGPT en “muy por debajo del 1 por ciento” y que la empresa está teniendo “muchas” reuniones sobre el tema. Además afirmó que OpenAI no hará usos explotadores como “anime sex bots” y quiere que ChatGPT sea personal pero no alineado con una ideología específica.

Por qué importa (impacto para desarrolladores/empresas)

- Las limitaciones de capacidad afectan la disponibilidad de características y los plazos de despliegue. Empresas que dependen de las APIs de OpenAI deberían esperar variabilidad en acceso o restricciones mientras la demanda supera la oferta de GPUs.

- La previsión de inversión masiva en centros de datos indica planes de escalado a largo plazo, pero también conlleva implicaciones en costes y términos contractuales para clientes grandes.

- La confirmación de financiamiento a interfaces neuronales sugiere que nuevas modalidades de entrada (señales cerebrales) pueden formar parte del roadmap; desarrolladores y socios de hardware deben vigilar estándares y APIs.

- El desarrollo de apps independientes y funciones sociales implica nuevas superficies de producto que integradores y empresas deberán evaluar (SDKs, endpoints y requisitos de cumplimiento).

- La postura de producto de permitir que usuarios empujen la personalidad del modelo, manteniendo una posición central, tendrá impacto en moderación de contenido y ofertas de personalización.

Detalles técnicos o implementación

Tabla resumen de hechos técnicos y operativos mencionados por Altman:

| Tema | Hecho / Cita |

|---|---|

| Reversión de modelo | OpenAI devolvió la “calidez” del 4o como opción para suscriptores de pago; Altman dijo que tomó la decisión tras las protestas. |

| Pico de tráfico | El tráfico de la API se duplicó en 48 horas tras el despliegue. |

| Capacidad | OpenAI está “sin GPUs” y alcanza nuevos máximos diarios de usuarios. |

| Gasto en data centers | Altman: “Ustedes deberían esperar que OpenAI gaste billones de dólares…” |

| Interfaces neuronales | Altman confirmó planes para financiar una startup de interfaz neuronal. |

| Alcance del producto | Fidji Simo liderando “aplicaciones” sugiere apps independientes; Altman mencionó ambiciones sociales y el posible interés por Chrome. |

| Implicaciones operativas: |

- Espere limitaciones basadas en capacidad hasta que se amplíen recursos GPU.

- Prepárese para nuevos endpoints y requisitos de seguridad si emergen interfaces neuronales.

- Vigile anuncios de precios y cuotas vinculados a inversiones en infraestructura.

Conclusiones clave

- OpenAI reconoció errores en el lanzamiento de GPT‑5 y restauró el modelo 4o.

- La demanda aumentó de forma aguda y la empresa está encontrando límites de GPU.

- Altman anticipa gastos masivos en centros de datos para escalar.

- OpenAI explorará interfaces cerebro‑computadora mediante financiación de startups.

- La compañía ampliará su alcance más allá de ChatGPT con apps independientes y experiencias sociales.

FAQ

Referencias

- Reporte original: The Verge — I talked to Sam Altman about the GPT‑5 launch fiasco: https://www.theverge.com/command-line-newsletter/759897/sam-altman-chatgpt-openai-social-media-google-chrome-interview

More news

Anthropic endurece las reglas de uso de Claude ante un panorama de IA más peligroso

Anthropic prohíbe ayudar a desarrollar armas CBRN y explosivos de alto rendimiento, añade restricciones de ciberseguridad, ajusta su política política y aclara requisitos de alto riesgo.

Build a scalable containerized web application on AWS using the MERN stack with Amazon Q Developer – Part 1

In a traditional SDLC, a lot of time is spent in the different phases researching approaches that can deliver on requirements: iterating over design changes, writing, testing and reviewing code, and configuring infrastructure. In this post, you learned about the experience and saw productivity gains

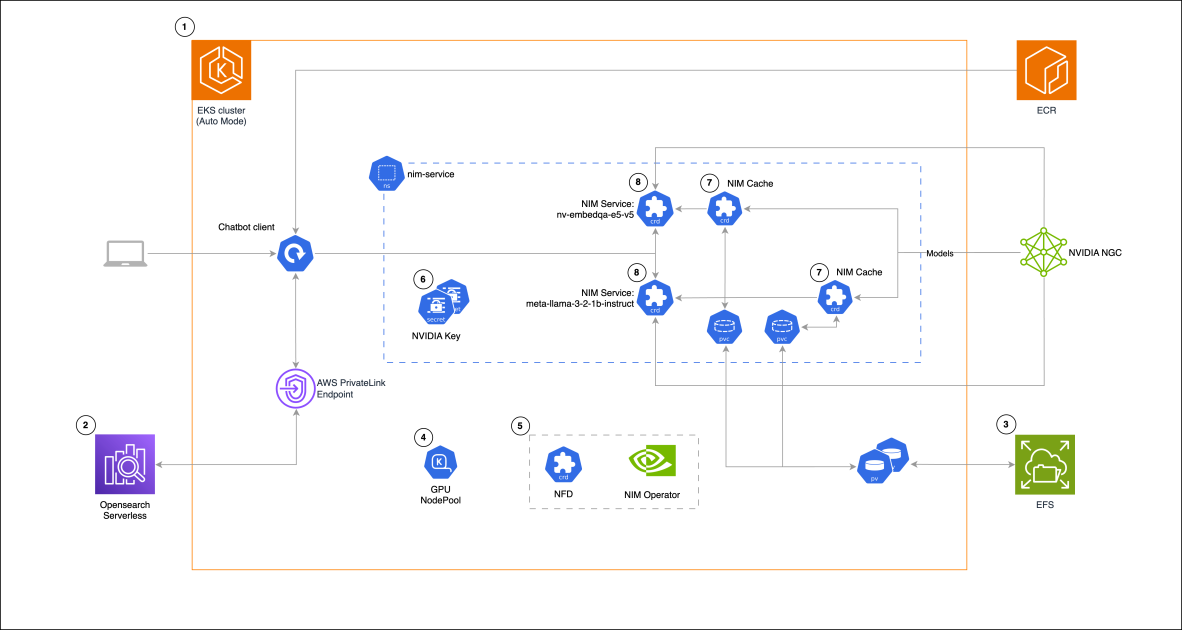

Building a RAG chat-based assistant on Amazon EKS Auto Mode and NVIDIA NIMs

In this post, we demonstrate the implementation of a practical RAG chat-based assistant using a comprehensive stack of modern technologies. The solution uses NVIDIA NIMs for both LLM inference and text embedding services, with the NIM Operator handling their deployment and management. The architectu

GPT-5 decepcionó las expectativas pero mejoró costo, velocidad y capacidad de programación

El lanzamiento de GPT-5 recibió reacciones mixtas: mejoras incrementales en benchmarks, reducción de costos y latencia, mejor desempeño en programación, pero críticas al tono de escritura y errores inesperados.

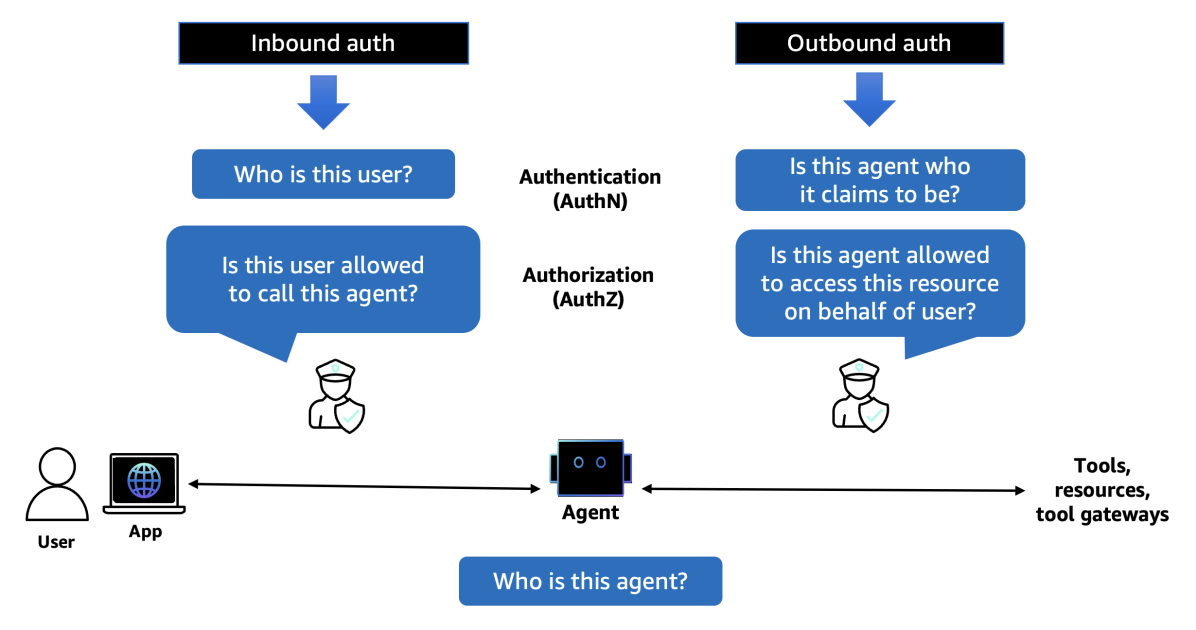

Introducing Amazon Bedrock AgentCore Gateway: Transforming enterprise AI agent tool development

In this post, we discuss Amazon Bedrock AgentCore Gateway, a fully managed service that revolutionizes how enterprises connect AI agents with tools and services by providing a centralized tool server with unified interface for agent-tool communication. The service offers key capabilities including S

Introducing Amazon Bedrock AgentCore Identity: Securing agentic AI at scale

In this post, we explore Amazon Bedrock AgentCore Identity, a comprehensive identity and access management service purpose-built for AI agents that enables secure access to AWS resources and third-party tools. The service provides robust identity management features including agent identity director