La detección de acento de entonación mejora el ASR preentrenado, investigación de Apple

Sources: https://machinelearning.apple.com/research/pitch-accent, machinelearning.apple.com

TL;DR

- Agregar un módulo de detección de acento de entonación a un ASR semisupervisado aporta mejoras medibles.

- Un modelo conjunto de ASR y detección de acento de entonación reduce en 41% la brecha de F1 en la tarea.

- En un ajuste fino con recursos limitados en LibriSpeech, el entrenamiento conjunto reduce el WER en 28,3%.

- El trabajo subraya la importancia de conservar o reaprender señales prosódicas como el acento de entonación en modelos de habla preentrenados.

Contexto y antecedentes

El Reconocimiento Automático de Voz (ASR) se ha beneficiado de representaciones de habla semisupervisadas, que aprovechan grandes conjuntos de datos sin etiquetar para aprender características útiles de la voz. La prosodia, y en particular las señales de acento de entonación, juegan un papel clave para entender el lenguaje hablado, pero estas señales a menudo quedan subrepresentadas en modelos preentrenados para ASR. Los investigadores de Apple abordan esta brecha mediante un módulo dedicado a la detección de acento de entonación que funciona junto al ASR. La idea es mantener o reaprender cues prosódicos durante el preentrenamiento y el ajuste fino, mejorando la interpretación de la conversación en entornos del mundo real con datos etiquetados limitados. Este trabajo se enmarca en la intersección entre habla y procesamiento de lenguaje natural y hace referencia a trabajos presentados en conferencias como Interspeech y ICASSP. La investigación destaca una tendencia más amplia en los sistemas de habla actuales: para maximizar el rendimiento, los modelos deben manejar no solo el contenido fonético, sino también la estructura prosódica. Al modelar explícitamente el acento de entonación, el sistema conjunto busca mejorar tanto los aspectos acústicos como lingüísticos de la comprensión, aumentando la robustez a dialectos, estilos de habla y ruido.

Qué hay de nuevo

La contribución central es un modelo conjunto que integra el reconocimiento de voz automático (ASR) y la detección de acento de entonación. El componente de detección de acento logra una mejora significativa en el estado del arte para la tarea, cuantificada como un incremento del 41% en la F1-score. Además, cuando los dos componentes se entrenan juntos, el rendimiento del ASR mejora bajo ajuste fino con recursos limitados: la WER en LibriSpeech se reduce en 28,3% en comparación con una línea base en las mismas condiciones restringidas. Este trabajo demuestra que continuar ampliando los modelos de habla preentrenados para conservar o reaprender pistas prosódicas destacadas, como el acento de entonación, puede generar avances significativos en las tareas de habla, no solo en prosodia sino también en la precisión general del ASR cuando los datos etiquetados son escasos.

Por qué importa (impacto para desarrolladores/empresas)

- Mayor precisión del ASR en entornos con recursos limitados: la mejora de WER reportada sugiere beneficios reales para implementaciones con datos etiquetados reducidos.

- Mejor preservación de prosodia en modelos preentrenados: centrarse en el acento de entonación subraya la importancia de las señales prosódicas para la interpretación real, con aplicaciones en transcripción, asistentes de voz y análisis de llamadas.

- Integración con pipelines existentes: el enfoque se apoya en representaciones semisupervisadas, lo que facilita la adopción en pipelines que ya utilizan modelos de habla preentrenados.

Detalles técnicos o implementación (visión general)

- Diseño del modelo: se propone un modelo conjunto de ASR y detección de acento de entonación, donde el detector de acento actúa como un módulo complementario integrado en el sistema de ASR. El entrenamiento conjunto permite que ambas partes aprovechen representaciones compartidas aprendidas a partir de datos de habla semisupervisados.

- Datos y evaluación: los avances se muestran en LibriSpeech bajo ajuste fino con recursos limitados, destacando la efectividad del enfoque cuando los datos etiquetados son escasos. El énfasis está en el acento de entonación, alineado con esfuerzos más amplios para conservar pistas prosódicas en modelos preentrenados.

- Métricas: los resultados clave incluyen una mejora del 41% en la F1-score para la detección de acento y una reducción del 28,3% en el WER para el ASR bajo ajuste fino con pocos recursos.

- Contexto y trabajos relacionados: la aproximación refleja la investigación continua en habla y procesamiento de lenguaje natural, con referencias a conferencias relevantes. Apple participó en ICASSP y contribuyó al avance de la prosodia en modelos de habla preentrenados.

Conclusiones clave

- Modelos conjuntos de ASR y detección de acento de entonación ofrecen mejoras significativas en la detección prosódica y en la precisión del ASR cuando los recursos son limitados.

- Mantener o reaprender índices prosódicos durante el preentrenamiento puede mejorar tareas de habla más allá del reconocimiento fonético tradicional.

- El enfoque resalta el valor de las representaciones semisupervisadas para incorporar información prosódica en modelos de habla.

- Abre una vía prometedora para mejorar implementaciones de ASR en entornos con datos etiquetados limitados.

Preguntas Frecuentes (FAQ)

- Q: ¿Cuál es la idea principal del modelo conjunto ASR y detección de acento? A: El modelo combina el reconocimiento de voz con un componente dedicado a la detección de acento de entonación, entrenados de forma conjunta para aprovechar representaciones compartidas y preservar cues prosódicos.

- Q: ¿Qué mejoras de rendimiento se reportan? A: La detección de acento alcanza una mejora del 41% en la F1-score; el ASR, en ajuste fino con recursos limitados, reduce el WER en 28,3% en LibriSpeech.

- Q: ¿En qué datos y configuración se midieron las mejoras? A: Las mejoras se demostraron en LibriSpeech bajo ajuste fino con recursos limitados, utilizando representaciones de habla semisupervisadas.

- Q: ¿Por qué es importante el acento de entonación para los sistemas ASR? A: El acento de entonación es una pista prosódica clave que ayuda a desambiguar el significado y la estructura de la habla; conservar o reaprender estas señales puede mejorar la precisión.

- Q: ¿Cómo podría influir esto en implementaciones reales? A: En despliegues con datos etiquetados limitados, integrar la detección de acento podría mejorar la calidad de las transcripciones y la robustez frente a diferentes estilos de habla.

Referencias

More news

Las listas de verificación superan a los modelos de recompensa para alinear modelos de lenguaje

Un enfoque de RL utiliza listas de verificación derivadas de instrucciones para guiar el alineamiento, superando modelos de recompensa fijos en múltiples benchmarks con Qwen2.5-7B-Instruct, presentado en ICLR 2025.

SlowFast-LLaVA-1.5: LLMs de vídeo eficientes en tokens para comprensión de larga duración

La investigación de Apple ML presenta SlowFast-LLaVA-1.5 (SF-LLaVA-1.5), una familia de LLMs de vídeo con eficiencia de tokens para la comprensión de vídeos largos, usando el mecanismo SlowFast de dos flujos y datos públicos para lograr resultados de vanguardia entre 1B y 7B.

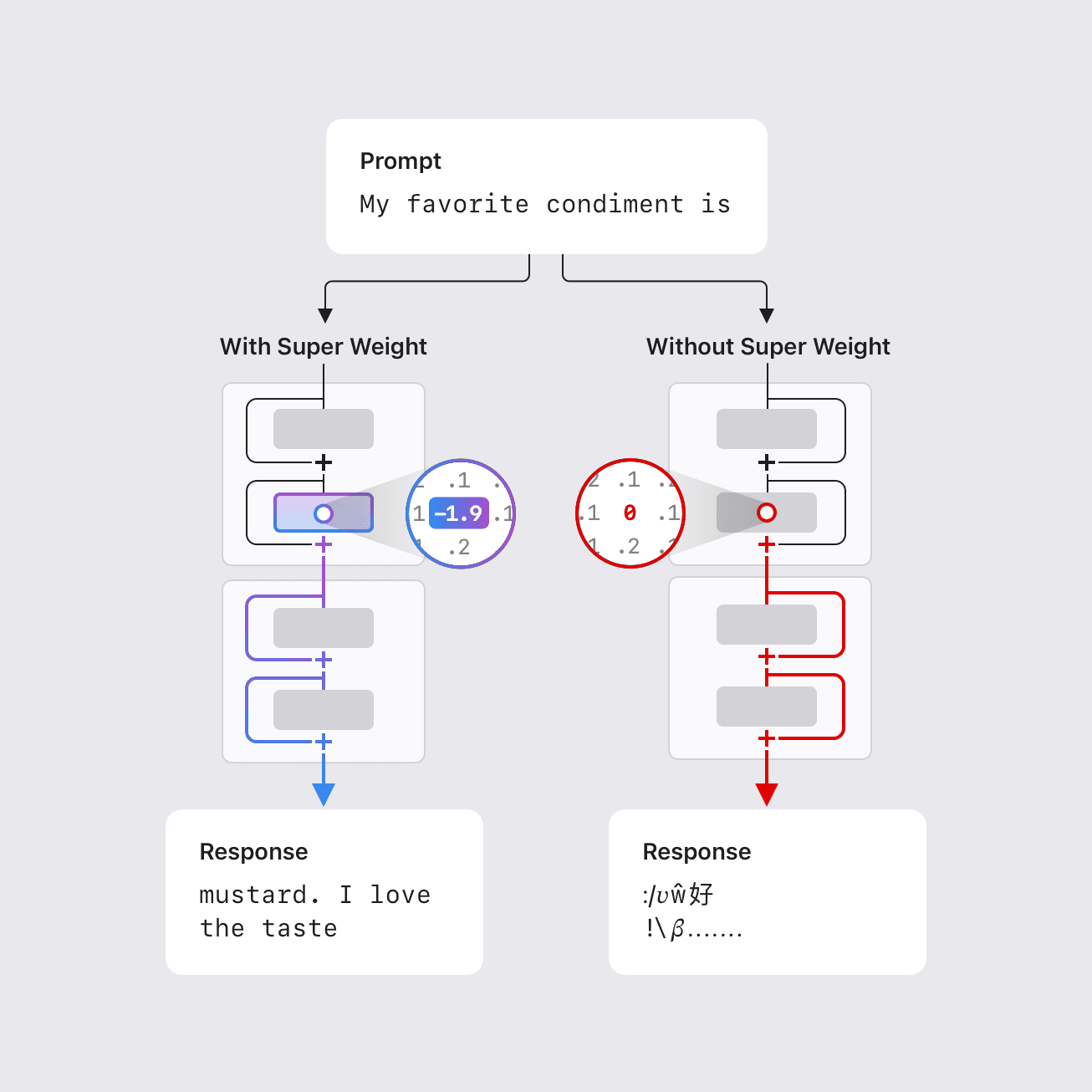

El 'Super Weight': Cómo un solo parámetro puede determinar el comportamiento de un gran modelo de lenguaje

Investigadores de Apple identifican 'super weights'—un subconjunto extremadamente pequeño de parámetros de LLM—que pueden influir decisivamente en el comportamiento del modelo, con implicaciones de compresión y dinámica interna.

Investigar sesgo interseccional en grandes modelos de lenguaje mediante disparidades de confianza en la resolución de correferencias

Un nuevo benchmark, WinoIdentity, expone sesgo interseccional en LLMs al combinar marcadores demográficos con género, e introduce Coreference Confidence Disparity para medir la incertidumbre entre identidades. Cinco LLMs muestran disparidades de confianza de hasta 40%.

Reconsiderando la factoración de matrices no negativas con representaciones neuronales implícitas

Investigadores de Apple reformulan la NMF con funciones aprendibles para ir más allá de datos muestreados regularmente, permitiendo analizar representaciones TF irregulares como Constant-Q y wavelets. Presentado en WASPAA 2025.

Misty: Prototipado de UI mediante mezcla conceptual interactiva

Misty presenta un flujo de prototipado UI que permite a los desarrolladores incorporar rápidamente elementos de ejemplos de diseño en interfaces en desarrollo, inspirado en la mezcla conceptual. Un estudio exploratorio con 14 desarrolladores frontend destaca su potencial para fomentar la creatividad