GPT-5 decepcionó las expectativas pero mejoró costo, velocidad y capacidad de programación

Sources: https://www.theverge.com/openai/759755/gpt-5-failed-the-hype-test-sam-altman-openai

TL;DR

- GPT-5 llegó tras un periodo de gran hype, pero muchos usuarios y expertos lo encontraron menos impresionante de lo que prometía la promoción.

- El modelo aporta mejoras prácticas: costo más bajo, respuestas más rápidas, menos alucinaciones, un nuevo sistema de conmutación (switch) y avances destacados en tareas de programación.

- Usuarios criticaron el tono de escritura como más austero y menos elocuente; en redes sociales surgieron ejemplos de errores factuales y etiquetas de mapas incorrectas.

- OpenAI priorizó utilidad y accesibilidad; ante críticas se restauró temporalmente un modelo anterior (GPT-4o) en ChatGPT.

Contexto y antecedentes

La expectación por GPT-5 se había ido acumulando desde el lanzamiento de GPT-4 en 2023. El CEO de OpenAI, Sam Altman, avivó las expectativas describiendo a GPT-5 como “something that I just don’t wanna ever have to go back from,” y comparándolo con un hito de producto. La noche anterior al livestream de anuncio compartió una imagen que elevó aún más la anticipación. En foros como Reddit y en X, usuarios pidieron fechas y características; en una AMA de octubre, Altman citó limitaciones de compute y la complejidad creciente de los modelos como motivos para el ritmo de lanzamientos. Al aparecer GPT-5 en ChatGPT, la recepción pública fue ambivalente: quienes esperaban una mejora radical hallaron sobre todo avances incrementales, con las mejoras más claras en costo, velocidad, programación y reducción de alucinaciones.

Qué hay de nuevo

Cambios y características reportadas de GPT-5:

- Menor costo por consulta y tiempos de respuesta más rápidos en comparación con modelos anteriores.

- Menos alucinaciones y mejor calibración: el modelo tiende más a decir “no sé”, separa hechos de conjeturas y puede respaldar respuestas con citas cuando se solicita.

- Un sistema automático de “switch” que dirige, en el backend, la consulta del usuario al modelo más adecuado, sin que el usuario tenga que elegir.

- Mejora notable en programación: una variante de GPT-5 encabezó una leaderboard popular de modelos IA en la categoría de código, con Claude de Anthropic en segundo lugar.

- Material de lanzamiento que mostró juegos generados por IA (un mini-juego de bola rodante y una carrera de velocidad de tipeo), una herramienta de pixel art, un simulador de batería y un visualizador lofi. OpenAI también describió GPT-5 como su “mejor sistema de IA hasta ahora” y un “salto significativo en inteligencia” en áreas como programación, matemáticas, redacción, salud y percepción visual.

Por qué importa (impacto para desarrolladores/empresas)

- Costo y latencia: la reducción de costos operativos y la mayor rapidez en respuestas afectan directamente la relación coste-beneficio para despliegues empresariales y a escala. Empresas que pagan por consulta o requieren baja latencia pueden beneficiarse.

- Productividad en programación: el mejor desempeño en tareas de código tiene un claro potencial de ingresos. Plataformas de desarrollo y equipos de ingeniería pueden aprovechar GPT-5 para generación, revisión y automatización de código.

- Reducción de alucinaciones y mejor calibración: más transparencia sobre la incertidumbre y la capacidad de citar fuentes puede mitigar riesgos en aplicaciones críticas (por ejemplo, salud o legal), aunque su eficacia real requiere evaluaciones completas.

- Sistema de switch: el enrutamiento automático facilita la experiencia e integración técnica, evitando que los desarrolladores gestionen manualmente varias variantes de modelos. Sin embargo, las quejas sobre regresiones en la calidez o matices del lenguaje pueden afectar la adopción en productos orientados al consumidor y en contextos que demandan empatía y estilo.

Detalles técnicos o de implementación

- Enfoque de OpenAI: la empresa señaló que, más que perseguir únicamente grandes saltos, se enfocó en utilidad real y accesibilidad masiva.

- Limitaciones de compute: en una AMA de Reddit, Sam Altman explicó que el compute y la complejidad de los modelos limitan cuántos desarrollos pueden entregarse en paralelo.

- Sistema de switch: GPT-5 incorpora un mecanismo que asigna automáticamente las consultas al modelo variante más apto, un cambio a nivel de sistema pensado para mejorar la experiencia del usuario final.

- Benchmarks: en muchas pruebas industriales GPT-5 superó a sus predecesores, pero expertos describieron las mejoras como pequeñas e incrementales. El panorama de benchmarks es volátil y las empresas a veces eligen qué resultados mostrar.

- Ranking en codificación: una iteración de GPT-5 llegó al primer puesto en una leaderboard popular para la categoría de código, con Anthropic’s Claude en segundo lugar, mostrando progreso tangible en tareas orientadas a desarrolladores.

Conclusiones clave

- GPT-5 ofrece mejoras prácticas importantes: menor costo, respuestas más rápidas, menos alucinaciones y mejor desempeño en programación.

- El lanzamiento no cumplió con la elevada expectativa generada por el hype y la promoción.

- OpenAI priorizó utilidad y accesibilidad, además de mejoras a nivel de sistema (como el switch), en lugar de un salto disruptivo en capacidades.

- Surgieron compromisos en la experiencia: muchos usuarios percibieron la redacción como menos matizada y hubo ejemplos virales de errores factuales.

- Para empresas y desarrolladores, las mejoras incrementales en velocidad, costo y fiabilidad pueden ser más valiosas que promesas impactantes.

FAQ

Referencias

- Reporte y análisis original: https://www.theverge.com/openai/759755/gpt-5-failed-the-hype-test-sam-altman-openai

More news

Anthropic endurece las reglas de uso de Claude ante un panorama de IA más peligroso

Anthropic prohíbe ayudar a desarrollar armas CBRN y explosivos de alto rendimiento, añade restricciones de ciberseguridad, ajusta su política política y aclara requisitos de alto riesgo.

Build a scalable containerized web application on AWS using the MERN stack with Amazon Q Developer – Part 1

In a traditional SDLC, a lot of time is spent in the different phases researching approaches that can deliver on requirements: iterating over design changes, writing, testing and reviewing code, and configuring infrastructure. In this post, you learned about the experience and saw productivity gains

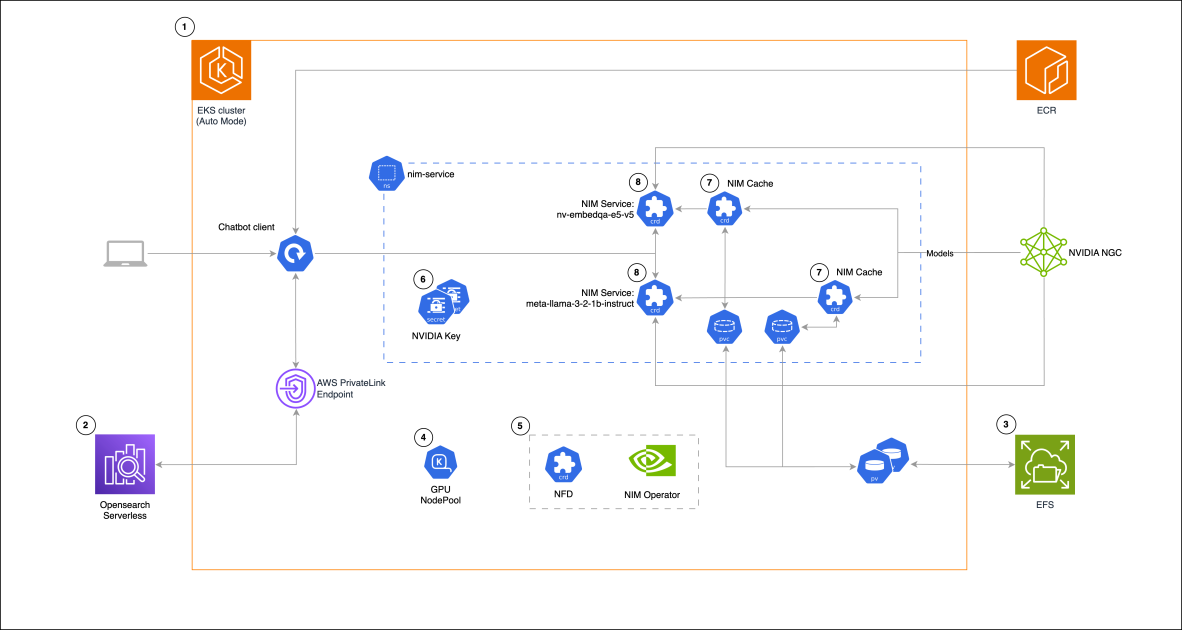

Building a RAG chat-based assistant on Amazon EKS Auto Mode and NVIDIA NIMs

In this post, we demonstrate the implementation of a practical RAG chat-based assistant using a comprehensive stack of modern technologies. The solution uses NVIDIA NIMs for both LLM inference and text embedding services, with the NIM Operator handling their deployment and management. The architectu

Introducing Amazon Bedrock AgentCore Gateway: Transforming enterprise AI agent tool development

In this post, we discuss Amazon Bedrock AgentCore Gateway, a fully managed service that revolutionizes how enterprises connect AI agents with tools and services by providing a centralized tool server with unified interface for agent-tool communication. The service offers key capabilities including S

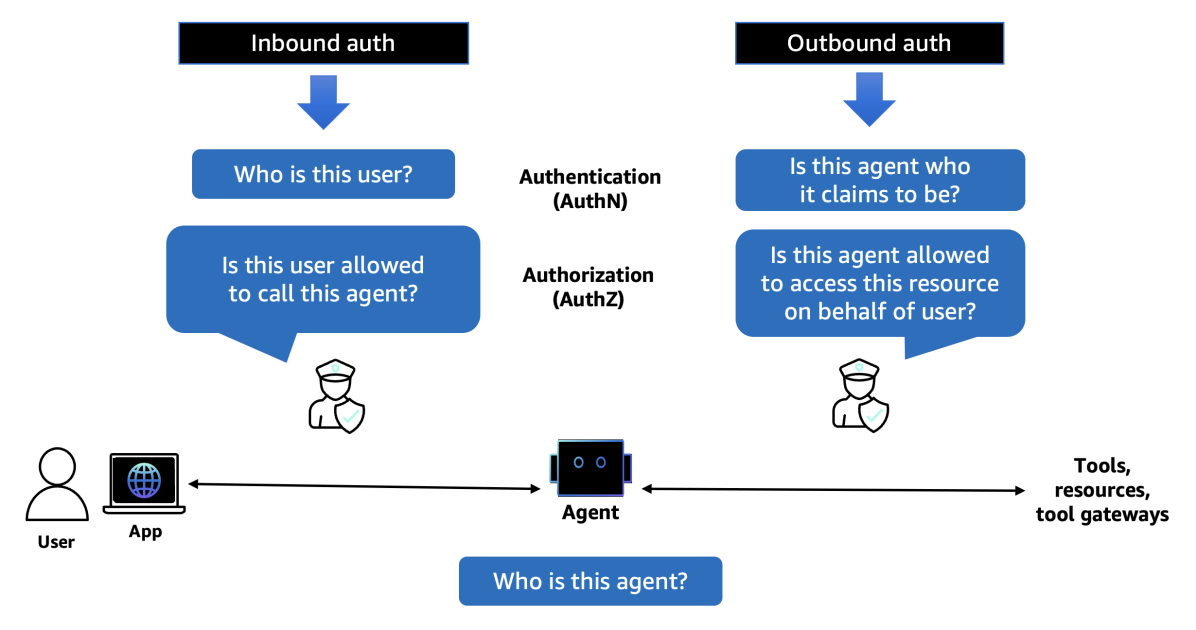

Introducing Amazon Bedrock AgentCore Identity: Securing agentic AI at scale

In this post, we explore Amazon Bedrock AgentCore Identity, a comprehensive identity and access management service purpose-built for AI agents that enables secure access to AWS resources and third-party tools. The service provides robust identity management features including agent identity director

Sam Altman sobre el fiasco del lanzamiento de GPT‑5, centros de datos, Chrome e interfaces cerebrales

Altman reconoció errores en el despliegue de GPT‑5, la falta de GPUs, planes para gastar billones en data centers, financiar interfaces cerebro‑computadora y evaluar Chrome si se vendiera.