Anthropic endurece las reglas de uso de Claude ante un panorama de IA más peligroso

Sources: https://www.theverge.com/news/760080/anthropic-updated-usage-policy-dangerous-ai-landscape

TL;DR

- Anthropic actualizó la política de uso de Claude para prohibir explícitamente la asistencia en el desarrollo de armas biológicas, químicas, radiológicas y nucleares (CBRN) y explosivos de alto rendimiento.

- Se añadió una sección ‘No comprometer sistemas informáticos o redes’ que prohíbe descubrir o explotar vulnerabilidades, crear malware y desarrollar herramientas de denegación de servicio.

- En mayo, Anthropic implementó protecciones ‘AI Safety Level 3’ junto con el lanzamiento de Claude Opus 4 para dificultar los jailbreaks y reducir la asistencia en temas CBRN.

- Características agentivas como Computer Use y Claude Code se identifican como riesgos que pueden facilitar abuso a escala y ataques cibernéticos.

- La política sobre contenido político se suavizó para prohibir solo casos engañosos o disruptivos para procesos democráticos y el direccionamiento de votantes/campañas.

Contexto y antecedentes

Anthropic publicó una actualización de la política de uso de su chatbot Claude en respuesta a crecientes preocupaciones sobre seguridad. La compañía anteriormente prohibía usar Claude para ‘producir, modificar, diseñar, comercializar o distribuir armas, explosivos, materiales peligrosos u otros sistemas diseñados para causar daño o pérdida de vidas humanas’. Una comparación entre la política antigua y la nueva muestra que Anthropic ha ampliado y aclarado esa prohibición en varias áreas específicas. En mayo, Anthropic implementó protecciones ‘AI Safety Level 3’ junto al lanzamiento de Claude Opus 4. Esas salvaguardas buscan hacer que el modelo sea más difícil de ‘jailbreakear’ y ayudar a prevenir que asista en el desarrollo de armas CBRN. La compañía también reconoció los riesgos que plantean las herramientas agentivas, incluyendo Computer Use, que permite a Claude tomar control del ordenador de un usuario, y Claude Code, una herramienta que integra Claude en el terminal de un desarrollador. Anthropic escribe que estas capacidades poderosas introducen riesgos como el abuso a escala, la creación de malware y ataques cibernéticos. Consulte la cobertura original en: The Verge.

Qué hay de nuevo

Los cambios y aclaraciones principales incluyen:

- Prohibición explícita de usar Claude para ayudar a desarrollar armas biológicas, químicas, radiológicas o nucleares (CBRN).

- Prohibición específica de asistencia con explosivos de alto rendimiento.

- Nueva sección ‘No comprometer sistemas informáticos o redes’ que prohíbe descubrir o explotar vulnerabilidades, crear o distribuir malware y desarrollar herramientas de denegación de servicio.

- Flexibilización de la política sobre contenido político: ya no se prohíbe todo contenido relacionado con campañas y lobby, sino que se prohíben los casos que sean engañosos o disruptivos para procesos democráticos y el direccionamiento de votantes/campañas.

- Aclaración de que los requisitos para casos de ‘alto riesgo’ se aplican a escenarios de recomendación de cara al consumidor y no al uso empresarial interno. Estas modificaciones amplían la prohibición anterior al nombrar categorías de alto riesgo y añadir restricciones ligadas a capacidades agentivas.

Por qué importa (impacto para desarrolladores/empresas)

- Cumplimiento y gestión de riesgos: Los desarrolladores y organizaciones que utilicen Claude deben revisar la política actualizada para asegurar que sus aplicaciones no violen las prohibiciones explícitas relativas a CBRN, explosivos de alto rendimiento o las nuevas restricciones de ciberseguridad.

- Las funciones agentivas requieren supervisión adicional: Computer Use y Claude Code pueden realizar acciones más allá de la generación de texto. La propia actualización destaca el riesgo de abuso a escala y ataques cibernéticos, lo que implica controles adicionales para integraciones.

- Diseño y despliegue de productos: Equipos que desarrollen sistemas de recomendación orientados al consumidor con Claude deben cumplir los requisitos de alto riesgo. Anthropic aclaró que esto se aplica a escenarios de cara al consumidor, no al uso interno empresarial.

- Implicaciones políticas y de cumplimiento: El cambio en la política política se centra en usos engañosos y en el direccionamiento de votantes. Las organizaciones que trabajen en tecnología de campañas o cabildeo deberían reevaluar su uso de Claude.

Detalles técnicos o de implementación

La actualización combina cambios de política con protecciones a nivel de modelo. Puntos relevantes:

- AI Safety Level 3 y Claude Opus 4: Implementados en mayo para dificultar jailbreaks y reducir la asistencia en el desarrollo de CBRN.

- Funciones agentivas mencionadas:

| Función agentiva | Descripción en la actualización |

|---|---|

| Computer Use | Permite a Claude ejecutar acciones en el ordenador de un usuario; citado como causa de riesgos de abuso a escala y ataques cibernéticos |

| Claude Code | Integra Claude en el terminal del desarrollador; citado entre funciones que introducen riesgos de malware y seguridad |

- Nuevas prohibiciones de ciberseguridad: La sección ‘No comprometer sistemas informáticos o redes’ prohíbe el uso de Claude para descubrir/explotar vulnerabilidades, crear/distribuir malware y desarrollar herramientas de DDoS.

- Comparación de la política de armas: | Tema | Política anterior | Política nueva |---|---:|---| | Armas y explosivos | Prohibía producir, modificar, diseñar, comercializar o distribuir armas, explosivos, materiales peligrosos u otros sistemas que causen daño o pérdida de vidas | Ampliada para prohibir explícitamente la asistencia en el desarrollo de explosivos de alto rendimiento y armas CBRN |

Conclusiones clave

- Prohibición explícita de asistencia en armas CBRN y explosivos de alto rendimiento.

- Sección de ciberseguridad que prohíbe descubrir vulnerabilidades, crear malware y herramientas de DDoS.

- Protecciones AI Safety Level 3 con Claude Opus 4 para reducir jailbreaks y limitar asistencia en CBRN.

- Funciones agentivas como Computer Use y Claude Code identificadas como riesgos y sujetas a salvaguardas.

- Política política afinada para centrarse en usos engañosos, disruptivos o de direccionamiento de votantes; requisitos de alto riesgo aplicados a escenarios de consumidor.

FAQ

Referencias

- Cobertura de la actualización de la política de Anthropic: The Verge

More news

Build a scalable containerized web application on AWS using the MERN stack with Amazon Q Developer – Part 1

In a traditional SDLC, a lot of time is spent in the different phases researching approaches that can deliver on requirements: iterating over design changes, writing, testing and reviewing code, and configuring infrastructure. In this post, you learned about the experience and saw productivity gains

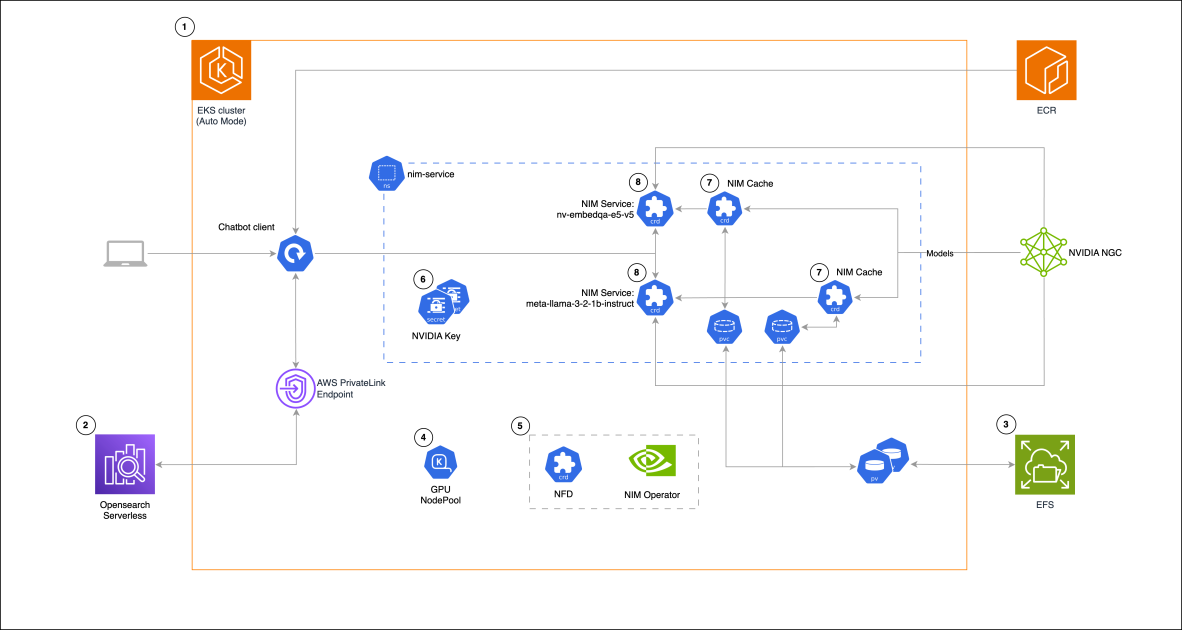

Building a RAG chat-based assistant on Amazon EKS Auto Mode and NVIDIA NIMs

In this post, we demonstrate the implementation of a practical RAG chat-based assistant using a comprehensive stack of modern technologies. The solution uses NVIDIA NIMs for both LLM inference and text embedding services, with the NIM Operator handling their deployment and management. The architectu

GPT-5 decepcionó las expectativas pero mejoró costo, velocidad y capacidad de programación

El lanzamiento de GPT-5 recibió reacciones mixtas: mejoras incrementales en benchmarks, reducción de costos y latencia, mejor desempeño en programación, pero críticas al tono de escritura y errores inesperados.

Introducing Amazon Bedrock AgentCore Gateway: Transforming enterprise AI agent tool development

In this post, we discuss Amazon Bedrock AgentCore Gateway, a fully managed service that revolutionizes how enterprises connect AI agents with tools and services by providing a centralized tool server with unified interface for agent-tool communication. The service offers key capabilities including S

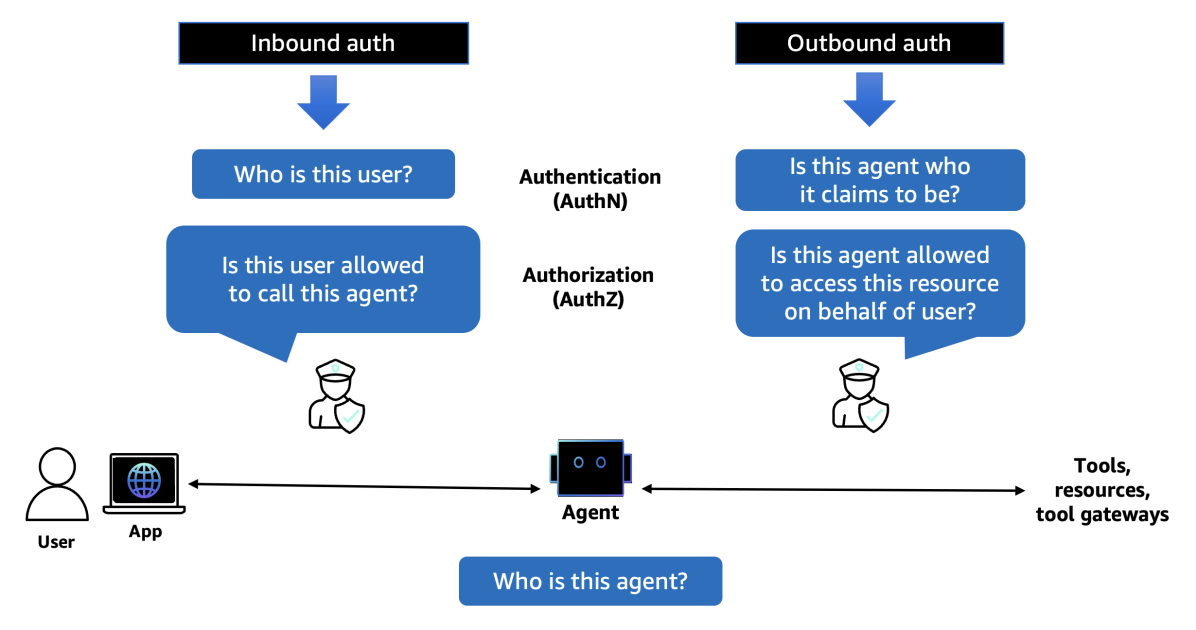

Introducing Amazon Bedrock AgentCore Identity: Securing agentic AI at scale

In this post, we explore Amazon Bedrock AgentCore Identity, a comprehensive identity and access management service purpose-built for AI agents that enables secure access to AWS resources and third-party tools. The service provides robust identity management features including agent identity director

Sam Altman sobre el fiasco del lanzamiento de GPT‑5, centros de datos, Chrome e interfaces cerebrales

Altman reconoció errores en el despliegue de GPT‑5, la falta de GPUs, planes para gastar billones en data centers, financiar interfaces cerebro‑computadora y evaluar Chrome si se vendiera.