Dynamo 0.4 ofrece 4x más rendimiento, autoscaling basado en SLO y observabilidad en tiempo real

Sources: https://developer.nvidia.com/blog/dynamo-0-4-delivers-4x-faster-performance-slo-based-autoscaling-and-real-time-observability, developer.nvidia.com

TL;DR

- Dynamo 0.4 presenta un servicio desagregado que separa las fases de prefill y decode entre GPUs, permitiendo un uso de recursos más flexible y mayor eficiencia.

- En benchmarks, se observa hasta 4x más interactividad para el modelo gpt-oss-120b en NVIDIA B200 con TensorRT-LLM, y 2.5x más throughput para el DeepSeek-R1 671B en GB200 NVL72, sin costos de inferencia adicionales. NVIDIA Dynamo 0.4 release.

- Nueva herramienta AIConfigurator que recomienda configuraciones óptimas de PD desagregación y estrategias de paralelismo de modelo, ajustadas al modelo y al presupuesto de GPU, manteniendo SLO.

- Planner con autoscalado basado en SLO: integración nativa con Kubernetes y mejoras de observabilidad, junto con características de tolerancia a fallos.

- El release ofrece scripts de código abierto y guías de implementación para despliegues MoE en múltiples nodos y soporte inicial de TensorRT-LLM en Hopper, con soporte nativo para vLLM.

Contexto y antecedentes

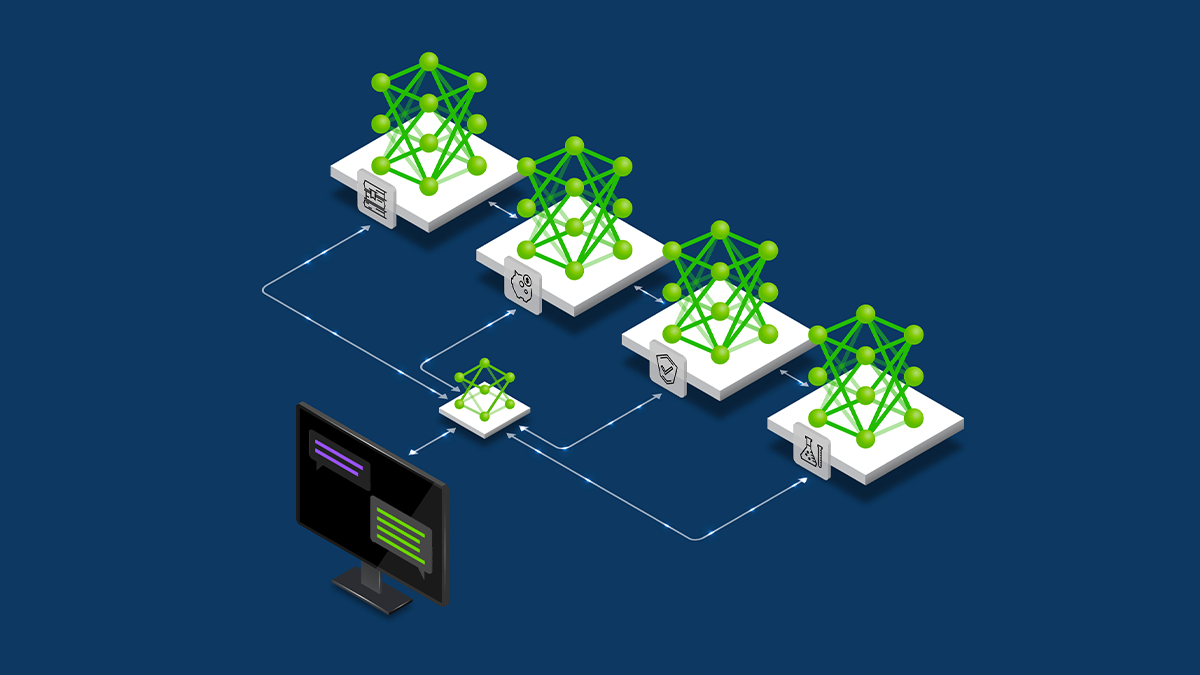

El rápido auge de modelos frontera en código abierto, como gpt-oss de OpenAI y Kimi K2 de Moonshot AI, ha acelerado el interés en la inferencia a gran escala con costos razonables. Dynamo 0.4, lanzado hoy, avanza las capacidades para desplegar grandes modelos en configuraciones de servicio desagregado. La actualización se centra en mejoras de rendimiento, observabilidad y autoscalado basado en SLOs. Estas tendencias se alinean con la necesidad de una inferencia de IA de gran tamaño que sea confiable y predecible para entornos de producción. NVIDIA Dynamo 0.4 release. Dynamo utiliza un enfoque de servicio desagregado que reparte el flujo de inferencia entre GPUs distintas, permitiendo asignaciones más flexibles y paralelismo específico para cada fase, lo que incrementa la eficiencia general. Esta versión también enfatiza la observabilidad y la tolerancia a fallas como capacidades fundamentales para entornos multinodo de inferencia, donde las interrupciones pueden afectar la experiencia del usuario. El objetivo es facilitar la adopción de arquitecturas MoE con mayor previsibilidad y fiabilidad. NVIDIA Dynamo 0.4 release.

Novedades

Dynamo 0.4 trae varias capacidades para investigadores, ingenieros y empresas que buscan desplegar modelos grandes a escala con costo efectivo:

- Servicio desagregado entre GPUs: las fases de prefill y decode se separan para permitir una asignación de recursos más flexible y paralelismo por etapa.

- AIConfigurator: nueva herramienta que recomienda configuraciones óptimas de desagregación PD y estrategias de paralelismo, ajustadas al modelo y al presupuesto de GPU; puede generar automáticamente configuraciones backend Dynamo. Soporte inicial para TensorRT-LLM en NVIDIA Hopper.

- Planner con autoscalado basado en SLO: continúa el trabajo de May 0.2 y añade escalado proactivo para cumplir objetivos de rendimiento. Integración nativa con Kubernetes y soporte inicial para vLLM, con más frameworks próximamente.

- Observabilidad: Dynamo emite métricas de observabilidad a través de Prometheus; métricas pueden consumirse por Grafana y otras herramientas open-source; API para métricas personalizadas.

- Tolerancia a fallas y resiliencia: re-enrutamiento de requests en vuelo hacia GPUs online, preservando cálculos intermedios y evitando trabajo redundante; detección de fallas más rápida al evitar etcd.

- Scripts y guías de implementación: scripts de reproducción de resultados y guías para escenarios MoE en multi-nodo, incluyendo DeepSeek-R1 con SGLang y Llama4 Maverick con TensorRT-LLM en Dynamo. NVIDIA Dynamo 0.4 release.

Por qué importa (impacto para desarrolladores/empresas)

Para equipos que operan servicios de inferencia de IA a gran escala, Dynamo 0.4 ofrece mejoras tangibles en throughput, latencia, costo y confiabilidad. El servicio desagregado permite un uso más eficiente de recursos GPU, aumentando la utilización y facilitando el escalado para secuencias largas comunes en flujos de trabajo de agentes, generación de código y resúmenes. AIConfigurator y autoscalado basado en SLO ayudan a planificar capacidad con mayor precisión sin sobredimensionar. La observabilidad mejorada facilita diagnósticos en tiempo real y la resiliencia en entornos multinodo. En conjunto, estas actualizaciones permiten a investigadores, ingenieros y empresas explorar arquitecturas MoE y administrar grandes modelos con presupuestos más previsibles y rendimiento confiable, especialmente para entornos que ya trabajan con Kubernetes.

Detalles técnicos o Implementación

El núcleo sigue siendo el servicio desagregado: separar prefill y decode entre GPUs distintas para optimizar la asignación de recursos y el paralelismo del modelo según la carga. Esta separación mejora la eficiencia general y facilita estrategias de escalado basadas en la estructura del modelo y el tráfico. AIConfigurator propone un enfoque basado en datos: analiza rendimiento medido previamente por capas del modelo (atención, FFN, comunicaciones y memoria), compara batching estático, batching en vuelo y servicio desagregado, y produce configuraciones PD que satisfacen SLOs dentro del presupuesto de GPU. Puede generar configuraciones backend Dynamo automáticamente y ofrece interfaces CLI y web; soporte inicial para TensorRT-LLM en Hopper y expansión futura a otros marcos y hardware. Planner con autoscalado basado en SLO ofrece dimensionamiento proactivo monitorizando la profundidad de la cola de prefill y el uso de memoria de decode para ajustar dinámicamente el número de workers. La integración con Kubernetes facilita la adopción en entornos basados en containers. Planner añade soporte para vLLM y otros frameworks de inferencia en futuras versiones. Observabilidad: métricas emitidas por workers y componentes están disponibles a través de Prometheus; API para métricas personalizadas permite adaptar la observabilidad a entornos específicos. Estas capacidades sientan las bases para métricas más granulares y específicas de PD desagregado en futuras entregas. Tolerancia a fallas: mejoras en resiliencia con re-enrutamiento en vuelo para evitar pérdidas de cálculos y detección rápida de fallas al saltar el etcd cuando corresponde. Scripts y guías de implementación ayudan a reproducir resultados y desplegar MoE en escenarios multi-nodo. NVIDIA Dynamo 0.4 release.

Ideas clave (takeaways)

- Servicio desagregado entre GPUs para una mayor eficiencia.

- Benchmarks: hasta 4x más interactividad para gpt-oss-120b en B200 con TensorRT-LLM y 2,5x throughput para DeepSeek-R1 671B en NVL72, sin costos adicionales.

- AIConfigurator ofrece recomendaciones de PD y estrategias de paralelismo con generación automática de configuraciones.

- Planner con autoscalado basado en SLO e integración con Kubernetes para dimensionamiento proactivo.

- Mejoras de observabilidad mediante Prometheus y API de métricas personalizadas.

- Mejoras de tolerancia a fallas con re-enrutamiento en vuelo y detección más rápida.

- Scripts y guías de implementación para despliegues MoE multi-nodo.

FAQ

-

¿Qué aporta principalmente Dynamo 0.4?

Servicio desagregado entre GPUs, AIConfigurator para PD, autoscalado basado en SLO con Planner, observabilidad y mejoras de tolerancia a fallas. [NVIDIA Dynamo 0.4 release](https://developer.nvidia.com/blog/dynamo-0-4-delivers-4x-faster-performance-slo-based-autoscaling-and-real-time-observability).

-

¿Cómo mejora la eficiencia el servicio desagregado?

Separa prefill y decode en GPUs diferentes, permitiendo asignaciones de recursos más flexibles y paralelismo de modelo específico para cada fase.

-

¿Qué es AIConfigurator y cómo ayuda?

Es una herramienta que recomienda configuraciones óptimas de desagregación PD y estrategias de paralelismo, basada en el modelo y el presupuesto de GPU, generando configuraciones de backend Dynamo automáticamente. Soporte CLI y web; soporte inicial para TensorRT-LLM en Hopper.

-

¿Qué beneficios ofrece el autoscalado basado en SLO?

Permite prever el impacto de cambios en longitudes de secuencia y dimensionar recursos de forma proactiva para cumplir objetivos de rendimiento, con integración nativa a Kubernetes.

Referencias

More news

NVIDIA HGX B200 reduce la intensidad de las emisiones de carbono incorporado

El HGX B200 de NVIDIA reduce la intensidad de carbono incorporado en un 24% frente al HGX H100, al tiempo que ofrece mayor rendimiento de IA y eficiencia energética. Este artículo resume los datos PCF y las novedades de hardware.

Predecir Eventos Climáticos Extremos en Minutos sin Supercomputadora: Huge Ensembles (HENS)

NVIDIA y Berkeley Lab presentan Huge Ensembles (HENS), una herramienta de IA de código abierto que pronostica eventos climáticos raros y de alto impacto usando 27,000 años de datos, con opciones de código abierto o listas para usar.

Scaleway se une a los Proveedores de Inferencia de Hugging Face para Inferencia Serverless y de Baja Latencia

Scaleway es ahora un Proveedor de Inferencia soportado en Hugging Face Hub, lo que permite inferencia serverless directamente en las páginas de modelos con los SDK de JS y Python. Accede a modelos open-weight populares y disfruta de flujos de IA escalables y de baja latencia.

Cómo reducir cuellos de botella KV Cache con NVIDIA Dynamo

NVIDIA Dynamo offloads KV Cache desde la memoria de la GPU hacia almacenamiento económico, habilitando contextos más largos, mayor concurrencia y costos de inferencia más bajos para grandes modelos y cargas de IA generativa.

Microsoft transforma el sitio de Foxconn en el data center Fairwater AI, descrito como el más poderoso del mundo

Microsoft anuncia planes para un data center Fairwater AI de 1,2 millones de pies cuadrados en Wisconsin, con cientos de miles de GPU Nvidia GB200. El proyecto de 3.3 mil millones de dólares promete un entrenamiento de IA sin precedentes.

Manual de los Grandmasters de Kaggle: 7 Técnicas de Modelado para Datos Tabulares

Un análisis detallado de siete técnicas probadas por los Grandmasters de Kaggle para resolver rápidamente conjuntos de datos tabulares mediante aceleración por GPU, desde baselines variados hasta ensamblaje y pseudo-etiquetado.