Taller de Apple sobre Aprendizaje Automático Privacidad-Preservadora (PPML) 2025 — Resumen y recursos

Sources: https://machinelearning.apple.com/updates/ppml-2025

TL;DR

- Apple organizó un taller híbrido de dos días, Workshop on Privacy-Preserving Machine Learning (PPML), a principios de este año para debatir privacidad, seguridad e IA.

- El taller se centró en cuatro áreas: Aprendizaje y Estadísticas Privadas; Ataques y Seguridad; Fundamentos de la Privacidad Diferencial; y Modelos Fundamentales y Privacidad.

- Apple compartió grabaciones de charlas seleccionadas y un resumen de las publicaciones en su página de Investigación en Aprendizaje Automático.

Contexto y antecedentes

Apple sostiene que la privacidad es un derecho humano fundamental y subraya la importancia de crear técnicas preservadoras de privacidad en paralelo con los avances en capacidades de IA. La compañía señaló su investigación sostenida en el uso de privacidad diferencial con aprendizaje automático y organizó el Workshop on Privacy-Preserving Machine Learning (PPML) como un evento híbrido de dos días que reunió a investigadores de Apple y a la comunidad investigadora más amplia. La reunión se centró en la intersección de privacidad, seguridad y sistemas de inteligencia artificial en rápida evolución. Presentadores y participantes exploraron tanto los fundamentos teóricos como los desafíos prácticos de construir sistemas de IA que protejan la privacidad. Apple compartió grabaciones de charlas invitadas seleccionadas y un resumen de las publicaciones discutidas en el taller.

Qué hay de nuevo

El taller presentó una amplia gama de trabajos recientes que abarcan teoría, algoritmos, estudios empíricos y sistemas para aprendizaje automático preservador de la privacidad. Los temas clave incluyeron:

- Aprendizaje y estadísticas privadas, con mecanismos para estimación privada y agregación.

- Ataques y seguridad, con análisis de riesgos de inferencia y extracción relacionados con modelos personalizados y grandes modelos de lenguaje.

- Fundamentos de privacidad diferencial, explorando amplificación, composición, privacidad en flujo y diseño de mecanismos.

- Modelos fundamentales y privacidad, incluidas metodologías para generar datos sintéticos diferencialmente privados mediante APIs de modelos fundamentales para imágenes y texto. Apple puso a disposición grabaciones de charlas seleccionadas y una lista curada de las publicaciones discutidas en el taller.

Por qué importa (impacto para desarrolladores/empresas)

- Diseño de producto: a medida que las funciones de IA son más personales, los enfoques del PPML guían a diseñadores e ingenieros para construir componentes que respeten las expectativas de privacidad.

- De la investigación a la práctica: la mezcla de avances teóricos y presentaciones orientadas a sistemas ayuda a cerrar la brecha entre la investigación académica y los sistemas de ML desplegables.

- Evaluación de riesgos: las charlas sobre ataques y auditoría subrayan la importancia de modelar amenazas y auditar modelos y APIs, relevante para equipos que despliegan modelos fundamentales y servicios personalizados.

- Cumplimiento y confianza: los fundamentos y mecanismos de privacidad diferencial presentados ofrecen técnicas que las organizaciones pueden considerar para mantener compromisos de privacidad y generar confianza en los usuarios.

Detalles técnicos o Implementación

El taller cubrió temas técnicos diversos. La lista siguiente muestra ponencias invitadas y artículos presentados durante el PPML; los títulos y autores se reproducen a partir de los materiales del taller compartidos por Apple.

Áreas de enfoque abordadas en el taller

| Área de enfoque | Charlas o artículos representativos

| --- |

|---|

| Aprendizaje y estadísticas privadas |

| Ataques y seguridad |

| Fundamentos de privacidad diferencial |

| Modelos fundamentales y privacidad |

Charlas y contribuciones seleccionadas (lista parcial)

- Local Pan-Privacy — Guy Rothblum (Apple)

- Differential Private Continual Histograms — Monika Henzinger (IST&A)

- PREAMBLE: Private and Efficient Aggregation of Block Sparse… — Hannah Keller (Aarhus University)

- Tukey Depth Mechanisms for Practical Private Mean Estimation — Gavin Brown (University of Washington)

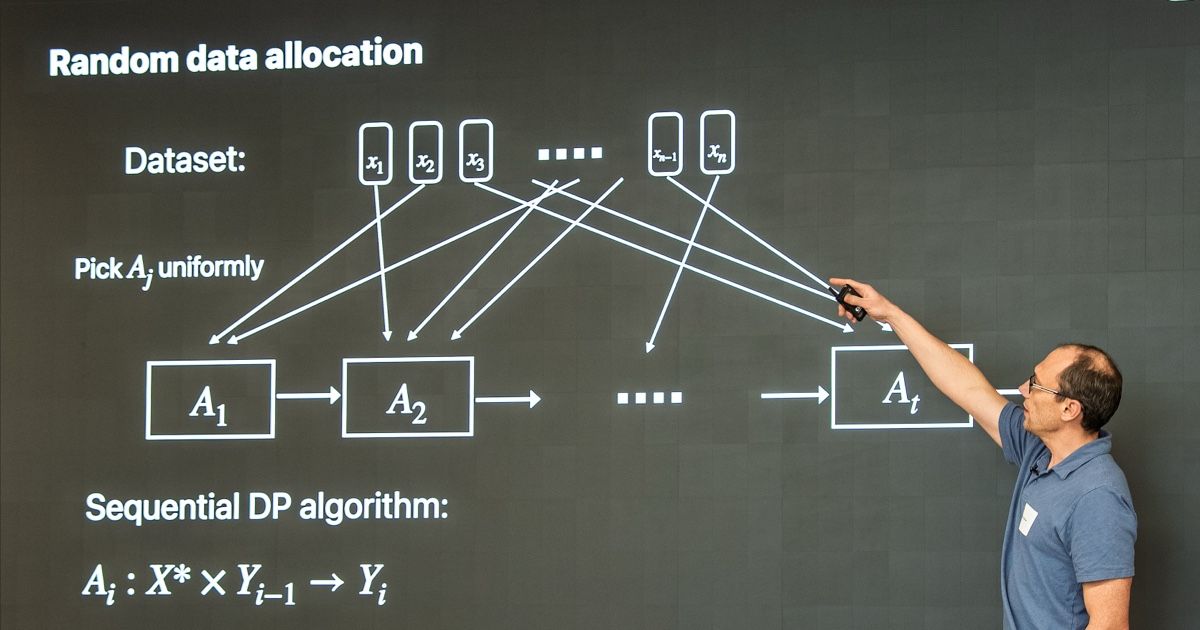

- Privacy Amplification by Random Allocation — Vitaly Feldman (Apple)

- Differentially Private Synthetic Data via Foundation Model APIs — Sivakanth Gopi (Microsoft Research)

- Scalable Private Search with Wally — Rehan Rishi and Haris Mughees (Apple)

- AirGapAgent: Protecting Privacy-Conscious Conversational Agents — Eugene Bagdasarian et al. (Google Research / DeepMind)

- A Generalized Binary Tree Mechanism for Differentially Private Approximation of All-Pair Distances — Michael Dinitz et al.

- Differentially Private Synthetic Data via Foundation Model APIs 1: Images — Zinan Lin et al. (Microsoft Research)

- Differentially Private Synthetic Data via Foundation Model APIs 2: Text — Chulin Xie et al. El taller también agradeció a muchos colaboradores, entre ellos Hilal Asi, Anthony Chivetta, Vitaly Feldman, Haris Mughees, Martin Pelikan, Rehan Rishi, Guy Rothblum y Kunal Talwar.

Conclusiones clave

- La investigación en ML preservador de la privacidad sigue siendo un área activa que une teoría y sistemas.

- Los fundamentos de la privacidad diferencial y las técnicas de amplificación siguen siendo claves para despliegues prácticos.

- Comprender ataques y realizar auditorías es esencial al desplegar modelos personalizados o basados en modelos fundamentales.

FAQ

-

¿Qué fue PPML 2025?

PPML 2025 fue un taller híbrido de dos días sobre Privacy-Preserving Machine Learning organizado por Apple para discutir el estado del arte en ML preservador de la privacidad.

-

¿Cuáles fueron las áreas principales?

Las cuatro áreas principales fueron Aprendizaje y Estadísticas Privadas; Ataques y Seguridad; Fundamentos de la Privacidad Diferencial; y Modelos Fundamentales y Privacidad.

-

¿Están disponibles las grabaciones?

Apple compartió grabaciones de charlas seleccionadas y un resumen de las publicaciones en su página de investigación; ver Referencias.

Referencias

- Página del taller y grabaciones: https://machinelearning.apple.com/updates/ppml-2025

More news

Anthropic endurece las reglas de uso de Claude ante un panorama de IA más peligroso

Anthropic prohíbe ayudar a desarrollar armas CBRN y explosivos de alto rendimiento, añade restricciones de ciberseguridad, ajusta su política política y aclara requisitos de alto riesgo.

Build a scalable containerized web application on AWS using the MERN stack with Amazon Q Developer – Part 1

In a traditional SDLC, a lot of time is spent in the different phases researching approaches that can deliver on requirements: iterating over design changes, writing, testing and reviewing code, and configuring infrastructure. In this post, you learned about the experience and saw productivity gains

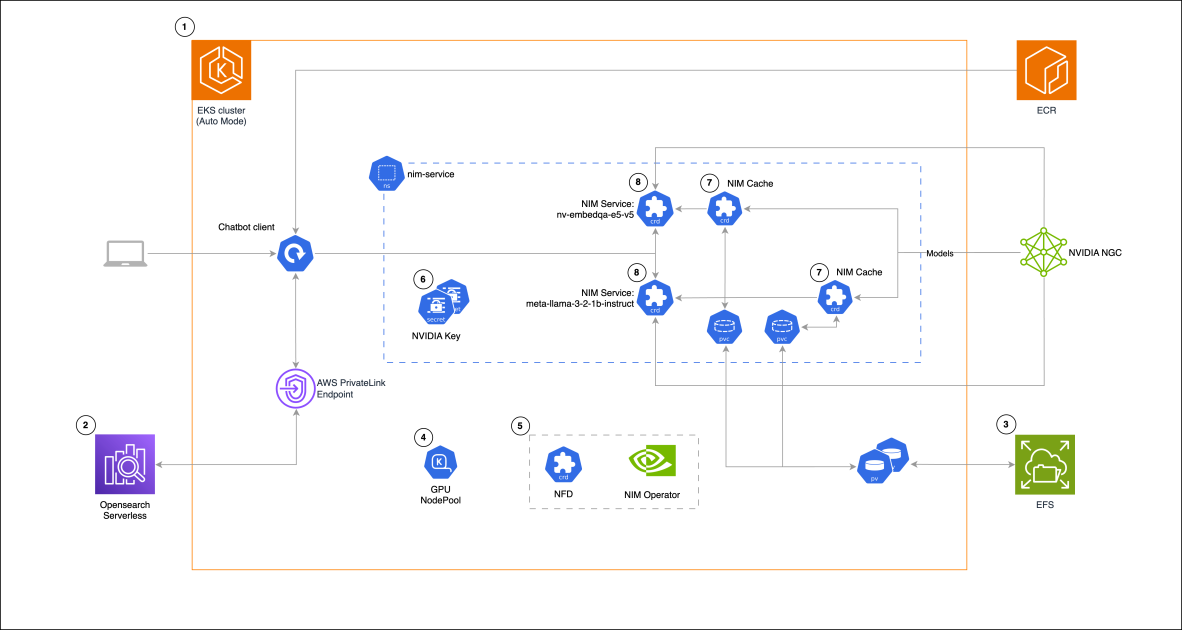

Building a RAG chat-based assistant on Amazon EKS Auto Mode and NVIDIA NIMs

In this post, we demonstrate the implementation of a practical RAG chat-based assistant using a comprehensive stack of modern technologies. The solution uses NVIDIA NIMs for both LLM inference and text embedding services, with the NIM Operator handling their deployment and management. The architectu

GPT-5 decepcionó las expectativas pero mejoró costo, velocidad y capacidad de programación

El lanzamiento de GPT-5 recibió reacciones mixtas: mejoras incrementales en benchmarks, reducción de costos y latencia, mejor desempeño en programación, pero críticas al tono de escritura y errores inesperados.

Introducing Amazon Bedrock AgentCore Gateway: Transforming enterprise AI agent tool development

In this post, we discuss Amazon Bedrock AgentCore Gateway, a fully managed service that revolutionizes how enterprises connect AI agents with tools and services by providing a centralized tool server with unified interface for agent-tool communication. The service offers key capabilities including S

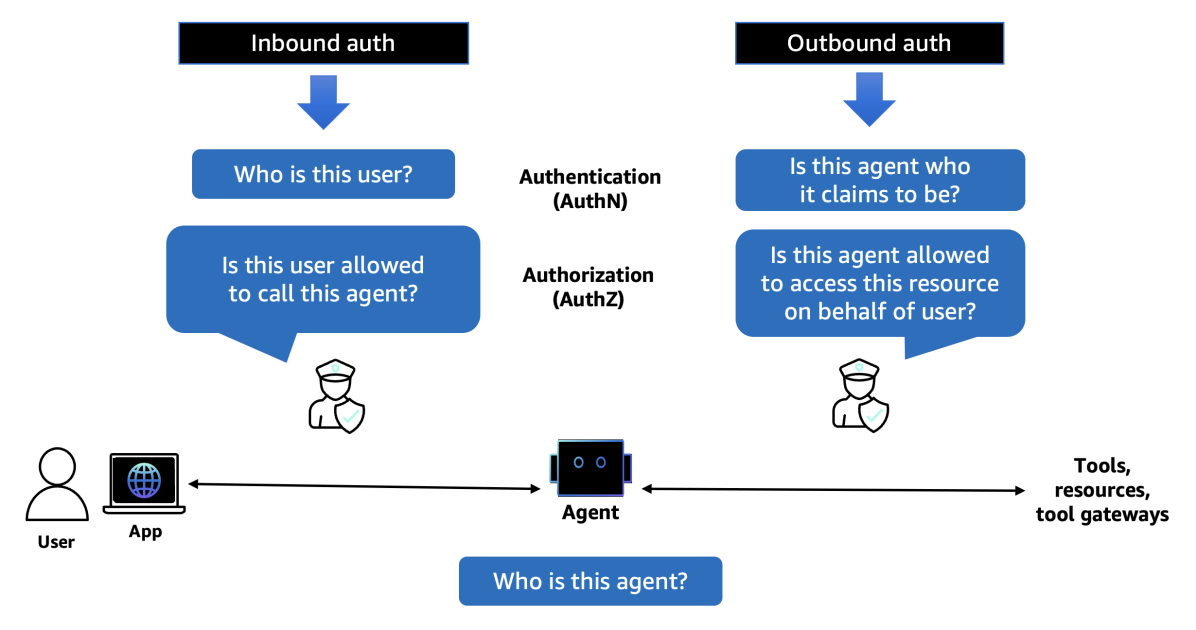

Introducing Amazon Bedrock AgentCore Identity: Securing agentic AI at scale

In this post, we explore Amazon Bedrock AgentCore Identity, a comprehensive identity and access management service purpose-built for AI agents that enables secure access to AWS resources and third-party tools. The service provides robust identity management features including agent identity director