Maximizar el rendimiento robótico con Cosmos Reason de NVIDIA tras el entrenamiento

Sources: https://developer.nvidia.com/blog/maximize-robotics-performance-by-post-training-nvidia-cosmos-reason, developer.nvidia.com

TL;DR

- Cosmos Reason es un modelo de razonamiento visión- lenguaje (VLM) abierto y personalizable para IA física y robótica.

- Convierte video en tokens mediante un codificador de visión y un traductor llamado proyector, y luego fusiona estos tokens con un prompt de texto para razonar.

- El fine-tuning en tareas de IA física mejora el rendimiento base en más del 10%; el aprendizaje por refuerzo añade alrededor de un 5%, alcanzando una puntuación media de 65,7 en benchmarks de robótica y vehículos autónomos.

- El modelo está optimizado para GPUs NVIDIA y puede implementarse de borde a nube; los checkpoints están en Hugging Face y los scripts de inferencia y post-entrenamiento en GitHub. Cita: NVIDIA resalta los detalles de Cosmos Reason y su despliegue en GTC 2025. Consulte la publicación original para el contexto completo: NVIDIA Cosmos Reason blog.

Contexto y antecedentes

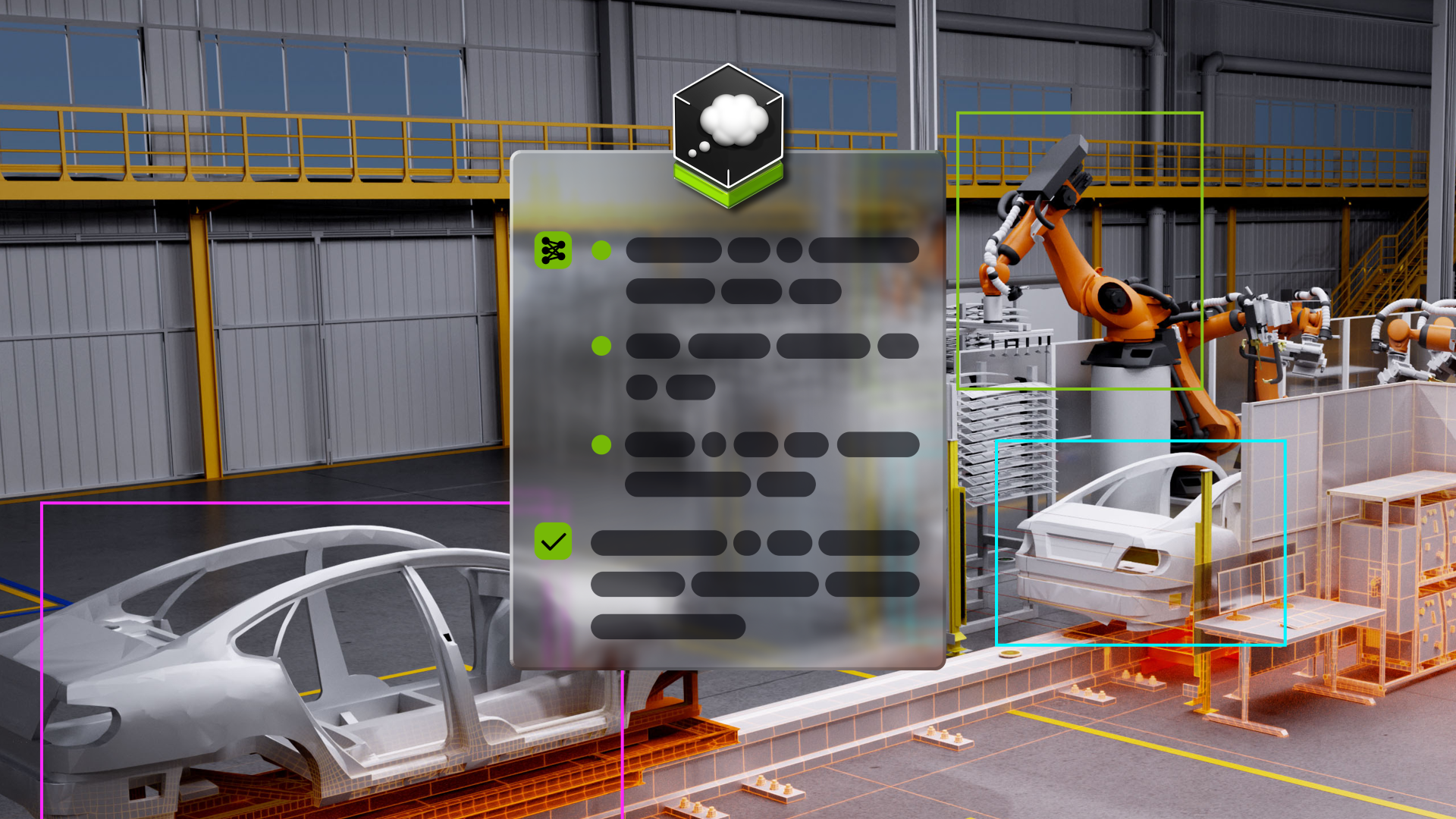

Presentado por primera vez en NVIDIA GTC 2025, NVIDIA Cosmos Reason es un VLM de razonamiento abierto y completamente personalizable para IA física y robótica. El sistema permite a robots y agentes de visión razonar utilizando conocimiento previo, comprensión de la física y sentido común para entender y actuar en el mundo real. El proceso toma un video y un prompt de texto, convierte el video en tokens con un codificador de visión y un traductor llamado proyector, y luego alimenta los tokens al modelo central. El modelo utiliza una mezcla de módulos LLM y técnicas para pensar paso a paso y entregar respuestas detalladas y lógicas. Cosmos Reason se entrena con fine-tuning supervisado y aprendizaje por refuerzo para conectar la percepción multimodal con la toma de decisiones en el mundo real, usando razonamiento en cadena para entender la dinámica del mundo sin anotaciones humanas.

Novedades

Cosmos Reason representa una solución de pos-entrenamiento abierta y personalizable para robótica e IA física. El enfoque combina fine-tuning supervisado con aprendizaje por refuerzo para mejorar el rendimiento en tareas, con el fine-tuning aumentando el modelo base en más de 10% y el RL aportando ~5% adicionales, alcanzando una media de 65,7 en benchmarks de robótica y vehículos autónomos. Los desarrolladores pueden descargar los checkpoints desde Hugging Face y obtener scripts de inferencia y recursos de pos-entrenamiento en GitHub. El sistema admite vídeos en distintas resoluciones y frecuencias de cuadro junto con un prompt de texto que guía el razonamiento y las respuestas. Un modelo de upsampler de prompts también está disponible para mejorar las prompts. Cosmos Reason está optimizado para rendir al máximo en GPUs NVIDIA y se puede ejecutar en Docker o en el entorno del desarrollador. Para pipelines de visión, el VLM puede operar desde el edge hasta la nube, sobre GPUs como NVIDIA DGX Spark, NVIDIA RTX Pro 6000, NVIDIA AI H100 Tensor Core GPUs o NVIDIA Blackwell GB200 NVL72 en NVIDIA DGX Cloud. Para tutorials y casos prácticos, los desarrolladores pueden consultar la documentación de Cosmos y seguir las actualizaciones en los canales de NVIDIA.

Por qué importa (impacto para desarrolladores/empresas)

- Para desarrolladores, Cosmos Reason ofrece un marco abierto y personalizable para avanzar la IA física al combinar percepción basada en video con razonamiento alineado con física y sentido común.

- Para empresas, la disponibilidad de checkpoints en Hugging Face y scripts de inferencia en GitHub reduce la barrera para evaluar y desplegar VLMs sofisticados para robótica y sistemas autónomos. Las opciones de edge a nube permiten modelos operativos flexibles en instalaciones y flotas. La optimización para GPUs NVIDIA ayuda a maximizar la inversión en hardware.

Detalles técnicos o Implementación

- Entrada: un video se convierte en tokens mediante un codificador de visión, complementado por un proyector para fusionar los tokens con el prompt de texto.

- Núcleo: utiliza un mezcla de módulos LLM y técnicas para razonar paso a paso, soportando razonamiento en cadena para entender la dinámica mundial.

- Entrenamiento: fine-tuning supervisado para mejorar capacidades y aprendizaje por refuerzo para vincular percepción con decisiones reales.

- Ejemplos de tareas: el fine-tuning en escenarios de respuestas visuales robóticas puede reforzarse con datasets específicos como robovqa.

- Despliegue: Docker o despliegue nativo; optimizado para GPUs NVIDIA.

- Recursos: checkpoints en Hugging Face; scripts de inferencia y recursos de pos-entrenamiento en GitHub; upsampler de prompts disponible.

Puntos clave

- Cosmos Reason combina percepción basada en video con razonamiento paso a paso para operar en entornos reales.

- El pos-entrenamiento (SFT + RL) aporta ganancias medibles en benchmarks robóticos.

- Diseñado para edge y nube, con acceso fácil a código y modelos, optimizado para hardware NVIDIA.

- Ajustes y conjuntos de datos pueden adaptar el modelo a tareas robóticas como VQA.

Preguntas Frecuentes

-

- **P:** ¿Qué es NVIDIA Cosmos Reason y qué hace?

Es un VLM de razonamiento abierto y personalizable para IA física y robótica que razona con conocimiento previo, física y sentido común para actuar en el mundo real, procesando video y prompts de texto para producir respuestas con razonamiento paso a paso mediante módulos LLM. - **P:** ¿Cómo procesa Cosmos Reason el video y las invites de texto? **A:** El video se codifica en tokens con un codificador de visión y se traduce con un proyector. Los tokens de video se combinan con el prompt de texto y se envían al núcleo del modelo, que razona con múltiples componentes LLM. - **P:** ¿Qué mejoras de rendimiento se reportan? **A:** El pos-entrenamiento en tareas de IA física aumenta el rendimiento base en más de 10%, y el aprendizaje por refuerzo añade alrededor de 5%, alcanzando una media de 65,7 en benchmarks robóticos y de vehículos autónomos. - **P:** ¿Cómo pueden los desarrolladores acceder y desplegar Cosmos Reason? **A:** Los checkpoints están disponibles en Hugging Face y los scripts de inferencia y recursos de pos-entrenamiento en GitHub. Puede ejecutarse mediante Docker o en el entorno del desarrollador y está optimizado para GPUs NVIDIA.

Referencias

More news

NVIDIA HGX B200 reduce la intensidad de las emisiones de carbono incorporado

El HGX B200 de NVIDIA reduce la intensidad de carbono incorporado en un 24% frente al HGX H100, al tiempo que ofrece mayor rendimiento de IA y eficiencia energética. Este artículo resume los datos PCF y las novedades de hardware.

Predecir Eventos Climáticos Extremos en Minutos sin Supercomputadora: Huge Ensembles (HENS)

NVIDIA y Berkeley Lab presentan Huge Ensembles (HENS), una herramienta de IA de código abierto que pronostica eventos climáticos raros y de alto impacto usando 27,000 años de datos, con opciones de código abierto o listas para usar.

Cómo reducir cuellos de botella KV Cache con NVIDIA Dynamo

NVIDIA Dynamo offloads KV Cache desde la memoria de la GPU hacia almacenamiento económico, habilitando contextos más largos, mayor concurrencia y costos de inferencia más bajos para grandes modelos y cargas de IA generativa.

Microsoft transforma el sitio de Foxconn en el data center Fairwater AI, descrito como el más poderoso del mundo

Microsoft anuncia planes para un data center Fairwater AI de 1,2 millones de pies cuadrados en Wisconsin, con cientos de miles de GPU Nvidia GB200. El proyecto de 3.3 mil millones de dólares promete un entrenamiento de IA sin precedentes.

Manual de los Grandmasters de Kaggle: 7 Técnicas de Modelado para Datos Tabulares

Un análisis detallado de siete técnicas probadas por los Grandmasters de Kaggle para resolver rápidamente conjuntos de datos tabulares mediante aceleración por GPU, desde baselines variados hasta ensamblaje y pseudo-etiquetado.

NVIDIA RAPIDS 25.08 Agrega Nuevo profiler para cuML, Mejoras en el motor GPU de Polars y Soporte Ampliado de Algoritmos

RAPIDS 25.08 introduce perfiles de nivel de función y de línea para cuml.accel, el ejecutor de streaming por defecto del motor Polars GPU, soporte ampliado de tipos y cadenas, Spectral Embedding en cuML y aceleraciones de cero código para varios estimadores.