TimeScope: Evaluación de la comprensión de videos largos en modelos Vision-Language

Sources: https://huggingface.co/blog/timescope-video-lmm-benchmark, Hugging Face Blog

TL;DR

- TimeScope es una referencia de código abierto que prueba modelos vision-ling en videos largos (1 minuto a 8 horas) insertando needles cortas.

- Va más allá de la recuperación para evaluar síntesis, localización y análisis de movimiento fino mediante tres tipos de needles.

- En los modelos evaluados, los videos más largos revelan caídas de rendimiento; aumentar el tamaño del modelo no garantiza una mayor duración temporal.

- Gemini 2.5-Pro destaca especialmente en videos de más de una hora, mientras otros modelos se estabilizan en una longitud de contexto similar.

- La referencia es abierta y está disponible en Hugging Face.

Contexto y antecedentes

En los últimos años, la IA multimodal ha mostrado promesas para entender videos extremadamente largos, reflejando avances en modelos de contexto largo en lenguaje. Sin embargo, evaluar tales afirmaciones no es trivial. Los benchmarks de video anteriores suelen usar needles estáticas insertadas en los videos, lo que mide principalmente búsqueda visual y no comprensión temporal real. Este enfoque puede ocultar debilidades en el razonamiento a lo largo de secuencias temporales extensas. Los estudios sobre benchmarks de texto como HELM y RULER han mostrado la fragilidad de las capacidades de contexto largo cuando las tareas exigen razonamiento o agregación. En el dominio de video, este desafío se ve reforzado por la formación de modelos en ventanas temporales limitadas y reportes de capacidades amplias. Frente a esto, TimeScope propone un enfoque dirigido para cuantificar cuán bien los sistemas multimodales comprenden narrativas de video a lo largo del tiempo.

Qué hay de nuevo

TimeScope es un benchmark de código abierto alojado en Hugging Face. La evaluación inserta varias needles cortas (~5–10 segundos) en videos base que van de 1 minuto a 8 horas. Las needles contienen la información clave necesaria para resolver la tarea, obligando al modelo a procesar la entrada completa y no depender de muestreo disperso. El benchmark utiliza tres tipos de needles, cada uno diseñado para pulsar una dimensión distinta de la comprensión de videos largos:

- Recuperación localizada y comprensión de eventos: preguntas que se pueden responder identificando contenido en la needle, evaluando la capacidad de localizar e interpretar un evento dentro del video.

- Síntesis de información y extracción de texto disperso: needles basadas en texto insertadas en tiempos diferentes requieren que el modelo identifique todas las palabras y las ordene en secuencia cronológica.

- Percepción de movimiento y temporalidad: para preguntas sobre movimiento dentro de una needle, el modelo debe seguir la dinámica entre frames, no basta con un frame estático. TimeScope también examina cómo cambia el desempeño al variar la duración del video base. Los resultados iniciales muestran una pauta: el rendimiento tiende a deteriorarse a medida que la base se alarga, indicando que la fidelidad temporal de alto rango sigue siendo un desafío incluso para modelos potentes. Se evaluó TimeScope en una variedad de modelos de visión-lenguaje, desde opciones de código abierto hasta grandes modelos como Gemini 2.5-Pro. Los resultados muestran tanto el potencial como las limitaciones actuales de la comprensión de videos largos y subrayan la necesidad de enfoques de entrenamiento más focalizados y evaluaciones temporales robustas.

Por qué es importante (impacto para desarrolladores/empresas)

La capacidad de razonar sobre horas de video abre posibilidades transformadoras: agentes autónomos podrían resumir grabaciones largas, detectar anomalías sutiles en operaciones prolongadas y responder preguntas sobre narrativas extensas. En robótica, el análisis prolongado podría sostener una toma de decisiones en tiempo real durante operaciones largas. Para aplicaciones de consumo, asistentes personales podrían ofrecer retroalimentación continua y contextual a lo largo del día. Sin embargo, TimeScope también subraya una realidad: las afirmaciones de comprender videos durante horas aún no están plenamente validadas. La referencia ayuda a desarrolladores y empresas a basar decisiones en evaluaciones temporales rigurosas, priorizar entrenamientos orientados al razonamiento temporal y planificar implementaciones para escenarios con videos largos.

Detalles técnicos o Implementación

TimeScope utiliza el enfoque de inserción de needles. Un video base actúa como “ahumado” y needles cortas se insertan en posiciones aleatorias. Las needles llevan la información clave necesaria para responder las preguntas, obligando al modelo a integrar información a lo largo de toda la línea de tiempo y no a depender de frames aislados. Los tres tipos de needles prueban dimensiones distintas de la comprensión de videos largos:

- Recuperación localizada y comprensión: preguntas que requieren identificar contenido en la needle para obtener la respuesta.

- Síntesis de información dispersa: needles de texto que exigen extraer y ordenar palabras en secuencia temporal.

- Percepción del movimiento: preguntas que requieren seguimiento dinámico del movimiento entre frames. TimeScope también evalúa cómo varía el rendimiento con la duración del video base. Los resultados iniciales muestran que aumentar la longitud del contenido puede reducir el rendimiento, insistiendo en la necesidad de fidelidad temporal sostenida. Gemini 2.5-Pro se destaca al mantener mayor precisión en videos más largos. Los resultados señalan trade-offs entre tareas: por ejemplo, Qwen 2.5-VL es fuerte en síntesis de información (OCR), pero menor en Percepción Temporal Fina, donde se exige conteo preciso de movimientos. TimeScope fomenta enfoques de entrenamiento que logren una comprensión temporal equilibrada y robusta. La versión open-source de TimeScope invita a la comunidad a reproducir, ampliar y mejorar la evaluación de videos largos. Todos los componentes están disponibles para estudio y desarrollo, con resultados y visualizaciones accesibles a través del Hugging Face Space que acompaña la referencia.

Puntos clave a destacar

- La comprensión de videos largos sigue siendo un área donde las promesas a menudo superan los resultados verificables.

- Aumentar el tamaño del modelo no garantiza una mayor duración temporal.

- Se observan caídas de rendimiento en duraciones específicas, señalando la necesidad de entrenamientos sensibles a la duración.

- Los modelos exhiben fortalezas y debilidades distintas por tarea: síntesis de información (OCR) frente a percepción del movimiento.

- La apertura de TimeScope favorece evaluaciones rigurosas y progreso colectivo hacia sistemas multimodales mejor alineados con videos largos.

FAQ

Referencias

More news

Scaleway se une a los Proveedores de Inferencia de Hugging Face para Inferencia Serverless y de Baja Latencia

Scaleway es ahora un Proveedor de Inferencia soportado en Hugging Face Hub, lo que permite inferencia serverless directamente en las páginas de modelos con los SDK de JS y Python. Accede a modelos open-weight populares y disfruta de flujos de IA escalables y de baja latencia.

Reduciendo la latencia en frío para la inferencia de LLM con NVIDIA Run:ai Model Streamer

Análisis detallado de cómo NVIDIA Run:ai Model Streamer disminuye los tiempos de arranque en frío al transmitir pesos a la memoria GPU, con benchmarks en GP3, IO2 y S3.

Cómo msg mejoró la transformación de la fuerza laboral de RR. HH. con Amazon Bedrock y msg.ProfileMap

Este artículo explica cómo msg automatizó la armonización de datos para msg.ProfileMap usando Amazon Bedrock para impulsar flujos de enriquecimiento impulsados por LLM, aumentando la precisión de la coincidencia de conceptos de RR. HH., reduciendo la carga de trabajo manual y alineándose con la UE A

Cómo la quantización consciente (QAT) recupera precisión en inferencia de baja precisión

Analiza QAT y QAD como métodos para recuperar precisión en modelos de baja precisión, utilizando el TensorRT Model Optimizer y formatos FP8/NVFP4/MXFP4.

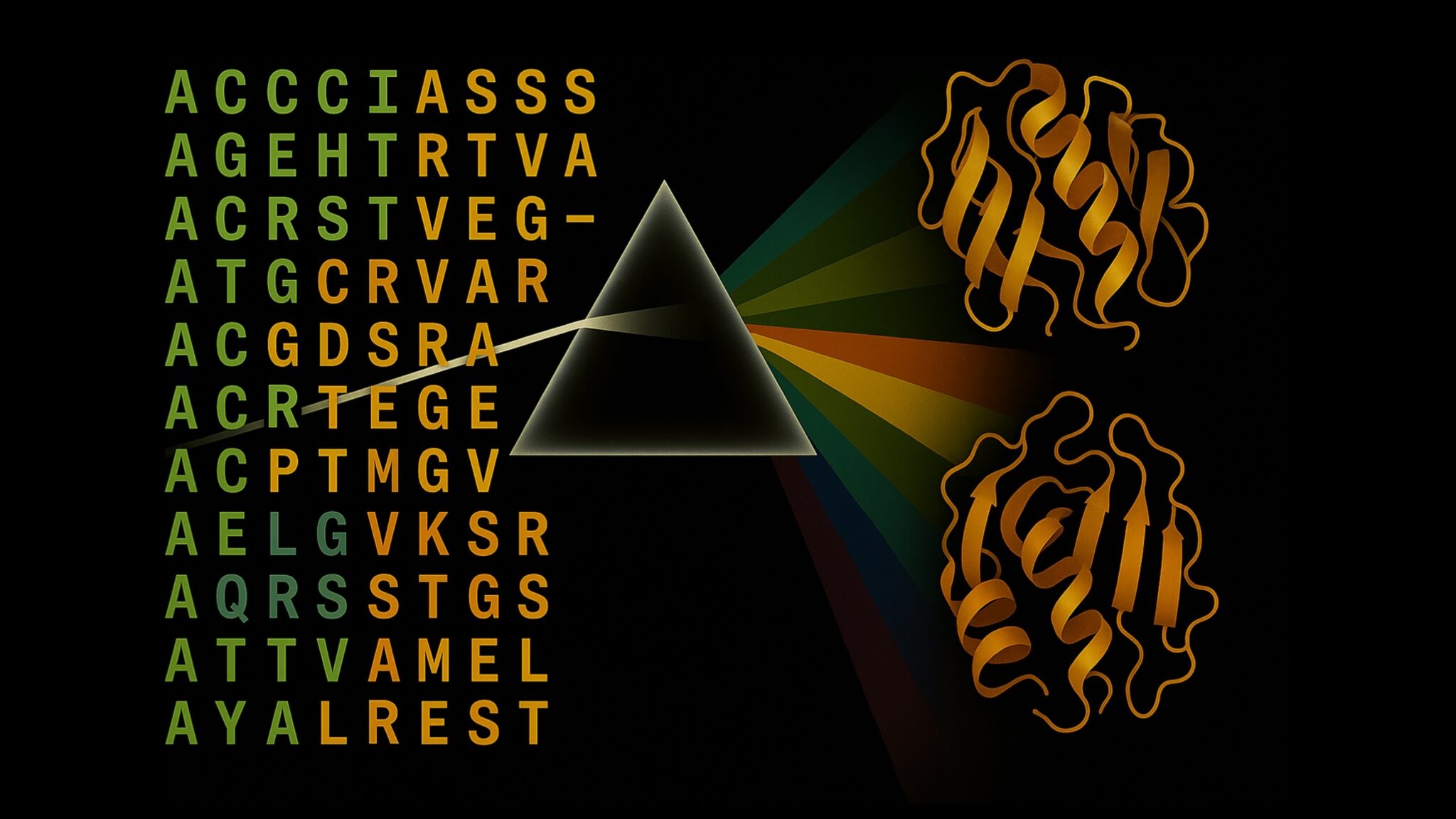

Acelerar la Inferencia de Estructura de Proteínas en Más de 100x con NVIDIA RTX PRO 6000 Blackwell Server Edition

El RTX PRO 6000 Blackwell Server Edition de NVIDIA acelera de forma notable la inferencia de estructuras de proteínas, permitiendo flujos de trabajo end-to-end en GPU con OpenFold y TensorRT, hasta 138x más rápido que AlphaFold2.

Por qué los modelos de lenguaje 'alucinan' y cómo OpenAI está cambiando las evaluaciones para la fiabilidad

OpenAI explica que las alucinaciones en modelos de lenguaje provienen de incentivos de evaluación que premian la conjetura sobre la incertidumbre. El artículo detalla cómo puntajes y benchmarks sensibles a la incertidumbre pueden reducir errores confiados.