TimeScope: Evaluar cuánto pueden entender videos largos los modelos multimodales

Sources: https://huggingface.co/blog/timescope-video-lmm-benchmark, Hugging Face Blog

TL;DR

- TimeScope es un benchmark de código abierto alojado en Hugging Face que mide la capacidad de los modelos visión–lenguaje para entender videos largos insertando needles cortas (~5–10 segundos) en videos base que van de 1 minuto a 8 horas. TimeScope blog

- El benchmark evalúa tres tipos de tareas y tres tipos de needles para ir más allá de la recuperación y abarcar síntesis, localización y análisis de movimiento fino. TimeScope blog

- Gemini 2.5-Pro destaca al mantener alta precisión en videos de más de una hora; Qwen 2.5-VL (3B y 7B) e InternVL 2.5 (2B, 4B, 8B) presentan curvas de video largo casi idénticas a las de sus contrapartes más pequeñas. TimeScope blog

- Los resultados muestran que entender videos de una hora sigue siendo desafiante y que abrir el código puede guiar mejoras específicas en el entrenamiento y la evaluación de modelos multimodales. TimeScope blog

Contexto y antecedentes

Las capacidades de contexto extendido en modelos vision–lenguaje han despertado interés, paralelamente a los avances en modelos de lenguaje con contexto largo. Aunque algunos sistemas afirman manejar ventanas de contexto de miles de fotogramas, persiste la duda sobre si realmente entienden la secuencia temporal. Benchmarks como Video Needle in a Haystack (VideoNIAH) tienden a medir recuperación visual mediante needles estáticas, en lugar de razonamiento temporal real. Ejercicios como HELM y RULER ya han mostrado la fragilidad de afirmaciones de largo contexto cuando las tareas exigen razonamiento o agregación temporal. TimeScope blog TimeScope llega para probar de forma empírica la comprensión temporal a lo largo de videos largos, complementando evaluaciones centradas en texto e imagen con un enfoque en razonamiento temporal extendido. TimeScope blog TimeScope se ofrece como código abierto en Hugging Face y proporciona una herramienta concreta para medir cuánto puede razonar un modelo sobre narrativas de video largas, en lugar de limitarse a recuperar fragmentos o pistas a nivel de cuadro. El objetivo es pasar de promesas a evaluaciones robustas de razonamiento temporal, síntesis y análisis de movimiento. TimeScope blog

Novedades

TimeScope introduce un nuevo paradigma de prueba para videos largos. Un video-base largo (1 minuto a 8 horas) sirve como “heno”, y se insertan needles cortas (aproximadamente 5–10 segundos) en posiciones aleatorias. El objetivo no es solo detectar la needle, sino entender profundamente el contenido dentro del contexto general para responder preguntas o realizar análisis. TimeScope blog Tres tipos de needles y tres tipos de tareas componen la evaluación:

- Los tipos de tareas evalúan recuperación, síntesis de información y localización, con énfasis en integrar información a lo largo del tiempo. Por ejemplo, una pregunta podría pedir el modo de transporte mostrado en clips dispersos. TimeScope blog

- Las needles incluyen needles basadas en texto (2–4 clips cortos mostrando palabras en pantalla) que requieren identificar y ordenar palabras dispersas cronológicamente, simulando la extracción de sellos de tiempo o hechos clave. TimeScope blog

- Una needles centrada en movimiento prueba dinámicas en clips cortos; preguntas como ¿Cuántas veces el hombre balanceó su hacha? exigen percibir movimiento a través de fotogramas. TimeScope blog Con longitudes de video variables y posiciones de needles al azar, TimeScope mide cuánta video puede manejar realmente un modelo y muestra que el rendimiento cae al alargar el video. En pruebas iniciales, TimeScope se aplicó a una gama de modelos vision–lenguaje, desde favoritos open-source hasta grandes actores como Gemini 2.5-Pro. Los resultados destacan dónde los modelos luchan con razonamiento temporal, síntesis de información y percepción de movimiento, allanando el camino para mejoras en entrenamiento y evaluación. TimeScope blog

Importancia para desarrolladores/empresas

TimeScope aborda una pregunta central para implementaciones reales: ¿los sistemas pueden entender narrativas de video largas, o solo recuperan fragmentos relevantes? Aplicaciones como robótica, análisis de operaciones prolongadas y resumen de videos de formato largo exigen razonamiento temporal a lo largo de horas. TimeScope, al ser de código abierto, permite a investigadores y empresas evaluar modelos de manera consistente, comparar enfoques y guiar estrategias de entrenamiento para mejorar el razonamiento temporal y la percepción de movimiento. TimeScope blog Los hallazgos también muestran que aumentar el tamaño del modelo no garantiza ventanas temporales más largas; TimeScope señala límites actuales y la necesidad de enfoques de entrenamiento y arquitectura optimizados para comprender videos largos. TimeScope blog

Detalles técnicos o implementación

La base de TimeScope es simple y poderosa: insertar needles cortas en videos largos y exigir comprensión holística para resolver las tareas. Las needles son breves (5–10 segundos) para forzar a los modelos a conectar información a lo largo del tiempo en lugar de depender de muestreo denso. El video base va de 1 minuto a 8 horas, creando escenarios de contexto largo para la evaluación. TimeScope blog Puntos técnicos clave:

- Inserción de needles: un video base largo funciona como el haystack, y una o más needles cortas se insertan en posiciones aleatorias. Las needles contienen la información clave necesaria para resolver la tarea, obligando al modelo a procesar toda la entrada sin atajos. TimeScope blog

- Tres tipos de needles, cada una dirigida a un aspecto diferente de la comprensión de videos largos: (1) needles basadas en texto para identificar y ordenar palabras dispersas, (2) needles centradas en movimiento para probar la dinámica entre frames, y (3) needles de localización para señalar contenido a lo largo de la línea de tiempo. TimeScope blog

- Las tareas evalúan recuperación, síntesis de información, localización y análisis de movimiento a través de videos de longitud creciente. Las preguntas requieren detectar, sintetizar o analizar contenidos de las needles insertadas a profundidades variables. TimeScope blog En pruebas iniciales, Gemini 2.5-Pro destaca por mantener precisión robusta en videos mayores a una hora, mientras que Qwen 2.5-VL (3B y 7B) e InternVL 2.5 (2B, 4B, 8B) muestran curvas de video largo casi idénticas a las de variantes más pequeñas, equilibrando su horizonte temporal. Esto subraya que escalar parámetros por sí solo no garantiza un mayor alcance temporal. TimeScope blog TimeScope es de código abierto y todos sus componentes están disponibles para la comunidad. El proyecto también incluye un Hugging Face Space con resultados detallados y visualizaciones para ayudar a diagnosticar debilidades y orientar mejoras en entrenamiento y evaluación. TimeScope blog

Tabla rápida de comparaciones

| Modelo | Comportamiento en videos largos | Observaciones |---|---|---| | Gemini 2.5-Pro | Mantiene alta precisión en videos > 1 hora | Distinción entre modelos evaluados |Qwen 2.5-VL 3B | Curva de video largo similar a variantes menores | Sobresale en OCR para síntesis de información; desempeño menor en percepción de movimiento fino |Qwen 2.5-VL 7B | Curva de video largo similar a 3B | Tendencia similar; razonamiento temporal robusto requerido |InternVL 2.5 (2B/4B/8B) | Curvas largas similares entre tamaños | Plateau alrededor del mismo horizonte |

Conclusiones clave

- Entender videos de horas sigue siendo un objetivo; las afirmaciones de procesar miles de fotogramas aún no se reflejan en un rendimiento estable en tareas de video largo. TimeScope blog

- El rendimiento de los modelos tiende a degradarse con la longitud del video, subrayando la necesidad de un razonamiento temporal verdadero más allá de la recuperación estática. TimeScope blog

- Gemini 2.5-Pro se destaca en videos más largos, pero la mayoría de los modelos muestran un comportamiento de plateau, lo que sugiere límites de las arquitecturas actuales o de los datos de entrenamiento. TimeScope blog

- Aumentar simplemente el número de parámetros no garantiza un horizonte temporal mayor; TimeScope revela compromisos entre tareas como síntesis de información y percepción de movimiento. TimeScope blog

- Al ser de código abierto, TimeScope invita a la comunidad a mejorar datos, regímenes de entrenamiento y métodos de evaluación para avanzar hacia una comprensión de video verdaderamente extendida. TimeScope blog

Preguntas frecuentes

Referencias

More news

Scaleway se une a los Proveedores de Inferencia de Hugging Face para Inferencia Serverless y de Baja Latencia

Scaleway es ahora un Proveedor de Inferencia soportado en Hugging Face Hub, lo que permite inferencia serverless directamente en las páginas de modelos con los SDK de JS y Python. Accede a modelos open-weight populares y disfruta de flujos de IA escalables y de baja latencia.

Reduciendo la latencia en frío para la inferencia de LLM con NVIDIA Run:ai Model Streamer

Análisis detallado de cómo NVIDIA Run:ai Model Streamer disminuye los tiempos de arranque en frío al transmitir pesos a la memoria GPU, con benchmarks en GP3, IO2 y S3.

Cómo msg mejoró la transformación de la fuerza laboral de RR. HH. con Amazon Bedrock y msg.ProfileMap

Este artículo explica cómo msg automatizó la armonización de datos para msg.ProfileMap usando Amazon Bedrock para impulsar flujos de enriquecimiento impulsados por LLM, aumentando la precisión de la coincidencia de conceptos de RR. HH., reduciendo la carga de trabajo manual y alineándose con la UE A

Cómo la quantización consciente (QAT) recupera precisión en inferencia de baja precisión

Analiza QAT y QAD como métodos para recuperar precisión en modelos de baja precisión, utilizando el TensorRT Model Optimizer y formatos FP8/NVFP4/MXFP4.

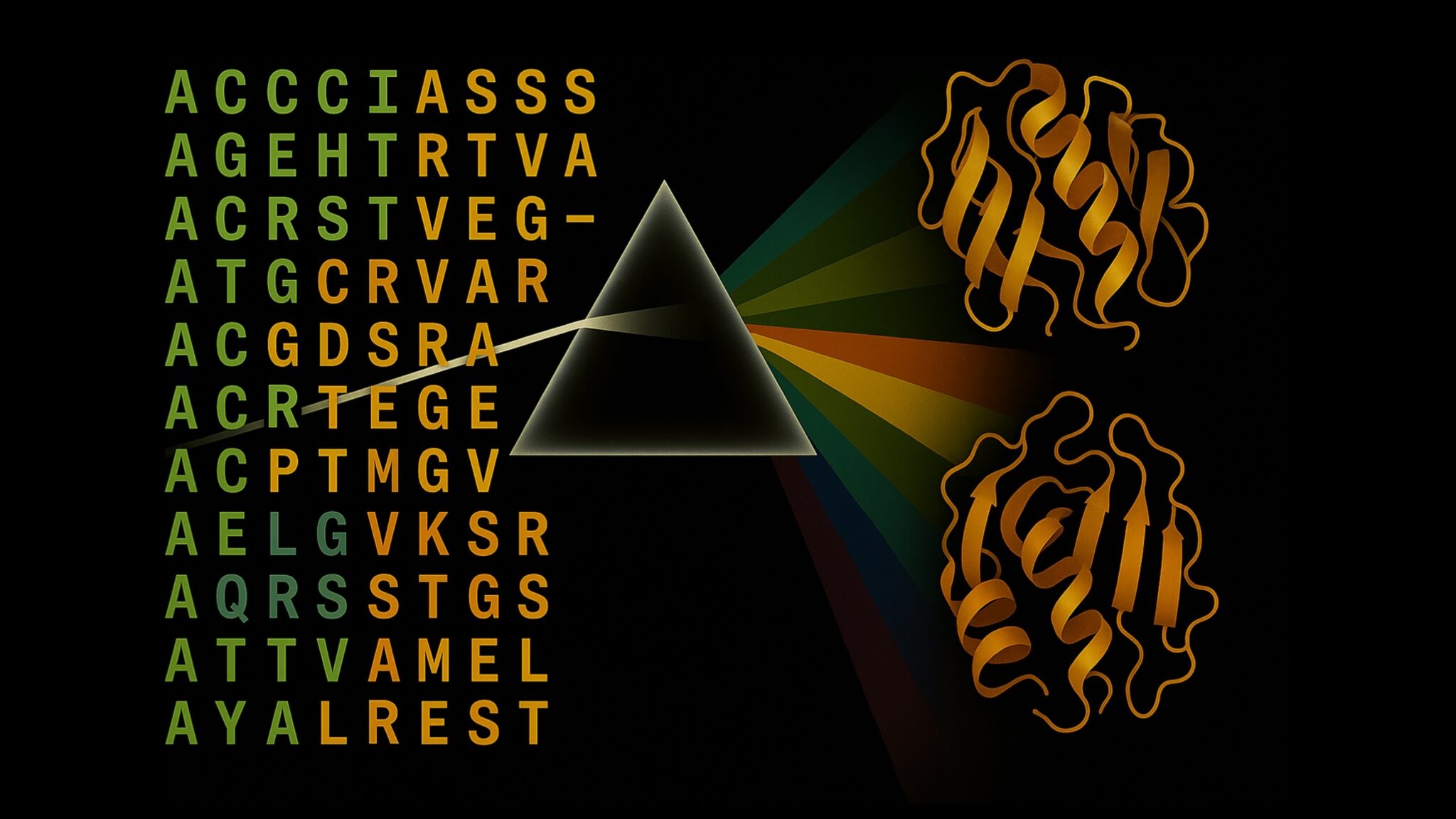

Acelerar la Inferencia de Estructura de Proteínas en Más de 100x con NVIDIA RTX PRO 6000 Blackwell Server Edition

El RTX PRO 6000 Blackwell Server Edition de NVIDIA acelera de forma notable la inferencia de estructuras de proteínas, permitiendo flujos de trabajo end-to-end en GPU con OpenFold y TensorRT, hasta 138x más rápido que AlphaFold2.

Por qué los modelos de lenguaje 'alucinan' y cómo OpenAI está cambiando las evaluaciones para la fiabilidad

OpenAI explica que las alucinaciones en modelos de lenguaje provienen de incentivos de evaluación que premian la conjetura sobre la incertidumbre. El artículo detalla cómo puntajes y benchmarks sensibles a la incertidumbre pueden reducir errores confiados.