Consilium: Cuando Múltiples LLMs Colaboran para Alcanzar Consenso

Sources: https://huggingface.co/blog/consilium-multi-llm, Hugging Face Blog

TL;DR

- Consilium es una plataforma multi-LLM que permite a los modelos de IA discutir preguntas complejas y alcanzar consenso mediante debates estructurados.

- Funciona como una interfaz Gradio y como un servidor MCP (Model Context Protocol), integrándose con aplicaciones para facilitar la colaboración entre agentes.

- El proyecto introdujo roles, rondas y un analista líder para sintetizar resultados, además de un agente de investigación para modelos con llamadas de función y cinco fuentes de investigación.

- Un benchmark MAI-DxO de Microsoft se cita para demostrar cómo la colaboración entre múltiples IA puede superar el análisis individual, validando el enfoque de Consilium.

- Los avances en curso incluyen integración con Open Floor Protocol, ampliación de la selección de modelos y roles de agentes configurables.

Contexto y antecedentes

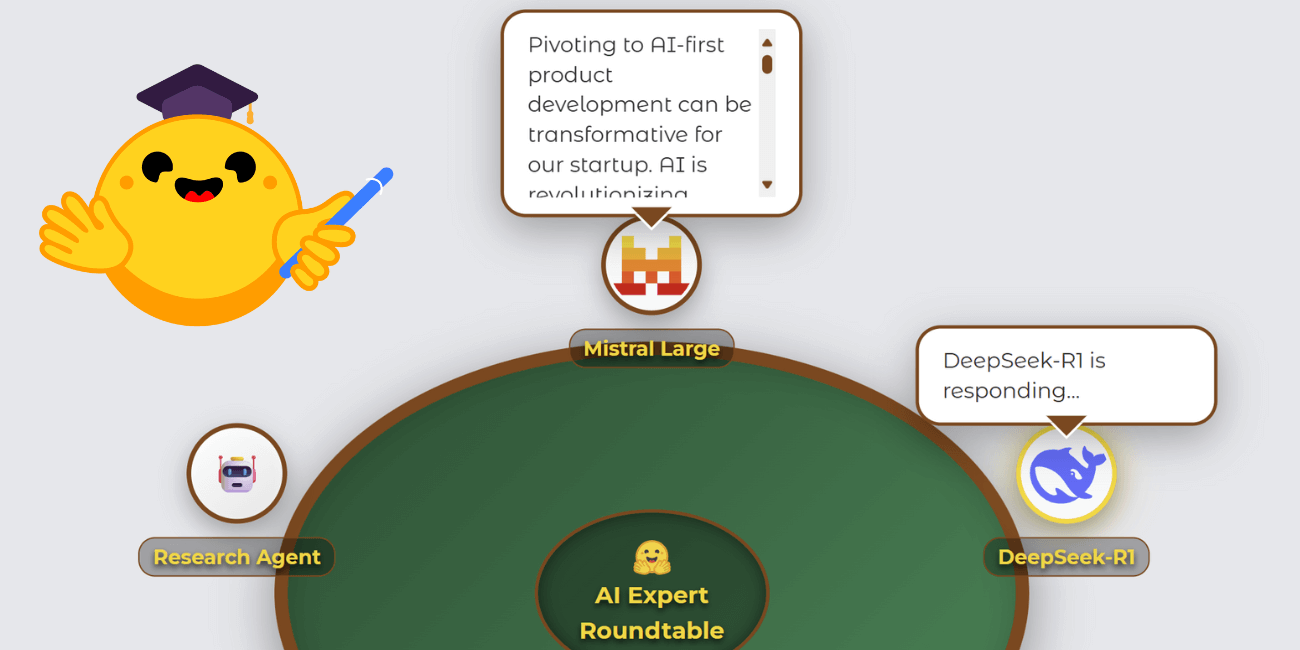

Como se describe en el blog de Hugging Face, Consilium es una plataforma de IA multi-LLM que permite a varios modelos discutir preguntas y alcanzar consenso a través de debates estructurados. El proyecto nació como una entrega de hackathon durante Gradio Agents & MCP Hackathon y evolucionó desde un servidor MCP simple a un entorno de debate colaborativo más rico. El autor destacó que la idea central es el consenso mediante la discusión, un concepto que recibió impulso tras el trabajo de MAI-DxO de Microsoft, que presentó un panel de IA con roles distintos para diagnosticar problemas. Ese trabajo mostró que la colaboración entre múltiples perspectivas de IA puede superar el análisis de un solo modelo, lo que ilustra el valor potencial de Consilium. El diseño también enfatiza una experiencia de usuario atractiva. En lugar de utilizar una interfaz de chat estándar, el desarrollador creó una visualización de mesa redonda estilo póker para situar a los LLM alrededor de una mesa, mostrando respuestas, estados de pensamiento y actividad de investigación. Este enfoque visual se implementó como un componente Gradio personalizado, que fue central para la presentación y permitió que el proyecto calificara para múltiples pistas del hackathon. El desarrollo del componente se apoyó en la excelente experiencia de desarrollo de Gradio, con una única brecha de documentación sobre publicación en PyPI que llevó al autor a hacer su primera contribución al proyecto Gradio. El estado de la mesa se gestiona mediante un diccionario de sesión: un objeto de estado central registra participantes, mensajes, orador actual, pensando y mostrar burbujas, actualizado a través de callbacks update_visual_state para generar actualizaciones en tiempo real. El proyecto también exploró la necesidad de roles claros para fomentar debates productivos entre LLMs. Al introducir roles distintos y un analista líder para sintetizar el resultado final y evaluar si se alcanzó el consenso, la dinámica de discusión mejoró. Se añadieron dos modos de comunicación, además del compartimiento de contexto completo, para dar a los usuarios más control sobre la interacción de los modelos durante los debates. Se configuraron rondas de discusión (1–5), y se observó que más rondas aumentan la probabilidad de consenso a costa de mayor costo computacional.

Qué hay de nuevo

Desde su inicio, Consilium ha incorporado varias características e integraciones notables. La plataforma ahora incluye:

- Un mecanismo de analista líder donde el usuario selecciona un LLM para sintetizar el resultado final y evaluar si se alcanzó consenso.

- Rondas de discusión configurables (1–5), con pruebas que muestran que más rondas aumentan la probabilidad de consenso, pero requieren más cómputo.

- Una selección actual de modelos que incluye Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B y QwQ-32B. Modelos como Claude Sonnet y o3 de OpenAI no se incluyeron por motivos de créditos de hackathon y consideraciones de patrocinadores, no por limitaciones técnicas.

- Un agente de investigación dedicado para modelos que admiten llamadas de función, que aparece como otro participante en la mesa. Este agente accede a cinco fuentes: Web Search, Wikipedia, arXiv, GitHub y SEC EDGAR.

- Una arquitectura base extensible para herramientas de investigación, con prioridad a recursos libremente integrables.

- Indicadores de progreso y estimaciones de tiempo para tareas de investigación largas para mantener el compromiso.

- Compatibilidad con Open Floor Protocol (OFP) para estandarizar la comunicación entre agentes. OFP permite invitar y retirar dinámicamente agentes, manteniendo la conciencia de la conversación. El proyecto está integrando OFP y se puede ver más en https://huggingface.co/spaces/azettl/consilium_ofp. Estas mejoras reflejan tendencias de investigación en multi-agentes y fueron impulsadas por el trabajo de MAI-DxO y el ecosistema Gradio. Si quieres ver el progreso de la integración OFP, consulta el espacio vinculado.

Por qué importa (impacto para desarrolladores/empresas)

Consilium ilustra un cambio de paradigma, de depender de un único modelo de IA a sistemas colaborativos donde múltiples modelos especializados discuten y sintetizan resultados. El blog señala que la colaboración entre perspectivas múltiples puede superar la analítica de un solo modelo, y este enfoque tiene implicaciones para desarrolladores y empresas:

- Decisiones de mayor calidad: debates estructurados con roles y síntesis por analista líder pueden proporcionar conclusiones más sólidas.

- Flexibilidad y extensibilidad: el servidor MCP y la arquitectura modular permiten integrarlo en flujos de trabajo existentes y ampliar modelos y tipos de agentes.

- Transparencia y trazabilidad: el estado de la mesa y las actualizaciones incrementales ofrecen una visión clara de cómo se alcanzaron las conclusiones, con el razonamiento y la actividad de investigación visibles para los usuarios.

- Flujos de trabajo colaborativos personalizables: los usuarios pueden ajustar el número de rondas, definir roles y elegir entre un conjunto creciente de modelos para casos de uso específicos y restricciones de recursos. Este enfoque se alinea con patrones de la industria en orquestación y gobernanza de IA y sugiere que los sistemas multi-agente podrían convertirse en una alternativa práctica o complemento para grandes modelos de propósito general en muchos casos de uso. Al combinar una interfaz visual interactiva con un backend robusto (servidor MCP) y protocolos basados en estándares (Open Floor Protocol), Consilium se posiciona como un modelo para flujos de trabajo de IA colaborativos en implementaciones del mundo real.

Detalles técnicos o Implementación

En su núcleo, Consilium gestiona un estado por sesión que impulsa la visualización frontend y la lógica de debate backend. Las claves incluyen: participantes, mensajes, currentSpeaker, thinking y showBubbles. Las mutaciones de estado ocurren mediante un bucle de actualización sencillo: cuando los modelos están pensando, hablando o realizando investigaciones, el backend añade entradas a la lista de mensajes y alterna los indicadores de speaker/pensamiento, generando retroalimentación visual en tiempo real sin máquinas de estado complejas. Elecciones arquitectónicas clave:

- Integración MCP: Consilium funciona como servidor MCP, capaz de comunicarse con proyectos y aplicaciones existentes para facilitar la integración en flujos de trabajo reales.

- Componente Gradio personalizado: la visualización de la mesa se implementa con un componente Gradio enriquecido, que ofrece interacciones como burbujas de habla, estados de pensamiento y progreso de investigación, y que sirve como base para la demostración de colaboración entre múltiples modelos en tiempo real.

- Roles de agentes distintos: la introducción de roles permitió que el debate fuera más productivo, evitando que el contexto total compartido no estructurado impidiera la participación.

- Síntesis por analista líder: los usuarios designan a un LLM para sintetizar la salida final y determinar si se alcanzó consenso, proporcionando un punto de decisión claro.

- Rondas configurables: 1–5 rondas, equilibrando costo computacional y probabilidad de consenso.

- Selección de modelos: la lista actual incluye Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B y QwQ-32B. Claude Sonnet y OpenAI o3 no están incluidos por motivos de créditos de hackathon y patrocinadores.

- Agente de investigación para llamadas de función: para modelos que soportan llamadas de función, este agente aparece como participante adicional. Este agente accede a cinco fuentes (Web Search, Wikipedia, arXiv, GitHub y SEC EDGAR) mediante una arquitectura base extensible.

- Integración OFP: OFP estandariza el intercambio de mensajes entre agentes y permite invitar o retirar agentes dinámicamente, manteniendo la conciencia de la conversación. El desarrollo OFP está en marcha, con un espacio dedicado en https://huggingface.co/spaces/azettl/consilium_ofp. En términos de flujo de trabajo, las operaciones de investigación pueden requerir tiempo. Para mantener el compromiso, la interfaz muestra indicadores de progreso y estimaciones de tiempo para tareas de investigación, asegurando una visibilidad de las duraciones previstas. El diseño del proyecto refleja investigaciones en IA multi-agente y estudios fundacionales sobre ampliar el pensamiento divergente mediante debates entre múltiples agentes. La experiencia comunitaria durante el hackathon, con apoyo y colaboración en Discord, también influyó en el desarrollo. Si te interesa ver la evolución de la integración OFP, consulta el espacio vinculado.

Puntos clave

- Consilium demuestra que los debates entre varios LLM pueden producir resultados de mayor calidad que un único modelo.

- La mesa redonda visual de Gradio, combinada con un servidor MCP, ofrece una plataforma integrable y escalable para flujos de trabajo de IA colaborativos.

- Los roles, el analista líder y las rondas configurables mejoran el compromiso y la calidad de las decisiones.

- El agente de investigación dedicado y el acceso a cinco fuentes permiten una investigación robusta y auditable, manteniendo una experiencia uniforme entre modelos con llamadas de función.

- La integración OFP está en progreso para estandarizar la colaboración entre agentes entre plataformas.

FAQ

-

- **Q : ¿Qué es Consilium?**

Una plataforma multi-LLM que permite a IA discutir preguntas y llegar a consenso mediante debates estructurados, disponible como espacio Gradio y como servidor MCP. - **Q : ¿Qué modelos están actualmente en Consilium?** **A :** Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B y QwQ-32B. Claude Sonnet y OpenAI o3 no están incluidos por créditos de hackathon y patrocinadores, no por limitaciones técnicas. - **Q : ¿Qué es el Open Floor Protocol en este contexto?** **A :** Un protocolo de comunicación entre agentes con mensajes JSON estandarizados; la integración OFP permite invitar y retirar dinámicamente agentes manteniendo la continuidad de la conversación. Ver https://huggingface.co/spaces/azettl/consilium_ofp. - **Q : ¿Cómo se determina el consenso?** **A :** Un analista líder sintetiza el resultado final y evalúa si se alcanzó consenso, dentro de rondas configurables. - **Q : ¿Cuáles son los componentes técnicos principales?** **A :** Un servidor MCP, un componente Gradio personalizado para la mesa, un estado de sesión, un agente de investigación con cinco fuentes y planes para OFP.

Referencias

More news

Scaleway se une a los Proveedores de Inferencia de Hugging Face para Inferencia Serverless y de Baja Latencia

Scaleway es ahora un Proveedor de Inferencia soportado en Hugging Face Hub, lo que permite inferencia serverless directamente en las páginas de modelos con los SDK de JS y Python. Accede a modelos open-weight populares y disfruta de flujos de IA escalables y de baja latencia.

Cómo reducir cuellos de botella KV Cache con NVIDIA Dynamo

NVIDIA Dynamo offloads KV Cache desde la memoria de la GPU hacia almacenamiento económico, habilitando contextos más largos, mayor concurrencia y costos de inferencia más bajos para grandes modelos y cargas de IA generativa.

Reduciendo la latencia en frío para la inferencia de LLM con NVIDIA Run:ai Model Streamer

Análisis detallado de cómo NVIDIA Run:ai Model Streamer disminuye los tiempos de arranque en frío al transmitir pesos a la memoria GPU, con benchmarks en GP3, IO2 y S3.

Agilizar el acceso a cambios de contenido ISO-rating con Verisk Rating Insights y Amazon Bedrock

Verisk Rating Insights, impulsado por Amazon Bedrock, LLM y RAG, ofrece una interfaz conversacional para acceder a cambios ERC ISO, reduciendo descargas manuales y acelerando información precisa.

Cómo msg mejoró la transformación de la fuerza laboral de RR. HH. con Amazon Bedrock y msg.ProfileMap

Este artículo explica cómo msg automatizó la armonización de datos para msg.ProfileMap usando Amazon Bedrock para impulsar flujos de enriquecimiento impulsados por LLM, aumentando la precisión de la coincidencia de conceptos de RR. HH., reduciendo la carga de trabajo manual y alineándose con la UE A

Automatizar pipelines RAG avanzados con Amazon SageMaker AI

Optimiza la experimentación a la producción para Retrieval Augmented Generation (RAG) con SageMaker AI, MLflow y Pipelines, para flujos reproducibles, escalables y con gobernanza.