Seq vs Seq: la suite Ettin de codificadores y decodificadores emparejados

Sources: https://huggingface.co/blog/ettin, Hugging Face Blog

TL;DR

- Ettin presenta los primeros modelos de vanguardia emparejados entre codificador (encoder) y decodificador (decoder), entrenados con datos idénticos, formas de modelo idénticas y recetas de entrenamiento idénticas fuente.

- La suite abarca seis escalas, desde 17M hasta 1B parámetros para codificadores y decodificadores fuente.

- El entrenamiento sigue una receta de tres fases: preentrenamiento en 1,7T de tokens con contextos cortos, extensión de contexto a 8K tokens en 250B tokens, y una fase de decaimiento con 100B tokens de fuentes premium fuente.

- Todos los datos de entrenamiento son públicos y reproducibles, lo que permite comparaciones equitativas; los codificadores destacan en clasificación y recuperación, mientras que los decodificadores lideran en generación fuente.

- En benchmarks, los modelos Ettin superan o igualan a baselines establecidos como Llama 3.2 1B y SmolLM2, con mejoras destacadas en tareas de alto contenido de conocimiento como SciQ fuente.

Contexto y antecedentes

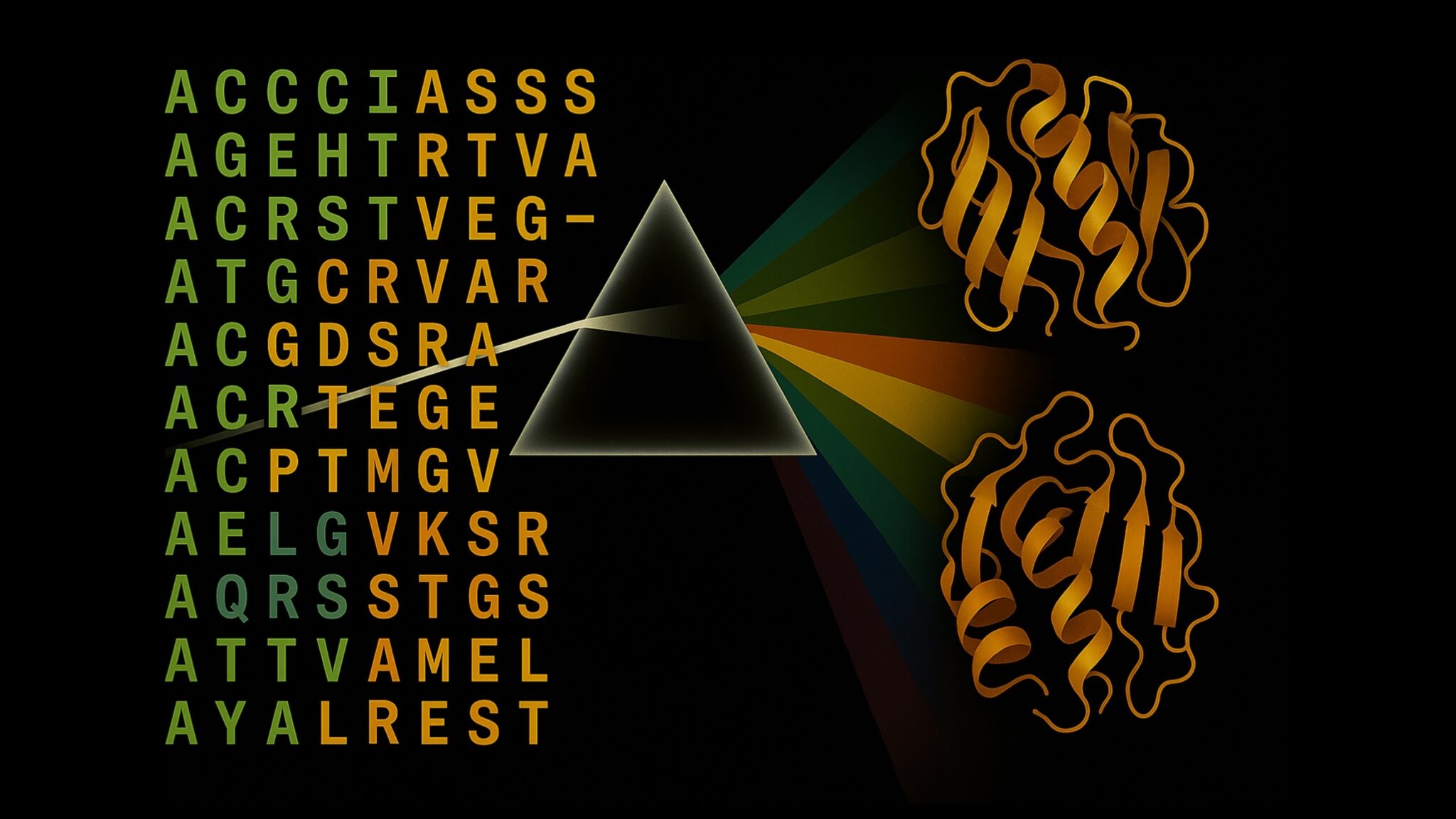

La comunidad de LLMs ha convergido principalmente en modelos solo de decodificador para generación, mientras que los modelos solo de codificador siguen siendo clave para tareas de producción como clasificación, recuperación y embeddings. Los codificadores suelen ser más rápidos y consumen menos memoria para tareas discriminativas, pero históricamente han quedado rezagados en capacidades generativas frente a los decodificadores. Ettin propone una comparación justa entre ambas arquitecturas entrenándolas con los mismos datos, las mismas recetas y las mismas dimensiones de modelo; las únicas diferencias son los patrones de atención y los objetivos de entrenamiento. La iniciativa toma su nombre de un gigante de dos cabezas de la mitología nórdica, reflejando su enfoque de arquitecturas emparejadas. Todos los datos utilizados en Ettin son públicos y reproducibles, reforzando el compromiso con la ciencia abierta y la reproducibilidad. Puedes continuar entrenando estos modelos con nuevos datos o proponer una nueva receta para mejorar aún más fuente.

Novedades

Ettin presenta una suite coherente de seis modelos para cada arquitectura (encoder y decoder), que abarcan de 17M a 1B de parámetros. Se aplica la misma base de datos, las mismas formas de modelo y la misma receta de entrenamiento a ambas familias para permitir comparaciones justas entre patrones de atención y objetivos. Específicamente:

- Se exploran dos objetivos de entrenamiento en un marco controlado: MLM para codificadores y CLM para decodificadores. La misma base de datos y la misma receta se aplican a ambos, permitiendo un análisis justo de arquitectura vs objetivo.

- El régimen de datos es público y reproducible: los datos de entrenamiento son públicos, permitiendo que investigadores reproduzcan resultados o amplíen el entrenamiento con nuevos datos.

- Ettin sigue un enfoque de tres fases, heredado de ModernBERT, con extensión de contexto hasta 8K tokens usando datos filtrados de alta calidad. La fase 3 utiliza 100B tokens de fuentes premium y reduce gradualmente la tasa de aprendizaje fuente.

- Los modelos encoder y decoder muestran rendimientos de punta para modelos abiertos en diversas tareas y escalas. En varias evaluaciones, los codificadores Ettin superan a ModernBERT, mientras que los decodificadores Ettin superan o igualan a baselines establecidos como Llama 3.2 y SmolLM2, con ganancias destacadas en tareas de conocimiento como SciQ fuente.

- Los resultados resaltan ventajas arquitecturales fundamentales que persisten cuando se controlan datos, recetas y escalas: los codificadores destacan en clasificación y recuperación, mientras que los decodificadores conservan una ventaja en generación a medida que la escala aumenta. Un experimento adicional invirtió el objetivo después de entrenar para estudiar cómo las decisiones de objetivo influyen en el aprendizaje, mostrando que la arquitectura importa más allá del objetivo mismo fuente.

- Para investigadores y profesionales, Ettin ofrece boilerplates prácticos y un camino claro para reproducir o ampliar el trabajo. Los autores invitan a probar los modelos y considerar flujos de trabajo de clasificación, recuperación y generación usando codificadores o decodificadores fuente.

Por qué es importante (impacto para desarrolladores/empresas)

La contribución central de Ettin es permitir comparaciones justas entre arquitecturas de codificador y decodificador bajo condiciones idénticas de datos y recetas. Esto facilita a los equipos elegir la backbone adecuada para una aplicación, ya sea un modelo discriminativo rápido para dispositivos o un sistema generativo más capaz para tareas de contexto largo. El carácter abierto de los datos y las recetas reduce la barrera de entrada y facilita la reproducción y extensión por equipos que desean adaptar modelos de alto rendimiento a sus propios conjuntos de datos. En la práctica, las empresas pueden evaluar: (1) qué arquitectura funciona mejor para clasificación y recuperación frente a generación, (2) cómo la escala afecta el rendimiento en un régimen de datos común, y (3) si cambiar el objetivo influye en el comportamiento y sesgos en escenarios de despliegue fuente.

Detalles técnicos o Implementación

La suite Ettin incluye seis escalas de modelo para cada arquitectura (encoder y decoder), desde 17M hasta 1B de parámetros. A ambas familias se aplica la misma base de datos, las mismas formas de modelo y la misma receta de entrenamiento para asegurar comparaciones justas entre patrones de atención y objetivos. La estrategia de entrenamiento en tres fases es central: 1) preentrenamiento con 1,7T tokens y contextos cortos (1024) para sentar bases, 2) extensión de contexto a 8K tokens con datos filtrados de alta calidad, 3) fase de decaimiento con 100B tokens de fuentes premium y reducción progresiva de la tasa de aprendizaje. Un experimento clave consistió en continuar el entrenamiento durante 50B tokens con el objetivo opuesto (MLM para codificadores, CLM para decodificadores) para estudiar cómo el objetivo influye en el aprendizaje bajo el mismo marco de arquitectura y datos. El carácter abierto de Ettin facilita la exploración de ventajas arquitecturales y dinámicas de sesgos con entradas transparentes fuente.

Conclusiones clave

- Ettin establece un marco justo para comparar arquitecturas encodeur y decodeur, usando datos, formas y recetas idénticos.

- Los codificadores sobresalen en clasificación y recuperación, incluso a tamaños modestos, mientras que los decodificadores muestran ventajas en generación, especialmente a mayor escala.

- La suite de seis escalas (17M–1B) para ambas familias ofrece opciones de implementación variadas, desde modelos ligeros para dispositivos hasta sistemas más potentes.

- Todo el conjunto de datos de Ettin es público y reproducible, lo que facilita la réplica y la extensión por la comunidad.

- Un experimento que invierte el objetivo tras el entrenamiento inicial demuestra que la arquitectura importa más allá del objetivo, con impactos mensurables en el aprendizaje y el comportamiento, incluso en métricas de sesgo.

- Ettin proporciona boilerplates prácticos y un camino claro para probar modelos abiertos en tareas de clasificación, recuperación y generación fuente.

FAQ

-

¿Qué es Ettin?

Ettin se describe como la primera suite de modelos de punta emparejados entre encoder y decoder, entrenados con datos idénticos, formas y recetas, con diferencias principalmente en patrones de atención y objetivos de entrenamiento [fuente](https://huggingface.co/blog/ettin).

-

¿Cuántas escalas existen y cuál es el rango?

Seis escalas para encodeurs y decodificadores, desde 17M hasta 1B de parámetros [fuente](https://huggingface.co/blog/ettin).

-

¿Qué régimen de datos se utiliza?

Un enfoque de tres fases con 1,7T tokens para preentrenamiento, 250B tokens para extender el contexto a 8K, y 100B tokens de fuentes premium para la fase de decaimiento; los datos son públicos y reproducibles [fuente](https://huggingface.co/blog/ettin).

-

¿Cómo se comparan los resultados con baselines conocidos?

Los codificadores Ettin superan al ModernBERT y los decodificadores Ettin superan o igualan baselines como Llama 3.2 y SmolLM2, con mejoras notables en tareas de conocimiento como SciQ [fuente](https://huggingface.co/blog/ettin).

-

¿Puedo reproducir o probar estos modelos yo mismo?

Sí. También hay boilerplates y todos los datos son públicos para facilitar la reproducción o extensión [fuente](https://huggingface.co/blog/ettin).

Referencias

More news

Scaleway se une a los Proveedores de Inferencia de Hugging Face para Inferencia Serverless y de Baja Latencia

Scaleway es ahora un Proveedor de Inferencia soportado en Hugging Face Hub, lo que permite inferencia serverless directamente en las páginas de modelos con los SDK de JS y Python. Accede a modelos open-weight populares y disfruta de flujos de IA escalables y de baja latencia.

Reduciendo la latencia en frío para la inferencia de LLM con NVIDIA Run:ai Model Streamer

Análisis detallado de cómo NVIDIA Run:ai Model Streamer disminuye los tiempos de arranque en frío al transmitir pesos a la memoria GPU, con benchmarks en GP3, IO2 y S3.

Cómo msg mejoró la transformación de la fuerza laboral de RR. HH. con Amazon Bedrock y msg.ProfileMap

Este artículo explica cómo msg automatizó la armonización de datos para msg.ProfileMap usando Amazon Bedrock para impulsar flujos de enriquecimiento impulsados por LLM, aumentando la precisión de la coincidencia de conceptos de RR. HH., reduciendo la carga de trabajo manual y alineándose con la UE A

Cómo la quantización consciente (QAT) recupera precisión en inferencia de baja precisión

Analiza QAT y QAD como métodos para recuperar precisión en modelos de baja precisión, utilizando el TensorRT Model Optimizer y formatos FP8/NVFP4/MXFP4.

Acelerar la Inferencia de Estructura de Proteínas en Más de 100x con NVIDIA RTX PRO 6000 Blackwell Server Edition

El RTX PRO 6000 Blackwell Server Edition de NVIDIA acelera de forma notable la inferencia de estructuras de proteínas, permitiendo flujos de trabajo end-to-end en GPU con OpenFold y TensorRT, hasta 138x más rápido que AlphaFold2.

Por qué los modelos de lenguaje 'alucinan' y cómo OpenAI está cambiando las evaluaciones para la fiabilidad

OpenAI explica que las alucinaciones en modelos de lenguaje provienen de incentivos de evaluación que premian la conjetura sobre la incertidumbre. El artículo detalla cómo puntajes y benchmarks sensibles a la incertidumbre pueden reducir errores confiados.