¿Estamos listos para el razonamiento con varias imágenes? Visual Haystacks ya está aquí

Sources: http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks, bair.berkeley.edu

TL;DR

- Visual Haystacks (VHs) es una referencia para evaluar cómo los grandes modelos multimodales realizan recuperación visual y razonamiento con contexto largo en conjuntos de imágenes no correlacionadas.

- El benchmark introduce dos formatos de tarea: Single-Needle (aguja única) y Multi-Needle (varias agujas), desafiando a los modelos a localizar y razonar sobre imágenes que contienen el contenido objetivo dentro de un haz de imágenes.

- Los resultados muestran que los modelos actuales, tanto de código abierto como comerciales, luchan a medida que el haz de imágenes crece, revelando límites en la recuperación visual y la integración entre imágenes.

- MIRAGE, un marco de entrenamiento de código abierto, extiende LLaVA para MIQA mediante compresión guiada por la consulta, un recuperador y datos multi-imagen, logrando un rendimiento sólido en tareas de aguja única y un desempeño competitivo en multi-imagen.

- El trabajo subraya la brecha entre el razonamiento basado en subtítulos y la integración real entre múltiples imágenes, ofreciendo un camino práctico hacia un razonamiento visual de largo contexto robusto.

Contexto y antecedentes

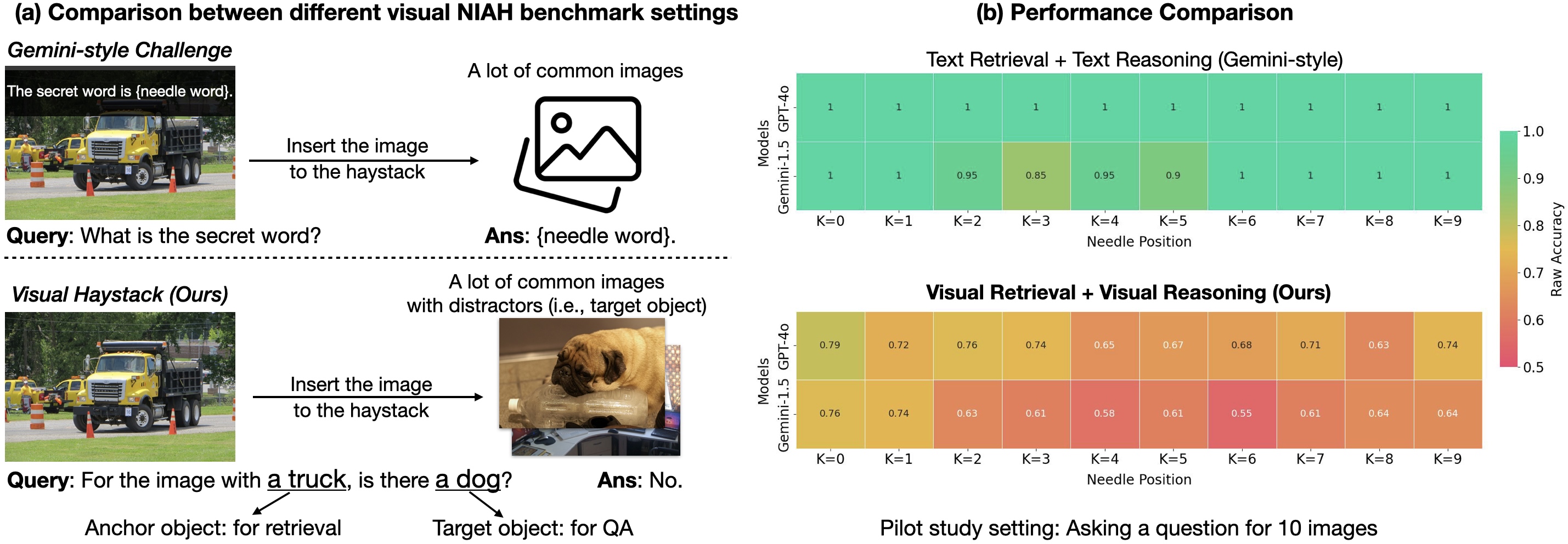

El VQA tradicional se centraba en responder preguntas sobre una sola imagen. Aunque los modelos base han reducido la brecha en visión, los escenarios reales suelen requerir razonamiento a través de cientos o miles de imágenes y una sinopsis entre ellas. Esto motiva la tarea MIQA (Multi-Image Question Answering). Visual Haystacks (VHs) es la primera referencia centrada en lo visual para evaluar grandes modelos multimodales en información visual de largo contexto. El formato Needle-In-A-Haystack (NIAH) implica localizar un elemento clave dentro de un gran conjunto de datos y responder con base en esa información. La idea es similar a otros benchmarks de largo contexto donde la respuesta depende de encontrar la aguja en el haz de heno. El primer benchmark visual NIAH fue introducido en el informe técnico Gemini-v1.5 de Google, que evaluó la recuperación de texto sobre un solo fotograma de video; sin embargo, ese trabajo se centró principalmente en recuperar texto, no en integrar información visual entre varias imágenes. VHs dirige el enfoque hacia contenido visual distribuido a lo largo de múltiples imágenes. Source. En VHs, las preguntas giran en torno a identificar si un contenido visual objetivo está presente en las imágenes que contienen una imagen ancla. El conjunto utiliza anotaciones de COCO y consta de aproximadamente 1K pares de preguntas y respuestas binarias por haz. Los conjuntos varían entre 1 y 10K imágenes por haz, generando desafíos de recuperación y razonamiento para modelos LMM. El benchmark se divide principalmente en dos configuraciones: Single-Needle y Multi-Needle, diseñadas para probar la capacidad del modelo de recuperar imágenes relevantes sin sesgos y de razonar entre esas imágenes para responder a la pregunta binaria. Source. Los resultados destacan diferencias críticas: mientras algunos modelos muestran rendimiento oracle bajo escenarios limitados, su rendimiento se degrada a medida que el haz crece debido a la presencia de distractores visuales. Incluso modelos con contexto extendido deben enfrentar límites de payload cuando el número de imágenes es alto. Estos hallazgos señalan dos retos centrales: recuperar imágenes relevantes en grandes pools y combinar información visual para responder con precisión. Source.

Qué hay de nuevo

Visual Haystacks propone un enfoque centrado en lo visual para razonamiento con contexto largo que va más allá de tareas de recuperación textual. El conjunto contiene unas 1K pares binarios de QA y admite hazs de 1K a 10K imágenes. Los formatos de aguja única y multi-aguja evalúan tanto la capacidad de recuperación como el razonamiento entre imágenes. La evaluación incluye modelos open-source y propietarios. Modelos notables evaluados incluyen LLaVA-v1.5, GPT-4o, Claude-3 Opus y Gemini-v1.5-pro, con una línea de baseline de “captioning” que usa LLaVA para generar descripciones y luego responde a la pregunta con Llama3. Una observación clave es la dificultad que presentan los distractores visuales y grandes volúmenes de imágenes. Por ejemplo, LLaVA puede manejar solo hasta tres imágenes debido a un límite de contexto de ~2K, mientras que modelos más grandes pueden enfrentar limitaciones de payload cuando el haz alcanza miles de imágenes. En respuesta, se propone MIRAGE (Multi-Image Retrieval Augmented Generation) como una ruta práctica para MIQA con tres componentes:

- Compresión de codificaciones: MIRAGE utiliza un modelo de compresión sensible a la consulta para reducir los tokens del codificador visual en aproximadamente 10x, permitiendo más imágenes en el mismo contexto sin perder señales relevantes.

- Recuperador integrado: un recuperador se entrena conjuntamente con el ajuste del LLM para predecir la relevancia de la imagen y eliminar imágenes irrelevantes en tiempo real.

- Datos de entrenamiento multi-imagen: MIRAGE amplía los datos de entrenamiento existentes con datos de razonamiento multi-imagen y datos sintéticos de razonamiento multi-imagen. Con este enfoque, MIRAGE puede manejar hazs de 1K o 10K imágenes y alcanza un rendimiento de vanguardia en la mayoría de tareas de aguja única, a pesar de usar un backbone ligero con solo 32 tokens por imagen. En escenarios multi-imagen, MIRAGE demuestra recordar y precisión fuertes, superando a competidores como GPT-4, Gemini-v1.5 y LWM en varias configuraciones. También muestra resultados competitivos en QA de imagen única. El recuperador de MIRAGE, entrenado de forma conjunta con el LLM, puede superar a CLIP en tareas de recuperación orientadas a preguntas, destacando que las similitudes texto-imagen generales pueden no ser tan efectivas para filtraje basado en preguntas. Source. El marco MIRAGE se presenta como una solución abierta y de una sola etapa que complementa VHs, ofreciendo un camino práctico para capacidades MIQA robustas. El trabajo también discute fenómenos como el efecto Lost-in-the-Middle, donde la posición de la aguja en la secuencia de entrada influye significativamente en el rendimiento. Por ejemplo, el LLaVA tiende a rendir mejor cuando la aguja aparece justo antes de la pregunta, mientras que los modelos propietarios prefieren las imágenes al inicio de la secuencia, con caídas de rendimiento de hasta 26–28% si la posición no es ideal. Estos hallazgos guían las decisiones de diseño para equilibrar el presupuesto de tokens y la retención de información visual. Source. A continuación, un resumen de los componentes y capacidades clave que caracterizan MIRAGE y el benchmark VHs. | Componente / Capacidad | Descripción | Rasgo Clave |--- |--- |--- |Visual Haystacks (VHs) | Benchmark con ~1K pares QA en hazs de 1K–10K imágenes | Evalúa recuperación y razonamiento de contexto visual largo |Configuraciones de aguja | Single-Needle y Multi-Needle | Mide recuperación y razonamiento inter-imágenes |Restricciones de contexto | LLaVA 2K; otros modelos con payload extendido | Subraya necesidad de codificación eficiente y recuperación |MIRAGE | Extensión MIQA | Compresión guiada por la consulta, recuperador, datos multi-imagen |Desempeño | MIRAGE en aguja única llega a la vanguardia; multi-imagen competitivo | Supera varios modelos en tareas clave; QA de imagen única competitiva |Comparación de recuperadores | Recuperador co-entrenado con el LLM vs CLIP | MIRAGE supera CLIP en escenarios orientados a preguntas |

Por qué importa (impacto para desarrolladores/empresas)

Visual Haystacks y MIRAGE ofrecen implicaciones prácticas para aplicaciones que requieren decisiones basadas en grandes flujos de datos visuales. Para equipos y empresas:

- El razonamiento visual con contexto largo sigue siendo desafiante cuando se manejan grandes volúmenes de imágenes no correlacionadas, impactando áreas como imágenes médicas, monitoreo satelital, análisis urbano y vigilancia con grandes cantidades de imágenes. VHs muestra que los modelos actuales luchan con distracciones visuales y con la integración entre imágenes, incluso cuando enfoques basados en subtítulos pueden funcionar para QA simple. Source.

- MIRAGE ofrece un camino práctico para escalar: compresión de codificaciones, filtrado por recuperador y entrenamiento con datos multi-imagen permiten manejar hazs de hasta 10K imágenes manteniendo desempeño. Esto es relevante para plataformas de análisis visual, QA automático y aplicaciones industriales con volúmenes altos de imágenes. Source.

- Los hallazgos también resaltan que depender sólo de subtítulos para tareas MIQA no resuelve todos los retos de razonamiento entre imágenes. Aunque una estrategia de caption-then-LLM puede funcionar para QA en una imagen, la integración entre imágenes para MIQA requiere recuperación y codificación específicas. MIRAGE ofrece un camino práctico para esto. Source.

Detalles técnicos o Implementación

MIRAGE se apoya en LLaVA y lo extiende para tareas de QA multi-imagen. Sus componentes clave:

- Compresión de codificaciones: MIRAGE emplea un modelo de compresión sensible a la consulta que reduce los tokens del codificador visual en aproximadamente 10x, permitiendo más imágenes dentro del mismo contexto sin perder señales relevantes.

- Recuperador integrado: un recuperador es treinado junto con el ajuste del LLM para predecir la relevancia de cada imagen para la pregunta, descartando imágenes irrelevantes en tiempo real y reduciendo ruido.

- Datos de entrenamiento multi-imagen: el marco amplía los datos de entrenamiento existentes con datos de razonamiento multi-imagen y datos sintéticos para enseñar al modelo a razonar entre imágenes.

- Escalabilidad y código abierto: MIRAGE está diseñado para manejar hazs de 1K a 10K imágenes, usando un backbone liviano con solo 32 tokens por imagen.

- Rendimiento y comparaciones: en tareas de aguja única, MIRAGE alcanza resultados de punta; en tareas multi-imagen, muestra recall y precisión altos, superando a modelos como GPT-4, Gemini-v1.5 y LWM en varias configuraciones. El recuperador co-entrenado con el LLM puede superar a CLIP en tareas orientadas a preguntas, subrayando la utilidad de recuperaciones específicas para estas tareas. Source. Desde un punto de vista arquitectónico, VHs señala que el razonamiento visual de contexto largo requiere algo más que un QA backbone individual; necesita filtrado, compresión y una integración entre imágenes, junto con datos de entrenamiento que reflejen escenarios multi-imagen. MIRAGE propone una receta práctica para resolver estos retos en pipelines de análisis de imágenes. Source.

Puntos clave

- VHs revela que los modelos actuales luchan con distractores cuando el número de imágenes crece, incluso si muestran buena capacidad en QA de una sola imagen.

- La posición de la aguja dentro de la secuencia influye significativamente en el rendimiento, un efecto similar al Lost-in-the-Middle conocido en NLP.

- MIRAGE ofrece un camino de código abierto para MIQA, combinando compresión guiada, recuperación co-entrenada y datos multi-imagen para manejar hasta 10K imágenes.

- Un recuperador entrenado junto con el LLM puede superar a CLIP para tareas basadas en preguntas, enfatizando el valor de estrategias de recuperación específicas para la tarea.

- Visual Haystacks y MIRAGE proporcionan pautas accionables para construir y evaluar sistemas de razonamiento visual de largo contexto en aplicaciones reales como medicina, monitoreo satelital y análisis urbano. Source.

FAQ

-

¿Qué es Visual Haystacks (VHs)?

VHs es una referencia diseñada para evaluar cómo los grandes modelos multimodales recuperan y razonan a partir de grandes conjuntos de imágenes no correlacionadas, con preguntas binarias sobre la presencia del contenido objetivo. [Source](http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks).

-

¿Qué es MIRAGE en este contexto?

MIRAGE significa Multi-Image Retrieval Augmented Generation; extiende LLaVA para tareas MIQA mediante compresión guiada por la consulta, recuperador integrado y datos multi-imagen. [Source](http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks).

-

¿Cómo afecta la posición de la aguja al rendimiento?

La posición de la aguja en la secuencia puede provocar caídas de rendimiento de hasta ~26–28% según el modelo y el contexto. [Source](http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks).

-

¿MIRAGE es mejor que CLIP como recuperador?

Sí, el recuperador MIRAGE entrenado con el LLM puede superar a CLIP en tareas orientadas a preguntas, subrayando la utilidad de recuperaciones específicas para la tarea. [Source](http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks).

-

¿Dónde obtener más detalles o código?

La documentación del benchmark y MIRAGE está disponible en el enlace de la fuente proporcionada. [Source](http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks).

Referencias

- Visual Haystacks y MIRAGE: http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks

More news

Reduciendo la latencia en frío para la inferencia de LLM con NVIDIA Run:ai Model Streamer

Análisis detallado de cómo NVIDIA Run:ai Model Streamer disminuye los tiempos de arranque en frío al transmitir pesos a la memoria GPU, con benchmarks en GP3, IO2 y S3.

Cómo msg mejoró la transformación de la fuerza laboral de RR. HH. con Amazon Bedrock y msg.ProfileMap

Este artículo explica cómo msg automatizó la armonización de datos para msg.ProfileMap usando Amazon Bedrock para impulsar flujos de enriquecimiento impulsados por LLM, aumentando la precisión de la coincidencia de conceptos de RR. HH., reduciendo la carga de trabajo manual y alineándose con la UE A

Cómo la quantización consciente (QAT) recupera precisión en inferencia de baja precisión

Analiza QAT y QAD como métodos para recuperar precisión en modelos de baja precisión, utilizando el TensorRT Model Optimizer y formatos FP8/NVFP4/MXFP4.

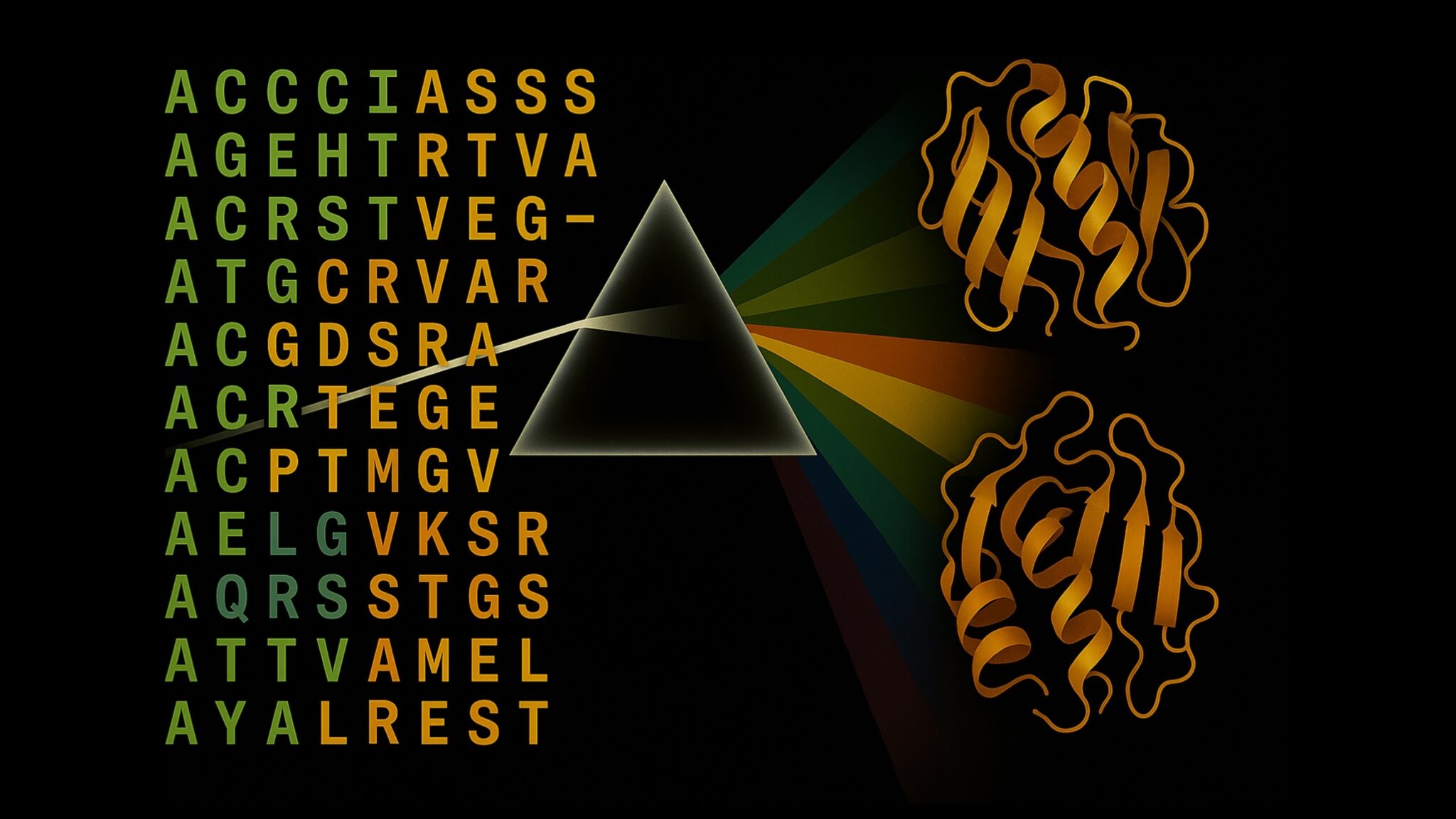

Acelerar la Inferencia de Estructura de Proteínas en Más de 100x con NVIDIA RTX PRO 6000 Blackwell Server Edition

El RTX PRO 6000 Blackwell Server Edition de NVIDIA acelera de forma notable la inferencia de estructuras de proteínas, permitiendo flujos de trabajo end-to-end en GPU con OpenFold y TensorRT, hasta 138x más rápido que AlphaFold2.

Por qué los modelos de lenguaje 'alucinan' y cómo OpenAI está cambiando las evaluaciones para la fiabilidad

OpenAI explica que las alucinaciones en modelos de lenguaje provienen de incentivos de evaluación que premian la conjetura sobre la incertidumbre. El artículo detalla cómo puntajes y benchmarks sensibles a la incertidumbre pueden reducir errores confiados.

Las listas de verificación superan a los modelos de recompensa para alinear modelos de lenguaje

Un enfoque de RL utiliza listas de verificación derivadas de instrucciones para guiar el alineamiento, superando modelos de recompensa fijos en múltiples benchmarks con Qwen2.5-7B-Instruct, presentado en ICLR 2025.