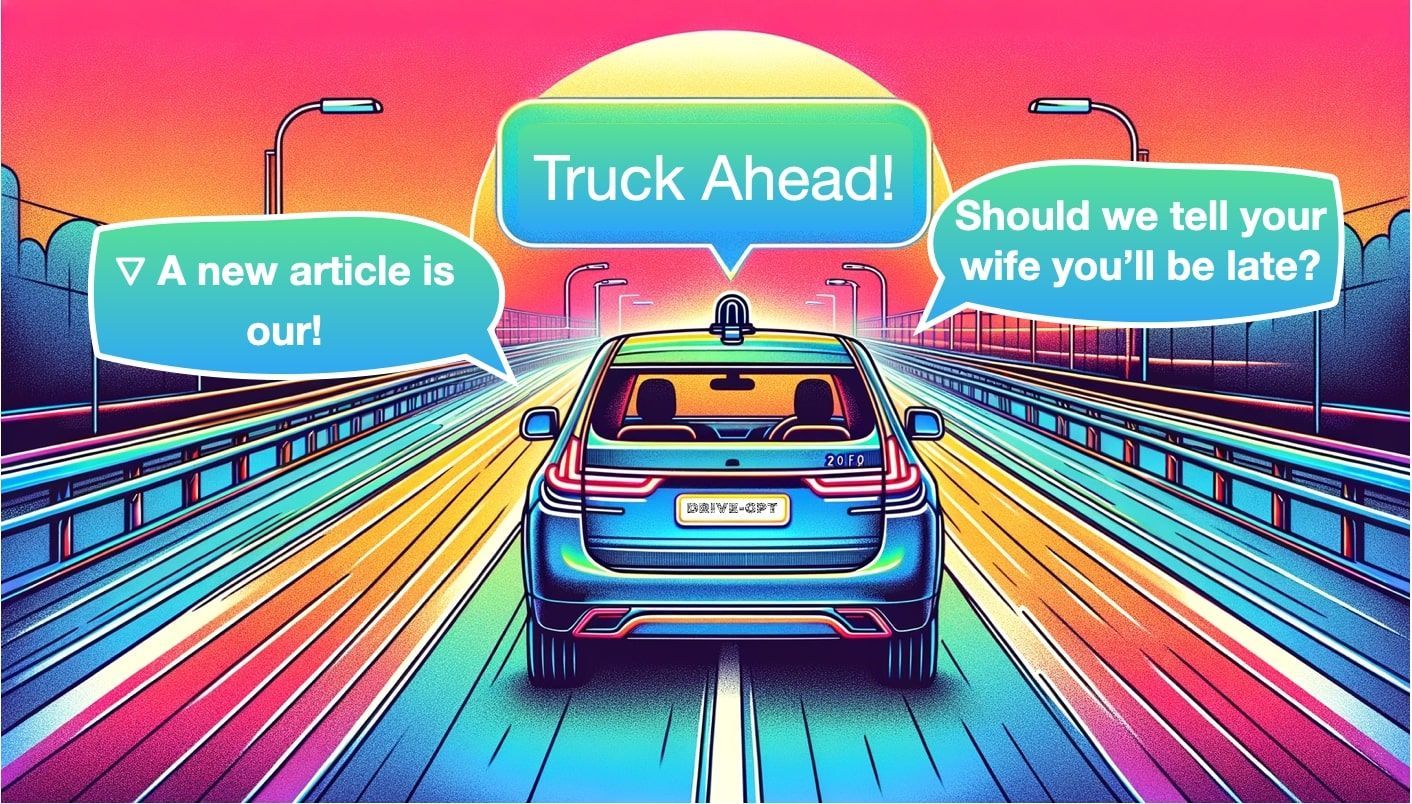

Car-GPT: ¿Podrán los LLMs por fin hacer que los coches autónomos funcionen?

Sources: https://thegradient.pub/car-gpt, thegradient.pub

TL;DR

- Los grandes modelos de lenguaje (LLMs) se exploran en tres roles centrales para la conducción autónoma: Percepción, Planificación y Generación.

- Trabajos tempranos muestran potencial, pero persisten preocupaciones sobre confianza, determinismo y seguridad antes de desplegarlos en la carretera.

- Existen numerosos modelos y enfoques que abarcan desde sistemas orientados a la percepción hasta planificación enriquecida por lenguaje y capacidades de generación de escenas o videos.

- Conceptos como mapas BEV enriquecidos con lenguaje y modelos del mundo están ganando atención como formas de fusionar lenguaje con datos de conducción.

- Aún es pronto para afirmar que los LLMs transformarán los coches autónomos; el uso real en vivo es limitado y está en estudio.

Contexto y antecedentes

El artículo enmarca la evolución del software de coches autónomos desde un enfoque modular —percepción, localización, planificación y control— a debates sobre aprendizaje de extremo a extremo, donde una única red neuronal intenta predecir la dirección y la aceleración. Esta transición trae preocupaciones legítimas sobre el carácter de caja negra y la interpretabilidad, que aún no se han resuelto. El texto utiliza la analogía de la penicilina para ilustrar cómo avances transformadores pueden emerger de fuentes aparentemente improbables, sugiriendo que los LLMs podrían desempeñar un papel disruptivo en la conducción autónoma. Se describen tres tareas amplias donde los LLMs pueden contribuir: Percepción, Planificación y Generación, y se revisan modelos notables y enfoques que conectan el lenguaje con datos de conducción. La narrativa recuerda que la primera ola de libros/artículos que mencionan LLMs en coches de dirección apareció a mediados de 2023. Consulta la narrativa completa en la fuente: Car-GPT en The Gradient. En resumen, el texto sostiene que los LLMs aún no constituyen una solución estable para la conducción autónoma, pero ofrecen herramientas prometedoras para ampliar la percepción, la toma de decisiones y la generación de contenido contextual útil para operadores humanos y sistemas autónomos.

¿Qué hay de nuevo?

El artículo mapea tres familias prominentes de uso de LLMs en coches autónomos:

- Percepción: convertir imágenes multicamera en objetos, carriles y otras anotaciones; algunos modelos pueden describir escenas e incluso predecir propiedades de objetos.

- Planificación: usar razonamiento guiado por lenguaje para apoyar la toma de decisiones, a menudo enriqueciendo salidas de percepción o guiando la selección de acciones. Un ejemplo notable es Talk2BEV, que usa entradas BEV (Bird’s Eye View) para proponer decisiones de conducción y puede recortar áreas de interés o sugerir trayectorias.

- Generación: producir contenido orientado al futuro, como videos o escenarios, a partir de observaciones actuales y prompts. El GAIA-1 de Wayve toma texto e imágenes como entrada y genera videos directamente a través de un World Model que representa una comprensión del mundo y sus interacciones. Otros modelos, como MagicDrive, Driving Into the Future y Driving Diffusion, muestran el potencial de generar escenas o escenarios para ampliar datos y entrenamiento. Estos ejemplos muestran que los LLMs pueden contribuir en percepción, toma de decisiones y generación de escenarios, y no se limitan a simples respuestas de texto; se exploran capacidades multimodales integradas. El artículo también discute cómo las salidas generadas pueden mejorar la recopilación de datos y el refinamiento de modelos, creando un ciclo de retroalimentación que podría acelerar la investigación en conducción autónoma. Se advierte que, si bien el potencial es claro, el uso en vivo en carretera sigue siendo limitado y debe abordar la confianza y el determinismo.

¿Por qué importa? (impacto para desarrolladores/empresas)

Desde la perspectiva de desarrolladores y empresas, el potencial de los LLMs en coches autónomos reside en enriquecer las pilas de percepción y planificación con razonamiento basado en lenguaje, prompts y diálogo interactivo. Los LLMs pueden ofrecer una interfaz más transparente para interpretar datos de sensores y ayudar a los operadores humanos a entender por qué se propone una decisión de conducción. Sin embargo, el artículo subraya que la interpretabilidad y la fiabilidad siguen siendo desafíos; el problema de la caja negra persiste para sistemas críticos. El autor imagina un futuro en el que modelos Grok especializados podrían operar en vehículos para preguntas y respuestas y explicaciones situacionales, reconociendo que tales despliegues deben demostrar seguridad, fiabilidad y robustez antes de una adopción generalizada. Para las empresas, esto sugiere explorar rutas de integración modular (combinando razonamiento orientado al lenguaje con módulos existentes de percepción y control) e invertir en marcos de evaluación que midan no solo precisión, sino también fiabilidad, latencia y seguridad en condiciones de conducción diversas. La taxonomía de tareas —Percepción, Planificación y Generación— ofrece un marco útil para priorizar investigación, desarrollo y comunicación de capacidades a las partes interesadas.

Detalles técnicos o Implementación (alto nivel)

El artículo ofrece una guía para entender cómo funcionan los LLMs en este dominio y por qué su arquitectura importa para la conducción.

- Tokenización: la entrada de texto se transforma en tokens (palabras, subpalabras o caracteres), convirtiendo el lenguaje en representaciones numéricas para procesar.

- Arquitectura central: bloques Transformer con atención multi-cabeza, normalización, sumas y concatenaciones; algunos modelos son encoder-decoder, otros pueden ser puramente decodificadores. En todos los casos, la idea es transformar entradas en una representación aprendida y luego predecir una secuencia de tokens (la próxima palabra o decisión).

- Percepción vs. planificación vs. generación: en percepción, los modelos entregan detecciones y salidas BEV; en planificación, aprenden decisiones de conducción o trayectorias; en generación, producen escenas futuras o videos para entrenamiento y pruebas.

- Modalidades de entrada y representaciones: BEV se identifica como una representación más fácil de entender para la planificación, y algunos sistemas combinan imágenes multivista con prompts para refinar salidas. La percepción puede incluir detección de objetos y localización 3D, y la asignación de IDs a objetos rastreados puede usar técnicas de emparejamiento de grafos bipartitos como el Algoritmo de Hungarian.

- Generación de lenguaje y BEV: una tesis central es usar lenguaje para mejorar salidas BEV, pidiendo al modelo recortar regiones, mirar áreas específicas o proponer una ruta de conducción, en lugar de depender solo de los datos sensoriales.

- Modelos de generación de mundo: modelos como GAIA-1 toman entrada de texto e imágenes y generan videos mediante un World Model que intenta comprender el mundo y sus interacciones para predecir cómo evolucionarán las cosas. Ejemplos citados en la discusión incluyen HiLM-D y MTD-GPT para percepción; PromptTrack para asignación de IDs; Talk2BEV para planificación con BEV; DriveGPT para planificar desde la percepción hasta la trayectoria; Wayve GAIA-1 para generación de videos; MagicDrive; Driving Into the Future; y Driving Diffusion como métodos para generar escenas futuras. El artículo advierte que, pese a los avances, el despliegue en vivo debe superar desafíos de confianza y determinismo.

Conclusiones clave

- Los LLMs pueden apoyar la percepción, la planificación y la generación en la conducción autónoma, ofreciendo una vía basada en lenguaje para interpretar, decidir y simular escenarios de conducción.

- Aún no hay adopción generalizada en la carretera; la mayor parte del trabajo es investigación y simulación, con preguntas persistentes sobre seguridad y fiabilidad.

- Se exploran diversas aproximaciones: mapas BEV con lenguaje, generación de videos basada en mundo-modelos y cooperación entre imágenes y lenguaje para planificación y control.

- La preocupación por la transparencia y las cajas negras sugiere la necesidad de evaluaciones rigurosas y, potencialmente, arquitecturas híbridas que combinen LLMs con módulos tradicionales de percepción y planificación.

- La adopción futura probablemente ocurrirá mediante integración gradual, con modelos especializados trabajando junto a pilas existentes, en lugar de reemplazar por completo los sistemas actuales.

FAQ

-

¿Están los LLMs listos para coches autónomos?

Es demasiado pronto para afirmarlo; la primera ola de artículos que mencionan LLMs en conducción apareció a mediados de 2023 y los despliegues en vivo son limitados y aún se estudian.

-

¿Cuáles son las tareas principales para los LLMs en conducción autónoma?

Percepción (detección de objetos y comprensión de escenas), Planificación (decisiones de conducción y trayectorias) y Generación (creación de escenarios futuros o videos para datos y entrenamiento).

-

¿Qué modelos o enfoques se destacan?

Ejemplos: HiLM-D, MTD-GPT (percepción); PromptTrack (asignación de IDs); Talk2BEV (planificación con BEV); DriveGPT (de la percepción a la trayectoria); Wayve GAIA-1 (vídeos desde texto+imagen con World Model); MagicDrive; Driving Into the Future; Driving Diffusion.

-

¿Cuáles son los principales desafíos?

Preocupaciones sobre confianza, determinismo y seguridad asociadas a LLMs de caja negra, además de la necesidad de pruebas rigurosas en escenarios de conducción reales.

Referencias

More news

Cómo reducir cuellos de botella KV Cache con NVIDIA Dynamo

NVIDIA Dynamo offloads KV Cache desde la memoria de la GPU hacia almacenamiento económico, habilitando contextos más largos, mayor concurrencia y costos de inferencia más bajos para grandes modelos y cargas de IA generativa.

Reduciendo la latencia en frío para la inferencia de LLM con NVIDIA Run:ai Model Streamer

Análisis detallado de cómo NVIDIA Run:ai Model Streamer disminuye los tiempos de arranque en frío al transmitir pesos a la memoria GPU, con benchmarks en GP3, IO2 y S3.

Agilizar el acceso a cambios de contenido ISO-rating con Verisk Rating Insights y Amazon Bedrock

Verisk Rating Insights, impulsado por Amazon Bedrock, LLM y RAG, ofrece una interfaz conversacional para acceder a cambios ERC ISO, reduciendo descargas manuales y acelerando información precisa.

Cómo msg mejoró la transformación de la fuerza laboral de RR. HH. con Amazon Bedrock y msg.ProfileMap

Este artículo explica cómo msg automatizó la armonización de datos para msg.ProfileMap usando Amazon Bedrock para impulsar flujos de enriquecimiento impulsados por LLM, aumentando la precisión de la coincidencia de conceptos de RR. HH., reduciendo la carga de trabajo manual y alineándose con la UE A

Automatizar pipelines RAG avanzados con Amazon SageMaker AI

Optimiza la experimentación a la producción para Retrieval Augmented Generation (RAG) con SageMaker AI, MLflow y Pipelines, para flujos reproducibles, escalables y con gobernanza.

Despliega Inferencia de IA escalable con NVIDIA NIM Operator 3.0.0

NVIDIA NIM Operator 3.0.0 amplía la inferencia de IA escalable en Kubernetes, habilitando despliegues multi-LLM y multi-nodo, integración con KServe y soporte DRA en modo tecnología, con colaboración de Red Hat y NeMo Guardrails.